深度学习实践:K折交叉验证与L2正则化

60 浏览量

更新于2024-09-02

收藏 742KB PDF 举报

"动手学深度学习笔记,涉及K折交叉验证、L2范数正则化、二维互相关运算、特征图、感受野、1×1卷积层和卷积层与全连接层的对比"

在深度学习领域,理解和应用各种技术是至关重要的。本笔记主要关注了几个关键概念,它们在构建和优化深度学习模型时起着基础性的作用。

首先,K折交叉验证是一种有效的模型验证方法,特别是在数据有限的情况下。传统的做法是将数据集分为训练集和验证集,但这样可能会浪费大量数据。K折交叉验证通过将数据集划分为K个子集,每次用一个子集作为验证集,其余的K-1个子集用于训练,重复K次,确保每个子集都有机会作为验证集。这种方法能够更全面地评估模型性能,避免因单一验证集而产生的偏差。

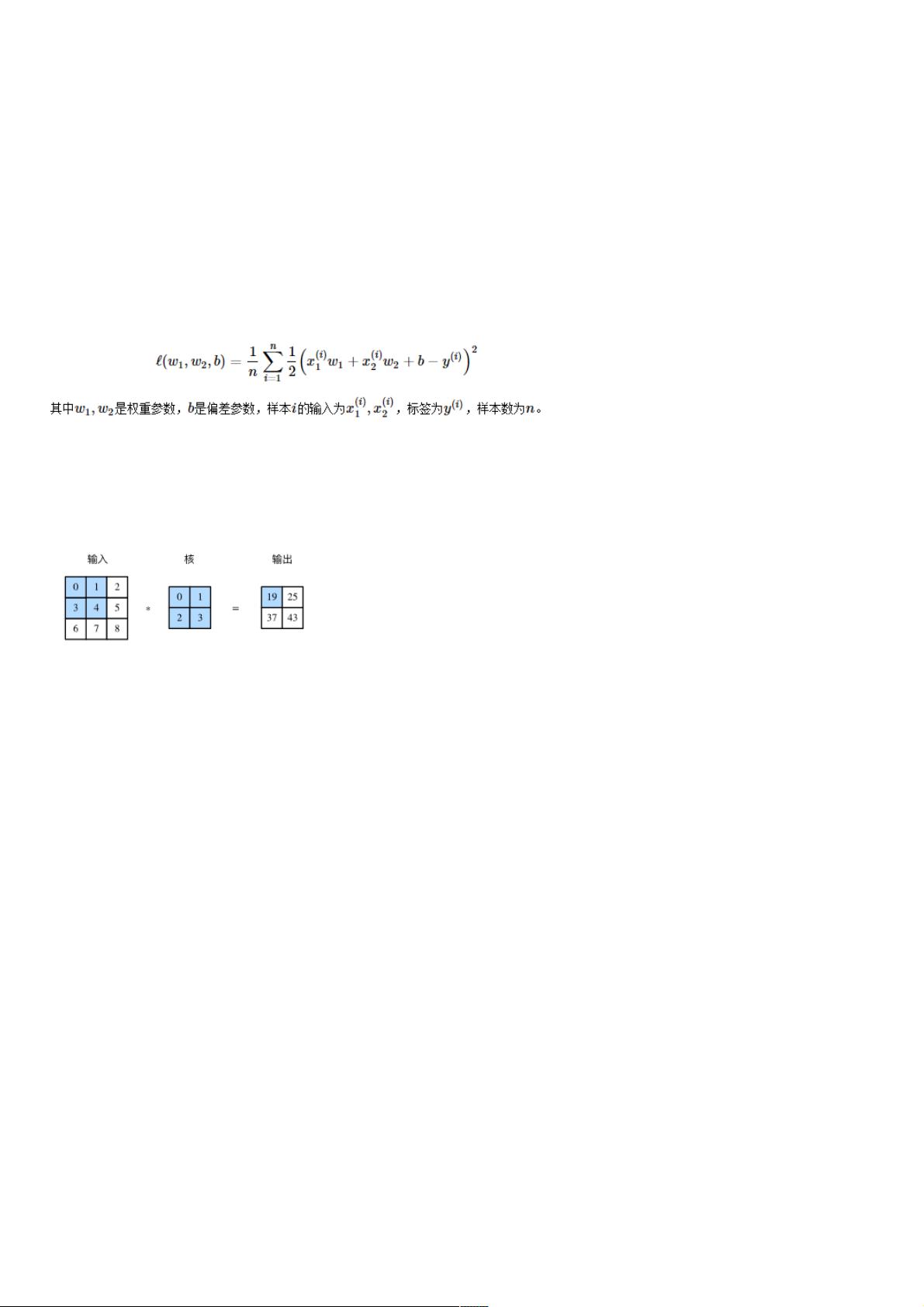

其次,L2范数正则化是防止模型过拟合的常用手段。在损失函数中加入L2范数惩罚项,即所有权重参数的平方和乘以一个正的常数,这使得模型在训练时不仅要最小化预测误差,还要尽量减小权重的大小。这样做的结果是抑制模型复杂度,避免模型过于依赖训练数据的噪声,提高泛化能力。

二维互相关运算在卷积神经网络(CNN)中扮演重要角色,它相当于卷积运算,但通常用于描述滤波器(卷积核)与输入数据的滑动匹配过程。卷积核在输入数组上滑动,计算每个位置的乘积和,生成输出特征图。这种操作允许模型捕获输入数据的空间特性。

特征图是卷积层的输出,表示输入数据在特定层次的抽象表示。每个特征图的元素对应于输入的一个特定感受野,即影响该元素计算的所有输入区域。感受野的概念帮助我们理解模型如何从局部区域提取特征。

1×1卷积层是CNN中的特殊形式,它主要用于调整通道数而非改变空间尺寸。尽管卷积核大小为1×1,但它在通道维度上进行操作,可以视为全连接层的变体,尤其是在处理多通道输入时,1×1卷积能有效地减少计算量和参数数量。

对比全连接层,卷积层具有显著优势。全连接层将所有输入连接到所有输出,可能导致模型过于复杂,特别是对于高分辨率图像。相反,卷积层保持输入的结构,通过共享权重和局部连接降低了模型复杂度,同时提高了模型对输入数据结构的敏感性。

总结来说,这些概念构成了深度学习实践的基础,无论是K折交叉验证的模型评估策略,还是L2正则化的模型优化技术,或是卷积运算在特征提取中的应用,都是深度学习模型设计和训练过程中不可或缺的工具。深入理解并熟练运用这些概念,对于提升模型性能和解决实际问题至关重要。

点击了解资源详情

203 浏览量

点击了解资源详情

135 浏览量

101 浏览量

158 浏览量

449 浏览量

177 浏览量

240 浏览量

weixin_38743054

- 粉丝: 8

- 资源: 942

最新资源

- Sane time.:合理的自动时间跟踪。-开源

- 一个简单的图库项目

- Nik_Collection_4.0.7.0_Multilingualx64.rar

- netfil:一个内核网络管理器,具有针对macOS的监视和限制功能。 #nsacyber

- SCAN_tests

- 图像浏览器

- C# MQTTNET示例

- music_edit:DOS音乐编辑器-开源

- 海岸线工具_python_

- 机器学习经典二分类数据集——马疝病数据集.zip

- redalert:不断测试所有内容-触发故障警报

- SAM:SAM是专门为维也纳大学计算机科学学院服务器设计的多功能Discord Bot

- SAP SuccessFactors Only: Display Full Name-crx插件

- POS票据打印机.zip

- Android-Bazel-Starter-Kotlin

- APx500_4.5.1_w_dot_Net 音频分析仪软件 apx515 apx525