Transformer在时序预测中的应用:ConvTrans算法解析

"本文将介绍如何利用Transformer架构进行时间序列预测,特别是ConvTrans算法,它在Transformer的基础上进行了改进,以适应时序数据预测,并解决了Transformer的扩展性问题。"

一、Transformer与时间序列预测

Transformer模型最初在自然语言处理(NLP)领域中引入,其创新的注意力机制使得模型能有效地处理长距离依赖,这对于处理序列数据,如时间序列预测,具有极大的潜力。传统的循环神经网络(RNN)或其变体如LSTM在捕获长期依赖时存在挑战,而Transformer的Multi-head Attention设计则能够同时考虑序列中的多个位置,这在时序预测中非常有用。

二、ConvTrans算法

ConvTrans是基于Transformer的一种时序预测模型,它克服了RNN和LSTM的一些局限性。尽管与DeepAR有相似之处,如都使用自回归概率预测和考虑协变量,但ConvTrans的关键区别在于:

1. **并行计算**:Transformer的架构允许并行计算,不同于RNN的序列依赖,ConvTrans可以并行处理多个时间步骤,大大提升了训练速度。

2. **时序局部性增强**:针对时序数据的特点,ConvTrans改进了Attention的计算,增强了模型对局部结构的敏感性,更准确地捕捉时序中的短期模式。

3. **内存效率**:Transformer通常面临内存瓶颈问题,ConvTrans提出了新的方法来缓解这个问题,使其更适合大规模时间序列数据的处理。

4. **多模态输入**:ConvTrans不仅考虑了历史时间序列数据,还可以接收额外的协变量信息,如环境因素或个体属性,以提升预测的准确性。

三、ConvTrans的工作原理

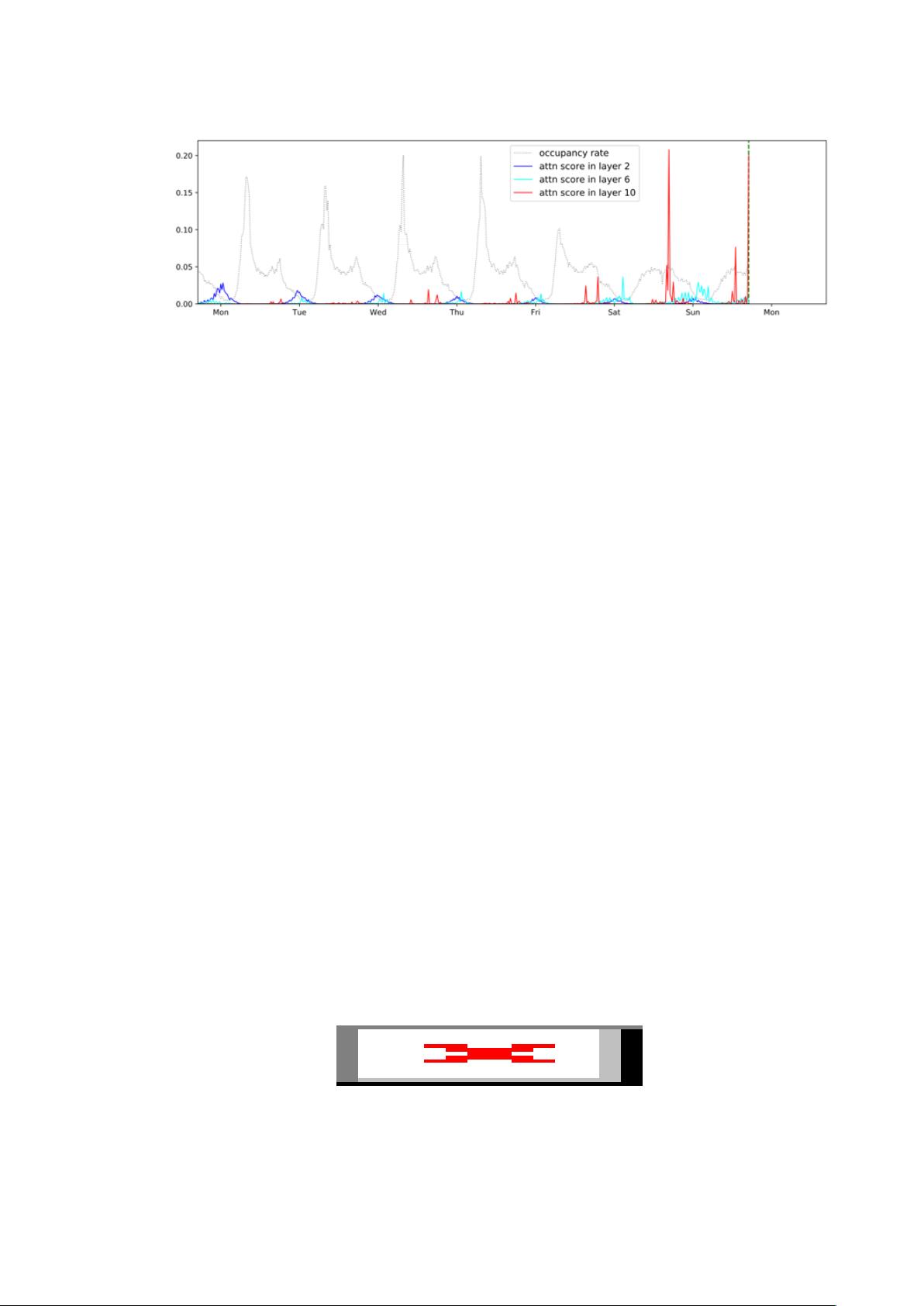

ConvTrans的核心是Transformer的注意力机制,它通过自注意力(self-attention)机制来建模时间序列中的关系。在时序预测任务中,模型不仅关注当前时间步,还关注过去的时间步,通过多头注意力机制,同时考虑不同时间步的贡献。此外,通过卷积操作,模型可以更好地捕获局部时序模式,增强对短期依赖的捕捉能力。

四、应用场景

ConvTrans适用于各种需要时间序列预测的场景,例如电力消耗预测、股票市场预测、天气预报、交通流量预测等。在这些领域,准确预测未来趋势可以帮助决策者提前规划,降低风险。

五、总结

ConvTrans通过引入Transformer架构并进行适应性的改进,为时序预测提供了一个强大的工具。它的并行计算能力、对局部结构的敏感性和对协变量的处理能力,使其在处理大规模、复杂时间序列数据时表现出色。对于那些需要快速、准确预测的业务和研究领域,ConvTrans都是一个值得考虑的解决方案。

2023-12-18 上传

2023-11-29 上传

2024-06-11 上传

2023-08-20 上传

2024-09-03 上传

2024-07-26 上传

红色荷包蛋

- 粉丝: 900

- 资源: 68

最新资源

- Java集合ArrayList实现字符串管理及效果展示

- 实现2D3D相机拾取射线的关键技术

- LiveLy-公寓管理门户:创新体验与技术实现

- 易语言打造的快捷禁止程序运行小工具

- Microgateway核心:实现配置和插件的主端口转发

- 掌握Java基本操作:增删查改入门代码详解

- Apache Tomcat 7.0.109 Windows版下载指南

- Qt实现文件系统浏览器界面设计与功能开发

- ReactJS新手实验:搭建与运行教程

- 探索生成艺术:几个月创意Processing实验

- Django框架下Cisco IOx平台实战开发案例源码解析

- 在Linux环境下配置Java版VTK开发环境

- 29街网上城市公司网站系统v1.0:企业建站全面解决方案

- WordPress CMB2插件的Suggest字段类型使用教程

- TCP协议实现的Java桌面聊天客户端应用

- ANR-WatchDog: 检测Android应用无响应并报告异常