Flume: 数据采集与预处理的关键工具

版权申诉

41 浏览量

更新于2024-07-02

3

收藏 3.84MB PDF 举报

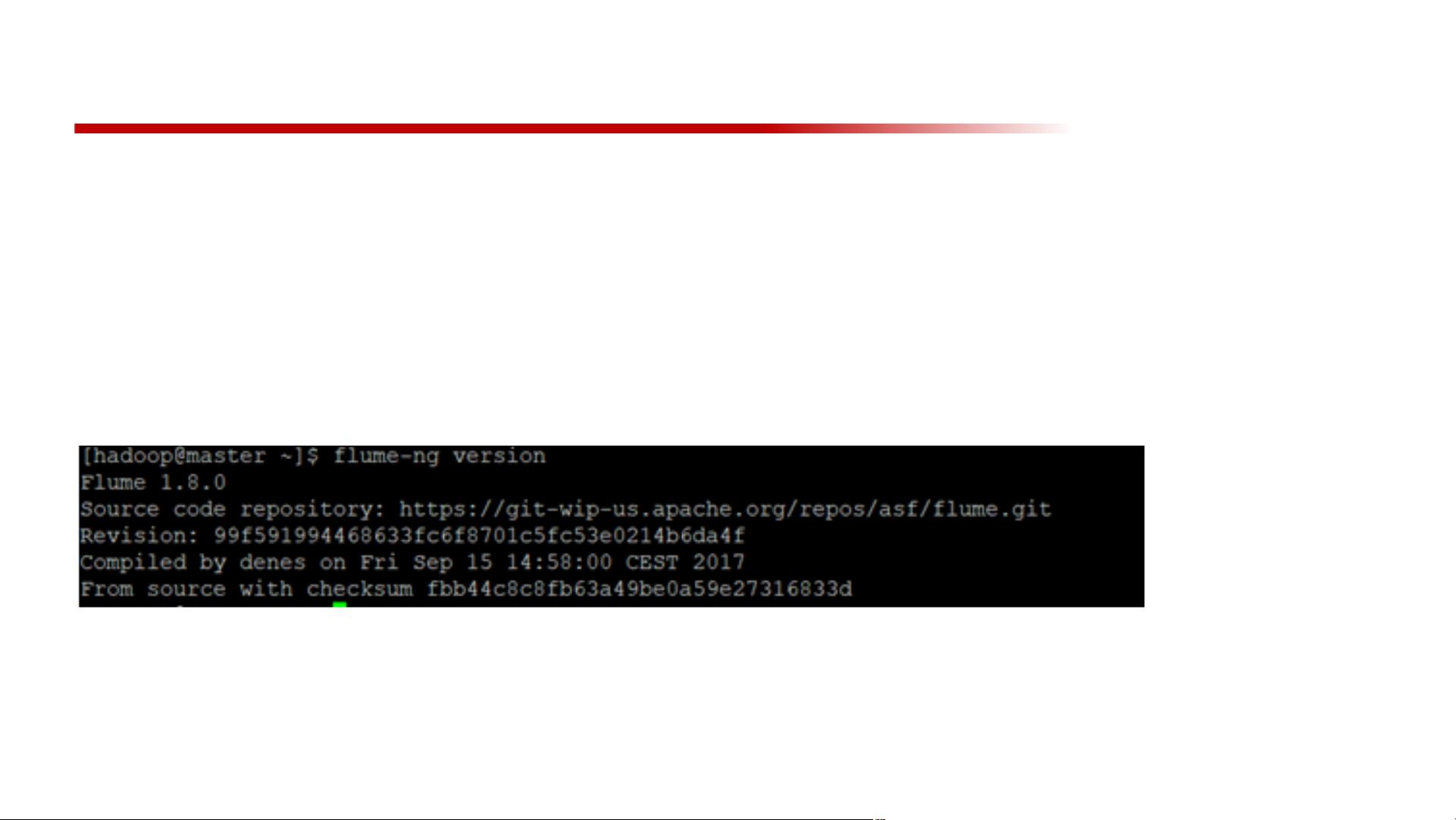

本资源是关于大数据基础中数据采集与预处理的重要章节,由华中科技大学软件学院提供。章节内容涵盖了流数据处理的关键工具和技术,特别是Apache Flume的深入解析。数据流被定义为动态、实时且持续增长的数据集合,适用于如卫星云图监测、股市分析、网络安全监控和传感器信号分析等多种场景。

Flume作为核心工具,它是一个分布式、高可靠和高可用的数据采集系统,能够从各种不同的源,如云端、社交媒体和网站,收集数据,并将其高效地传输到HDFS或HBase等集中式存储系统中。理解Flume的工作原理至关重要,这涉及到几个关键概念:

1. Flume事件:在Flume中,数据是以事件的形式传输的,每个事件由事件头(包括时间戳、源IP等结构化信息)和字节有效的事件体组成。这些事件可以携带原始数据或者额外的元数据,便于后续处理和分析。

2. Flume代理:代理是Flume的核心组件,它封装了事件的生命周期,包括事件源(从外部数据源读取事件)、事件通道(临时存储事件的地方)、事件槽(接收器,负责将事件导向最终目的地)以及事件的传递过程。

3. 源:外部数据源通过Flume源接口发送数据,如Web服务器或其他监控设备,将数据转换成Flume能识别的格式。

4. 通道:通道是Flume中数据暂存的区域,分为文件通道(持久化存储)和内存通道(快速但不持久)。事件在通道中传递,直到到达下一个代理或存储库,只有当存储成功后才会从通道中移除。

5. 数据传输流程:Flume遵循一个清晰的路径,从源头捕获数据,通过代理的各个组件,最后进入目标存储库,确保数据在传输过程中稳定和完整。

通过学习这些概念,读者可以掌握如何设计和实施一个有效的流数据采集和预处理方案,以便于后续的数据分析和挖掘工作。这份文档对于从事大数据处理、系统架构或数据分析的人员来说,具有很高的实用价值。

2022-12-24 上传

2022-11-12 上传

2021-05-29 上传

2022-12-24 上传

2022-10-30 上传

2022-11-11 上传

2021-11-23 上传

是空空呀

- 粉丝: 195

- 资源: 3万+

最新资源

- CoreOS部署神器:configdrive_creator脚本详解

- 探索CCR-Studio.github.io: JavaScript的前沿实践平台

- RapidMatter:Web企业架构设计即服务应用平台

- 电影数据整合:ETL过程与数据库加载实现

- R语言文本分析工作坊资源库详细介绍

- QML小程序实现风车旋转动画教程

- Magento小部件字段验证扩展功能实现

- Flutter入门项目:my_stock应用程序开发指南

- React项目引导:快速构建、测试与部署

- 利用物联网智能技术提升设备安全

- 软件工程师校招笔试题-编程面试大学完整学习计划

- Node.js跨平台JavaScript运行时环境介绍

- 使用护照js和Google Outh的身份验证器教程

- PHP基础教程:掌握PHP编程语言

- Wheel:Vim/Neovim高效缓冲区管理与导航插件

- 在英特尔NUC5i5RYK上安装并优化Kodi运行环境