前馈与反向传播:单层神经网络的关键步骤与梯度下降优化

需积分: 0 112 浏览量

更新于2024-08-05

收藏 1.33MB PDF 举报

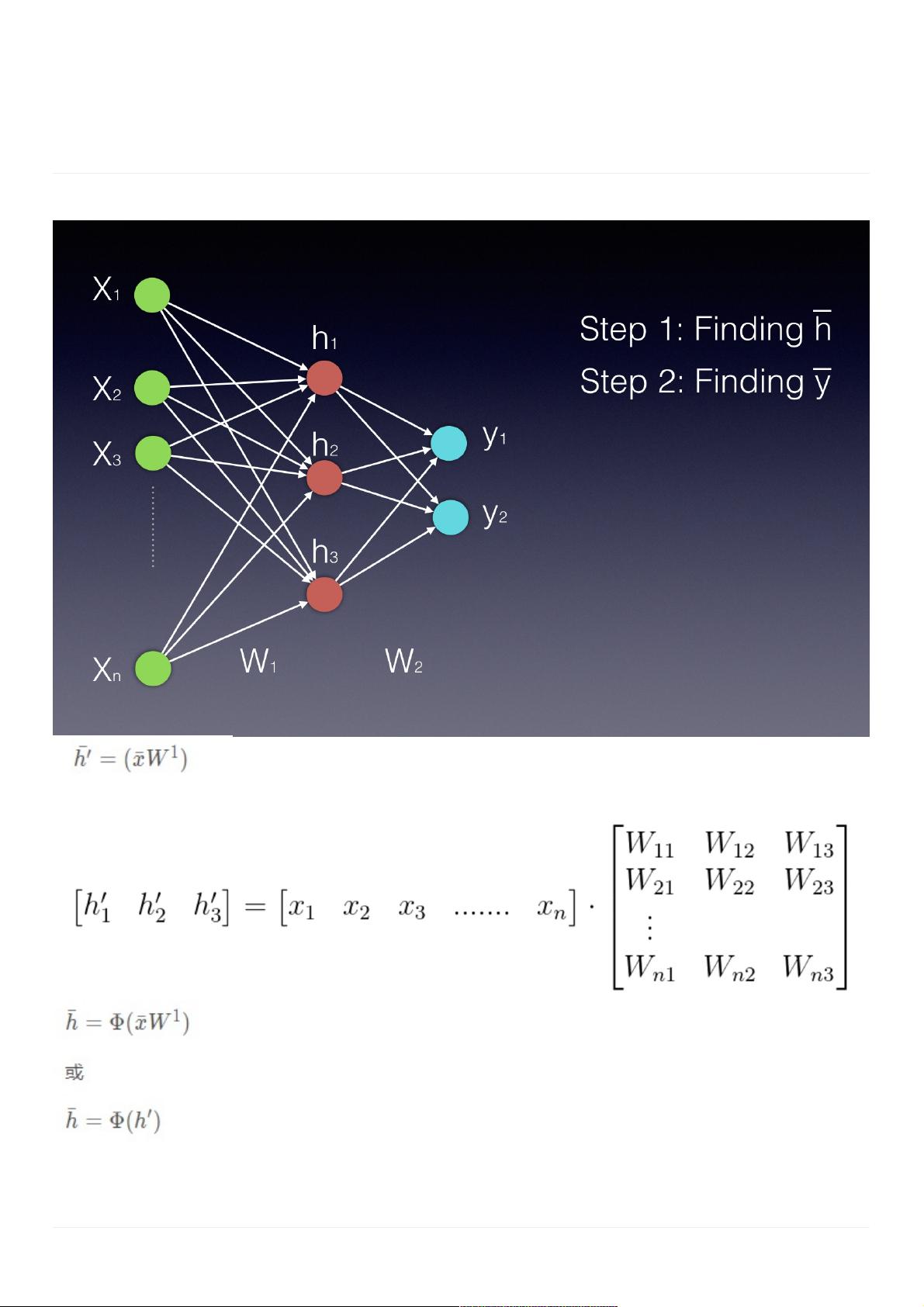

在深度学习中,前馈神经网络是一个关键概念,它是一种基本的结构,其中信息沿着网络单向传递,不形成循环。当我们处理单隐藏层的神经网络时,主要涉及两个关键步骤:前馈计算和反向传播优化。

前馈计算

首先,前馈阶段包括计算隐藏层的值。输入数据通过与权重矩阵W1相乘(这里的矩阵表示连接输入层与隐藏层之间的连接),得到隐藏层向量h。每个元素h_j 可以用以下公式表示:

\[ h_j = \sum_{i=1}^{n} W_{ij} \cdot x_i \]

这里的\( W_{ij} \) 是权重值,\( n \) 是输入神经元的数量,\( x_i \) 是输入向量的第i个元素,而\( h_j \) 是隐藏层第j个神经元的输出。激活函数如双曲正切、Sigmoid或ReLU被用来非线性地转换这些值,以便更好地捕捉复杂的关系。

误差函数与反向传播

接着,我们用一个合适的误差函数(如均方误差MSE或交叉熵)来评估模型的预测输出与实际标签之间的差距。在反向传播中,从输出层开始,计算每个节点的梯度,这是为了确定如何调整权重以减小误差。对于单个隐藏层,误差会逐层逆向传播到输入层。

对于任意层k,权重更新遵循梯度下降法则,其基本形式是:

\[ W_{kj}^{(new)} = W_{kj}^{(old)} - \alpha \cdot \frac{\partial E}{\partial W_{kj}} \]

其中,\( W_{kj}^{(new)} \) 是更新后的权重,\( \alpha \) 是学习率(一个小于1的正数),\( E \) 是误差函数,而\( \frac{\partial E}{\partial W_{kj}} \) 是梯度,表示权重变化对误差的影响。

梯度下降

梯度下降算法用于计算每个权重的最优更新方向。它通过迭代的方式调整权重,使得每一步都沿着使误差下降最快的方向前进。在反向传播过程中,我们会计算每一层的偏导数,然后根据学习率调整,直到网络的误差达到最小或满足预设停止条件。

总结来说,前馈神经网络的核心在于其前馈和反向传播的过程,它们共同作用于权重的优化,使得网络能够逐渐适应输入数据并进行准确的预测。通过理解这两个步骤,我们可以深入掌握神经网络的基本训练机制,并应用于各种实际问题中。

2022-07-14 上传

2021-10-02 上传

2022-07-14 上传

2021-10-01 上传

2021-09-30 上传

2021-09-29 上传

2023-09-14 上传

2023-05-23 上传

2021-05-07 上传

zh222333

- 粉丝: 37

- 资源: 296

最新资源

- ES管理利器:ES Head工具详解

- Layui前端UI框架压缩包:轻量级的Web界面构建利器

- WPF 字体布局问题解决方法与应用案例

- 响应式网页布局教程:CSS实现全平台适配

- Windows平台Elasticsearch 8.10.2版发布

- ICEY开源小程序:定时显示极限值提醒

- MATLAB条形图绘制指南:从入门到进阶技巧全解析

- WPF实现任务管理器进程分组逻辑教程解析

- C#编程实现显卡硬件信息的获取方法

- 前端世界核心-HTML+CSS+JS团队服务网页模板开发

- 精选SQL面试题大汇总

- Nacos Server 1.2.1在Linux系统的安装包介绍

- 易语言MySQL支持库3.0#0版全新升级与使用指南

- 快乐足球响应式网页模板:前端开发全技能秘籍

- OpenEuler4.19内核发布:国产操作系统的里程碑

- Boyue Zheng的LeetCode Python解答集