KNN算法详解与手写数字识别应用

PDF格式 | 344KB |

更新于2024-08-29

| 119 浏览量 | 举报

"本文主要介绍了K近邻法(KNN),一种基础的分类和回归算法,特别是关注其在手写数字识别的应用。文章探讨了KNN的模型构建、k值选择、距离度量以及分类决策规则,通过实例展示了如何利用KNN进行手写数字识别。"

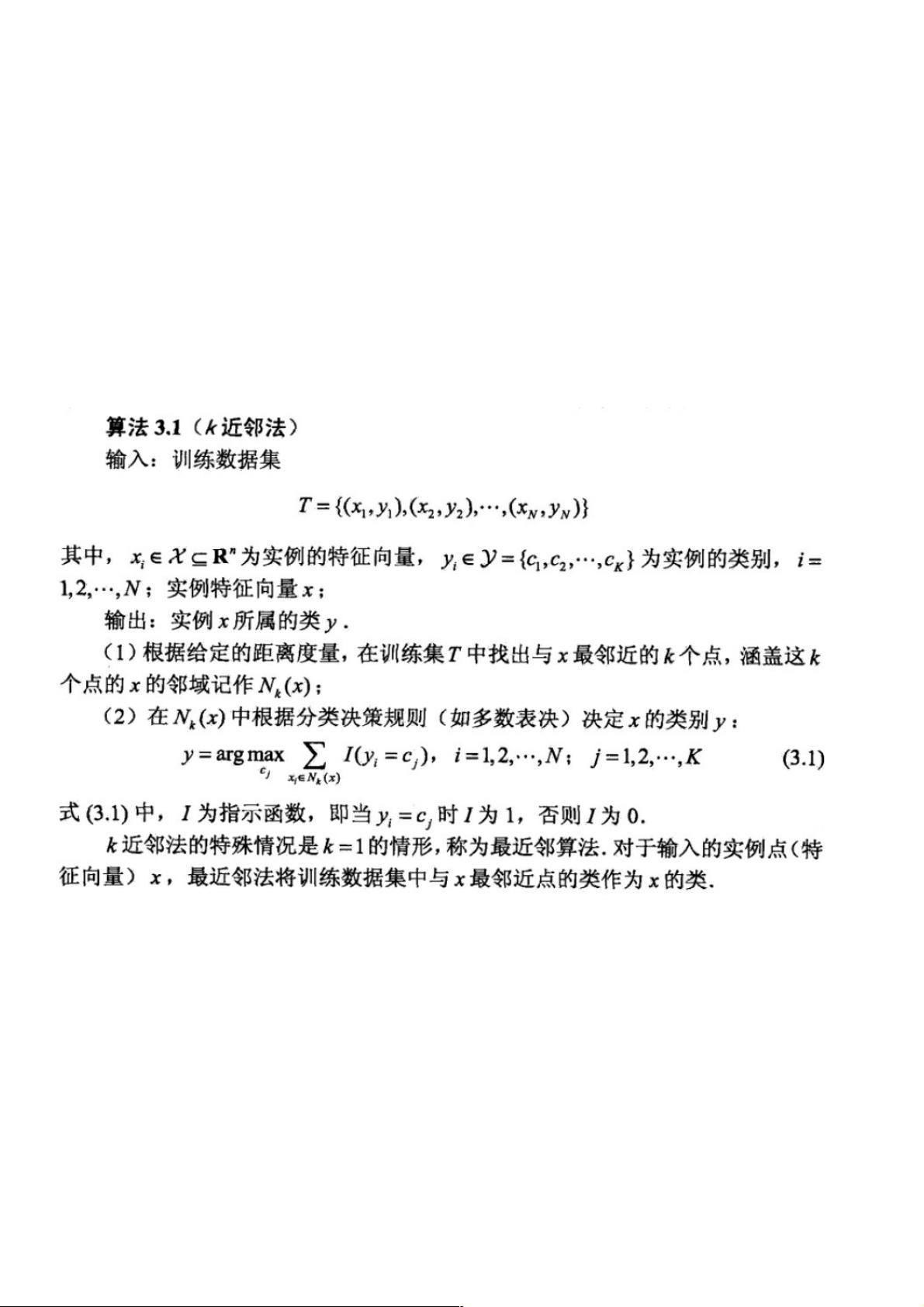

K近邻法(KNN)是一种非参数监督学习算法,主要用于分类任务。它不涉及任何预先的学习过程,而是基于训练数据集直接进行分类。KNN的基本思想是:对于一个新的输入实例,寻找训练集中与其最接近的k个邻居,根据这些邻居的类别信息决定新实例的类别。KNN算法的关键要素包括k值的选择、距离的计算以及确定分类结果的策略。

1. **k值选择**:k值是KNN算法中的一个重要参数,它决定了考虑的邻居数量。k值的选择直接影响到模型的复杂性和泛化能力。较小的k值(如k=1)可能导致模型过于敏感,容易受噪声点影响,而较大的k值则可以减少噪声影响,但可能引入不相关的样本,导致模型过于简单。实践中,k值通常通过交叉验证来优化。

2. **距离度量**:在KNN中,衡量样本间相似性的关键在于距离计算。常见的距离度量包括欧氏距离、曼哈顿距离、切比雪夫距离和余弦相似度等。欧氏距离是最直观的距离度量,适用于特征尺度相同的情况;而在特征尺度差异较大的情况下,其他度量可能更为合适。

3. **分类决策规则**:KNN算法通常采用多数投票原则,即选择k个邻居中出现次数最多的类别作为预测结果。对于并列情况,可能会有多种处理方式,例如选择最近的邻居类别,或者使用加权投票,距离更近的邻居权重更大。

在手写数字识别的应用中,KNN可以用于处理MNIST这样的数据集,其中每个实例是一个手写数字的图像,特征通常是图像的像素值。首先,需要将图像转化为特征向量,然后用KNN算法进行训练和测试。在测试阶段,新的手写数字图像会根据其与训练集中数字的相似度被分类。

总结来说,KNN算法凭借其简单性和直观性在许多领域都有应用,尤其是在数据挖掘和模式识别中。然而,它也有一些局限性,如计算复杂度高、对异常值敏感、需要合适距离度量等。因此,在实际应用中,需要结合具体问题选择合适的参数和距离度量,以提高模型的性能。

相关推荐

weixin_38720762

- 粉丝: 5

- 资源: 943

最新资源

- 哥伦布蓝衣队 新标签页 壁纸收藏-crx插件

- SRDebugger 1.11.0 插件

- first-spring-mvc:ihavenoideawhatimdoing.jpg

- Linux系统安装详细视频教程

- SLitraniSim:内置在rootSLitrani中的简单Quartz和PMT检测器

- 一维_用matlab编写的FDTD一维程序_

- 横向滚动鼠标插件Horwheel特效代码

- 基于MPC控制器的自行车行驶转弯控制真实场景模拟matlab仿真

- Spark-Parquet

- Color Terror-crx插件

- JDK1.8-win64 -安装包

- confTool培训

- html5点击购物车弹出商品清单特效代码

- Python爬虫~已爬取目标网站所有文章,后续如何只获取新文章项目源码有详细注解,适合新手一看就懂.rar

- Watterson信道_短波信道_watterson信道_

- react-github-search-user-api