TensorFlow网络模型压缩:量化与剪枝实践

需积分: 0 152 浏览量

更新于2024-06-30

收藏 2.25MB DOCX 举报

"AI2019_SA19225404_吴语港_Lab4_TF1.x1"

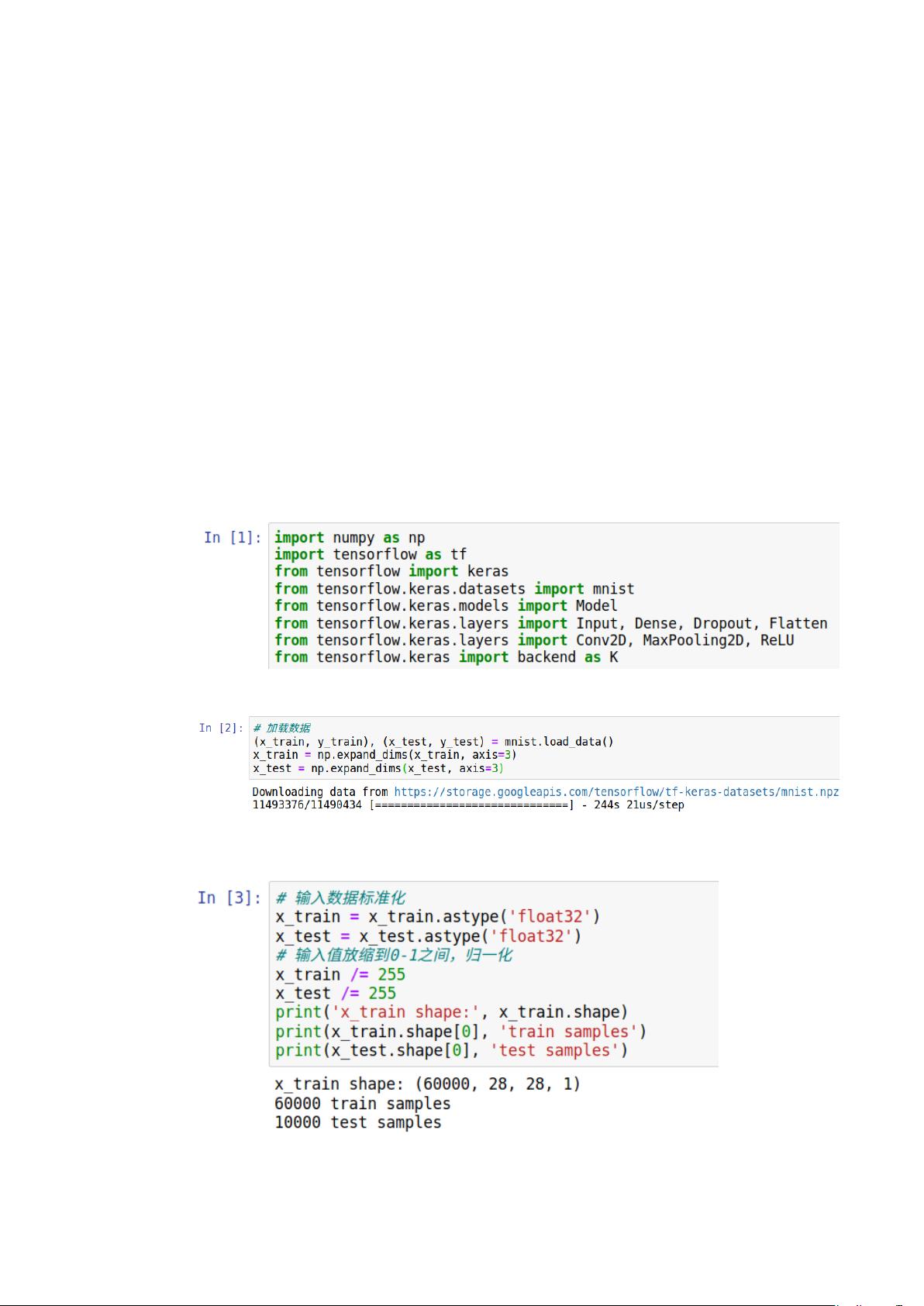

本实验报告聚焦于利用TensorFlow实现深度学习模型的压缩,特别是通过剪枝和量化技术。学生吴语港在2019年11月6日进行了这项实验,地点位于思贤楼301303实验室。

剪枝(Pruning)

剪枝是减少神经网络模型复杂度的一种有效方法,主要目的是删除那些对网络性能影响较小的参数。它包括正则化、修剪和增长等策略。正则化通过调整目标函数来鼓励更稀疏的参数解;修剪则直接删除多余的特征和参数;而增长则是从小型网络开始,逐渐增加结构。剪枝的实施通常包含以下步骤:评估神经元的重要性、删除不重要的神经元、微调网络、并重复这个过程。关键挑战包括确定剪枝的粒度、选择合适的剪枝方法、权值重要性的度量、去除的权值数量或比例的决定、何时进行剪枝以及在finetune后如何处理新产生的不重要权值。

量化(Quantization)

量化是另一种模型压缩技术,它通过降低参数的精度来减少模型的存储需求。传统的神经网络参数通常使用32位浮点数表示,但许多情况下并不需要这么高的精度。通过量化,可以将这些参数表示为更短的位数,如8位甚至更低。例如,SGD在保持精度的同时,只需要6到8位的精度。量化策略包括二值量化、三值量化和多值量化。二值网络(如XNOR网络)通过使用1位表示权重和输入,既减小了模型大小,又通过位运算替代复杂的卷积操作,提高了执行速度。然而,二值网络可能导致模型表达能力下降,因此研究者开始探索n位编码以维持模型的复杂性和性能。

实验目标是通过剪枝和量化来实现TensorFlow网络的压缩,从而减少模型的存储需求和提高运行效率。实验中可能涉及了如何有效地执行这些技术,如权重的量化方法、计算二值权重梯度的策略以及保证量化后模型精度的方法。这是一次深入理解深度学习模型压缩原理和实践的重要实践,对于提升模型的部署效率具有重要意义。

点击了解资源详情

435 浏览量

2036 浏览量

2022-08-08 上传

807 浏览量

269 浏览量

葡萄的眼泪

- 粉丝: 21

最新资源

- Python编程在测试人员中的应用:Mantis缺陷跟踪器教程

- Python pyltp 工具包安装指南

- JSON模式模型的安装与使用解析

- C#2013实现TCP/IP协议的Socket通信编程

- 仿IOS风格的HTML5手机端时间选择器实现

- MIRACL库5.5.4与7.0.1版本及完整使用手册和头文件下载

- 深入理解Spring Cloud Netflix与Fegin-Hx的实践

- Python环境下Web计算器开发指南

- Dart版Sass:让CSS设计变得充满乐趣

- bigbox-web: 强大的前后端SPA框架核心模块

- Minecraft命令框架实现:带有Tab补全功能的Java插件

- 使用Keras进行深度学习图像分类的Python教程

- Spring与Mybatis整合教程:纯净项目搭建与源码

- Notepad++ JSON 插件的安装与使用指南

- 详解commons-fileupload和commons-io包的文件上传功能

- Oracle数据库表结构转Word自动化工具介绍