深度学习基石:CS231n神经网络笔记2-数据预处理与模型设定

需积分: 0 42 浏览量

更新于2024-08-05

收藏 1.43MB PDF 举报

"这篇是斯坦福大学CS231n课程关于神经网络的笔记第二部分,主要涵盖了数据预处理、权重初始化、批量归一化、正则化、损失函数等关键概念。译者对原文进行了翻译和校对,旨在帮助读者深入理解神经网络的构建和优化方法。"

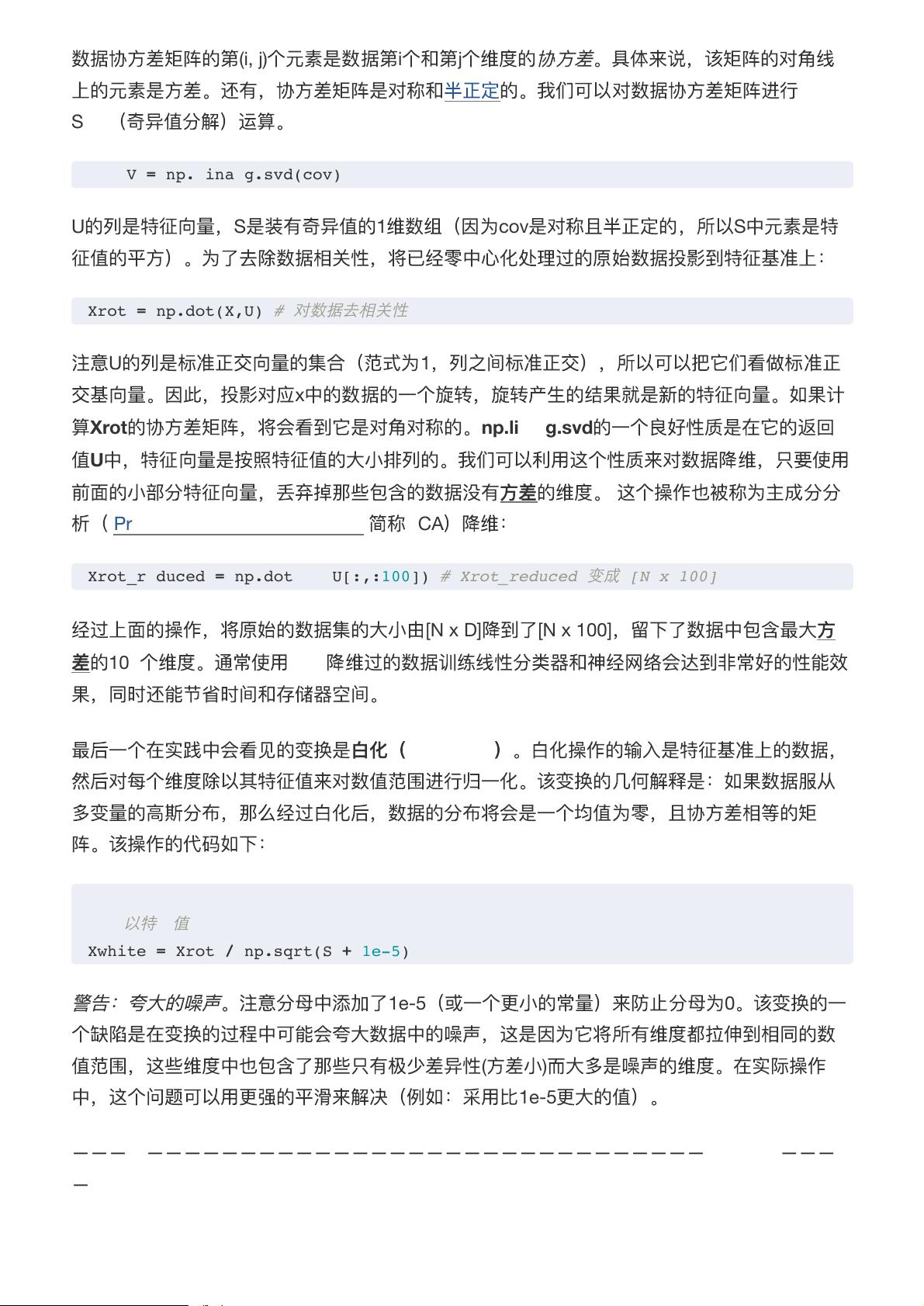

在神经网络的学习中,数据预处理是一个至关重要的步骤,因为它能显著影响模型的训练效果和收敛速度。预处理通常包括三个主要方法:

1. **均值减法**:这是最常见的数据预处理方式,通过减去每个特征的平均值,使数据集的均值为零。这有助于减少数据的中心偏移,使得数据云更接近原点。在Python的numpy库中,可以使用`X -= np.mean(X, axis=0)`来实现这一操作。对于图像数据,通常会全局减去图像的平均像素值,或者按颜色通道分别减去。

2. **归一化**:归一化的目标是让数据的各个维度具有相似的尺度。有两种常见的方法:

- **零中心化后标准化**:首先进行均值减法,然后除以标准差,使得每个维度的数据分布接近标准正态分布。代码实现为`X /= np.std(X, axis=0)`。

- **范围归一化**:将每个特征的值缩放到[1, -1]之间,适用于不同特征具有不同数值范围的情况。这种归一化可能在图像数据中不那么必要,因为像素值通常在0-255之间。

数据预处理的重要性在于,合适的预处理可以提高模型的泛化能力,降低训练难度,以及帮助优化算法更快地找到全局最优解。此外,笔记还提到了其他与模型设计相关的技术:

- **权重初始化**:初始化权重对于神经网络的训练至关重要,因为不当的初始权重可能导致梯度消失或梯度爆炸。不同的初始化策略如Xavier初始化或He初始化可以根据激活函数的性质来选择。

- **批量归一化(Batch Normalization)**:批量归一化在每一层的激活函数之后进行,通过规范化内部层的输出,加速训练并提高模型的稳定性和性能。

- **正则化**:正则化是防止过拟合的手段,包括L1和L2正则化、最大范数限制以及Dropout。这些方法在损失函数中添加惩罚项,限制模型复杂度,促进泛化能力。

- **损失函数**:损失函数衡量模型预测与实际标签之间的差异,如交叉熵损失用于多类分类,均方误差用于回归问题。选择适当的损失函数对模型优化至关重要。

这些技术和方法构成了神经网络训练的核心组成部分,理解和应用它们是构建高效、稳健的神经网络模型的关键。

2022-08-03 上传

2022-08-03 上传

2022-08-03 上传

2022-08-03 上传

2022-08-03 上传

2022-08-03 上传

2022-08-03 上传

2022-08-03 上传

2022-08-03 上传

高中化学孙环宇

- 粉丝: 15

- 资源: 338

最新资源

- 单片机串口通信仿真与代码实现详解

- LVGL GUI-Guider工具:设计并仿真LVGL界面

- Unity3D魔幻风格游戏UI界面与按钮图标素材详解

- MFC VC++实现串口温度数据显示源代码分析

- JEE培训项目:jee-todolist深度解析

- 74LS138译码器在单片机应用中的实现方法

- Android平台的动物象棋游戏应用开发

- C++系统测试项目:毕业设计与课程实践指南

- WZYAVPlayer:一个适用于iOS的视频播放控件

- ASP实现校园学生信息在线管理系统设计与实践

- 使用node-webkit和AngularJS打造跨平台桌面应用

- C#实现递归绘制圆形的探索

- C++语言项目开发:烟花效果动画实现

- 高效子网掩码计算器:网络工具中的必备应用

- 用Django构建个人博客网站的学习之旅

- SpringBoot微服务搭建与Spring Cloud实践