SVM基础:硬间隔与对偶优化在支持向量机中的应用

需积分: 0 62 浏览量

更新于2024-08-05

1

收藏 1.59MB PPTX 举报

支持向量机(SVM)是监督学习领域的一种强大工具,尤其在二分类问题中表现出色。它的核心思想是寻找一个能够最大化类别间距离的超平面,以实现最佳的分类效果。SVM的关键概念包括:

1. 间隔与支持向量:

- 间隔(Margin)是指两类样本点到超平面的最短距离,它是SVM优化的目标,通常希望间隔越大,泛化能力越强。

- 支持向量(Support Vector)指的是那些距离超平面最近的样本点,它们决定了超平面的位置和模型的鲁棒性。

2. 决策边界:

- 超平面是二分类的决策边界,它被设计用来最大化类别间的分离,确保新数据的分类准确性。

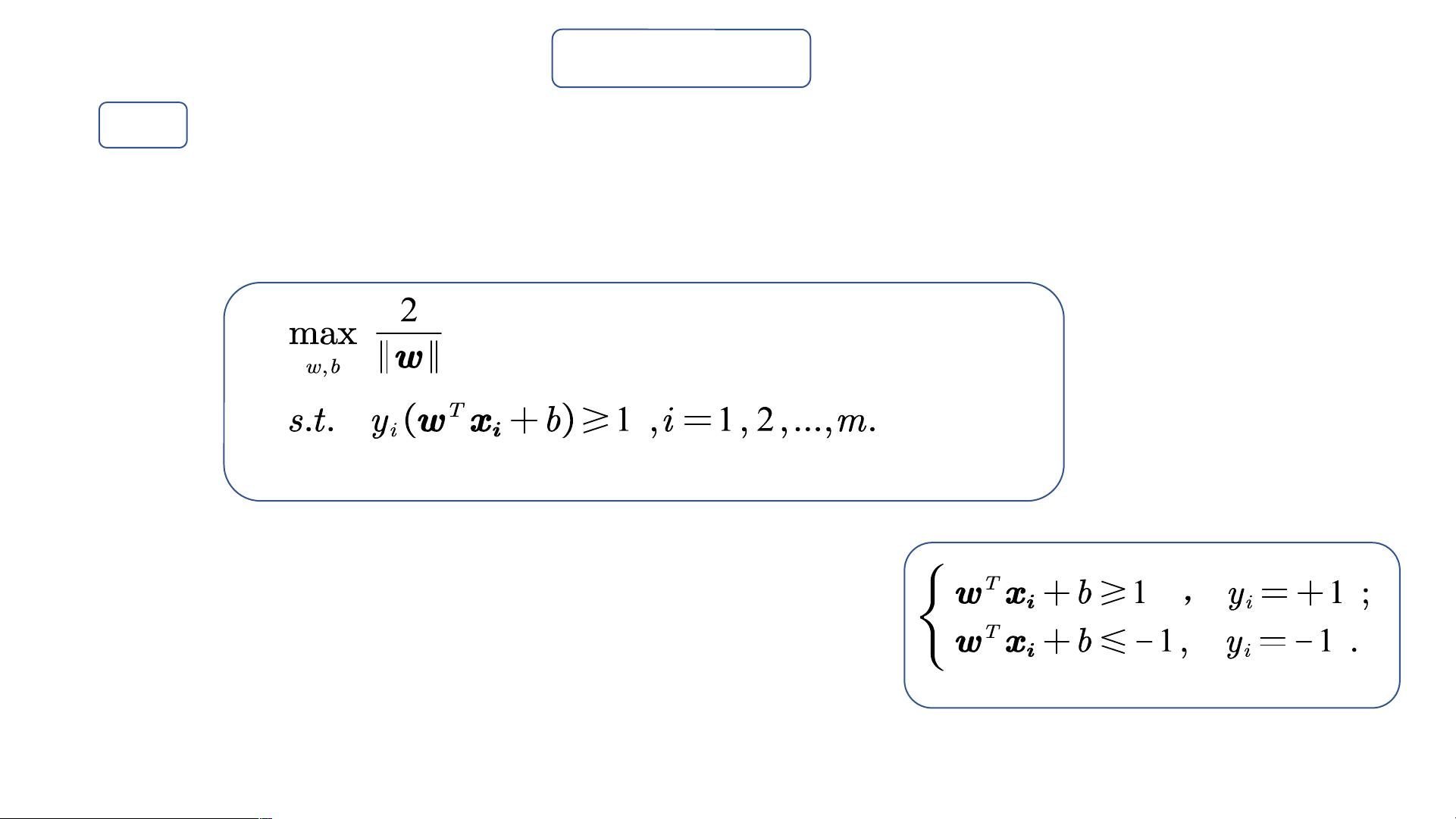

3. 优化问题:

- SVM原始问题是一个凸二次规划问题,但通常通过转化为对偶问题来求解,这是因为对偶问题通常更容易处理,且能找到全局最优解。对偶问题的优化涉及到拉格朗日乘子和KKT条件,即Karush-Kuhn-Tucker条件,这些条件是找到全局最优解的重要准则。

4. 核技巧(Kernel Trick):

- 当数据线性不可分时,SVM利用核函数将低维数据映射到高维特征空间,使得原本线性不可分的数据在更高维度下变得线性可分。常用的核函数如线性核、多项式核、径向基函数(RBF)核等,确保模型能够在非线性数据上有效工作。

5. 硬间隔与软间隔:

- 硬间隔SVM严格要求所有样本点到超平面的距离大于等于间隔的一半,可能导致过拟合。而软间隔SVM引入松弛变量,允许部分样本点距离超平面稍小,从而提高模型的泛化性能。

支持向量机通过巧妙地处理间隔最大化问题和利用核技巧,提供了一种有效的二分类模型,特别适用于小样本、非线性和高维数据集。理解和掌握这些核心概念和技术对于实际应用SVM至关重要。

2008-10-01 上传

点击了解资源详情

2010-04-21 上传

2023-06-19 上传

2021-10-07 上传

点击了解资源详情

天天写点代码

- 粉丝: 229

- 资源: 5

最新资源

- 人工智能基础实验.zip

- chkcfg-开源

- Amaterasu Tool-开源

- twitter-application-only-auth:Twitter仅限应用程序身份验证的简单Python实现。

- 第一个项目:shoppingmall

- webpage-test

- JTextComponent.rar_Applet_Java_

- 人工智能原理课程实验1,numpy实现Lenet5,im2col方法实现的.zip

- PyPI 官网下载 | vittles-0.17-py3-none-any.whl

- Real-World-JavaScript-Pro-Level-Techniques-for-Entry-Level-Developers-V-:实际JavaScript的代码存储库

- Sitecore.Support.96670:修补程序解决了以下问题:选中“相关项目”复选框时,并非所有子项目都会发布,

- BioGRID-PPI:生物二进制PPI数据集和BioGRID的处理

- ownership-status:所有权状态页

- DMXOPL:用于末日和源端口的YMF262增强的FM补丁集

- VideoCapture.rar_视频捕捉/采集_Visual_C++_

- trd_mc:一个简单的蒙特卡洛TPX响应仿真引擎。专为ROOT互动模式