Impala与HDFS交互:数据访问与优化揭秘

112 浏览量

更新于2024-08-28

收藏 510KB PDF 举报

"Impala是一个面向大规模数据分析的高性能OLAP引擎,它不直接存储数据,而是通过与HDFS、HBase、Kudu等第三方存储引擎交互来处理数据。Impala支持多种文件格式,如Parquet、TEXT、avro和sequencefile,但对HDFS文件的更新操作支持有限。本文重点探讨了Impala访问HDFS的三个主要方面:数据查询、数据插入和数据操作,并深入分析了Impala在查询执行过程中如何从HDFS获取数据,特别是HdfsScanNode的实现。

数据分区在Impala的高效运行中起着关键作用。在查询执行的前端,查询会被解析并转化为物理执行计划,然后分割成多个Fragment。这些Fragment会根据数据的本地性原则被分配到与DataNode相同机器上的Impalad节点执行,以最大化I/O效率。Impala需要知道每个文件的具体存储位置,以便正确地分配任务。这一过程涉及到Catalogd节点,它维护整个系统的元数据,包括表、分区和文件位置等信息。

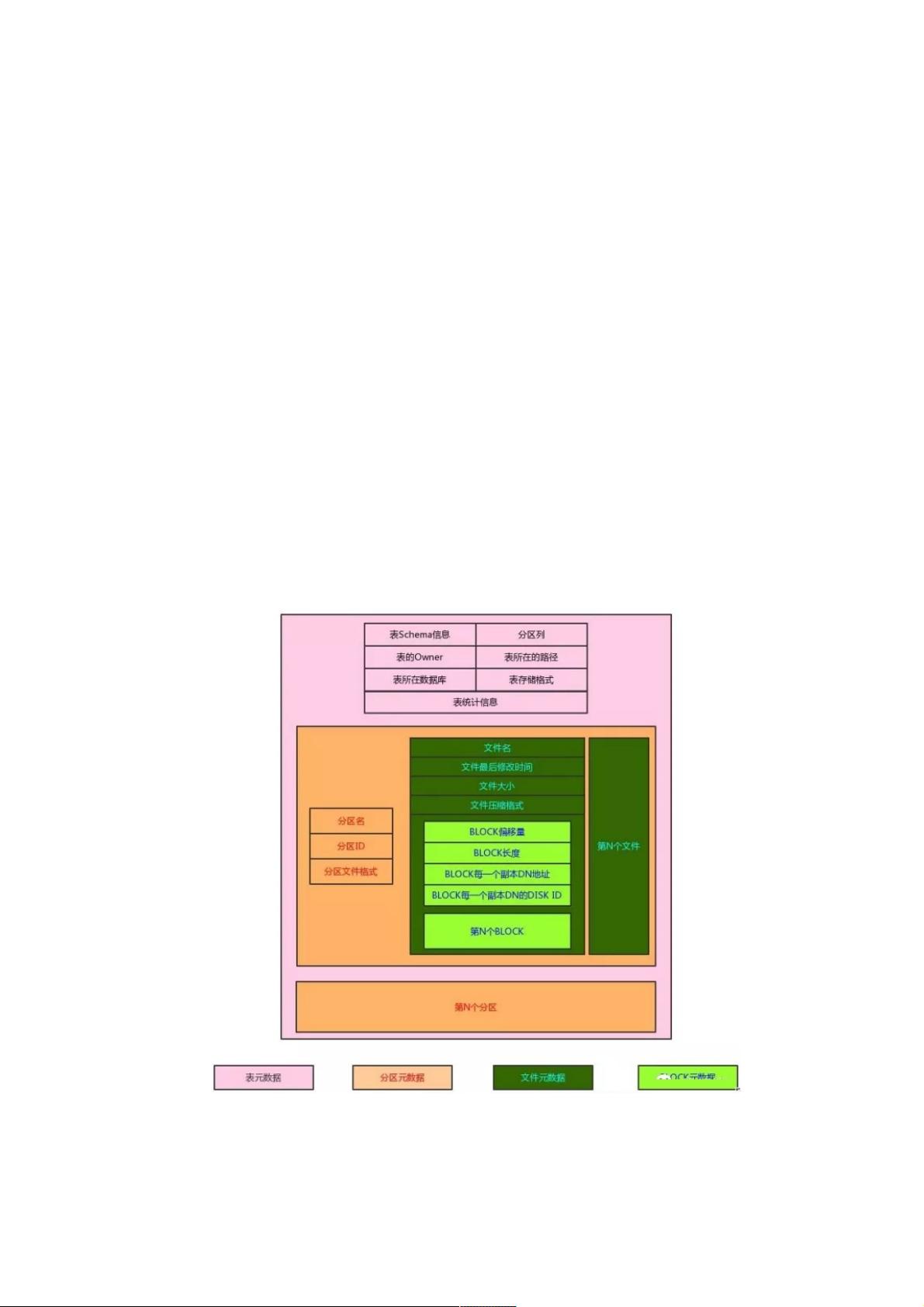

Impala的元数据结构层次分明,每个表包含分区信息,而分区又包含了具体的文件信息。当Impala执行查询时,它首先通过Catalogd获取表和分区的元数据,然后根据这些信息确定数据的分布情况,将Fragment有效地分配到各个后端Impalad节点。每个节点会负责处理一部分数据分片,实现并行计算。

在数据查询阶段,Impala的HdfsScanNode是数据读取的关键组件。HdfsScanNode直接与HDFS交互,读取特定文件格式的数据。对于Parquet这种列式存储格式,Impala能充分利用其特性,如列存压缩和预过滤,从而大大提高查询性能。此外,Impala还利用数据的局部性,尽可能让数据读取发生在数据实际存储的节点上,减少网络传输,进一步提升查询速度。

在数据写入(插入)方面,Impala支持向HDFS上的表插入新数据,但这通常涉及全表扫描或基于分区的插入操作,因为HDFS的更新操作不支持直接修改已有数据块。因此,Impala通常采用批量插入或者在新的数据文件中追加数据。

至于数据操作,如重命名和移动文件,Impala提供了相应的DML语句来支持这些操作,但需要注意的是,这些操作可能会影响到查询计划和元数据的一致性,因此需要谨慎使用。

Impala的高性能主要得益于其优化的查询执行策略、对数据分区的智能利用以及对高效文件格式(如Parquet)的支持。通过对HDFS数据访问的精细控制,Impala能够提供快速的在线分析处理能力,满足大规模数据分析的需求。

weixin_38557670

- 粉丝: 3

最新资源

- React.js实现的简单HTML5文件拖放上传组件

- iReport:强大的开源可视化报表设计器

- 提升代码整洁性:Eclipse虚线对齐插件指南

- 迷你时间秀:个性化系统时间显示与管理工具

- 使用ruby-install一次性安装多种Ruby版本

- Logality:灵活自定义的JSON日志记录器

- Mogre3D游戏开发实践教程免费分享

- PHP+MySQL实现的简单权限账号管理小程序

- 微信支付统一下单签名错误排查与解决指南

- 虚幻引擎4实现的多边形地图生成器

- TouchJoy:专为触摸屏Windows设备打造的屏幕游戏手柄

- 全方位嵌入式开发工具包:ARM平台必备资源

- Java开发必备:30个实用工具类全解析

- IBM475课程资料深度解析

- Java聊天室程序:全技术栈源码支持与学习指南

- 探索虚拟房屋世界:house-tour-VR应用体验