深度学习在手写数字识别中的应用——CNN与KNN算法比较

需积分: 0 174 浏览量

更新于2024-08-05

收藏 704KB PDF 举报

"DigitRecognizer手写数字识别实验报告,对比了CNN和KNN算法的效果,其中CNN表现最佳,正确率达到0.99086。实验中使用Tensorflow构建了一个CNN模型,模仿MINST网络结构,详细描述了网络设计,包括卷积核的选择、ReLU激活函数和MaxPooling的作用。"

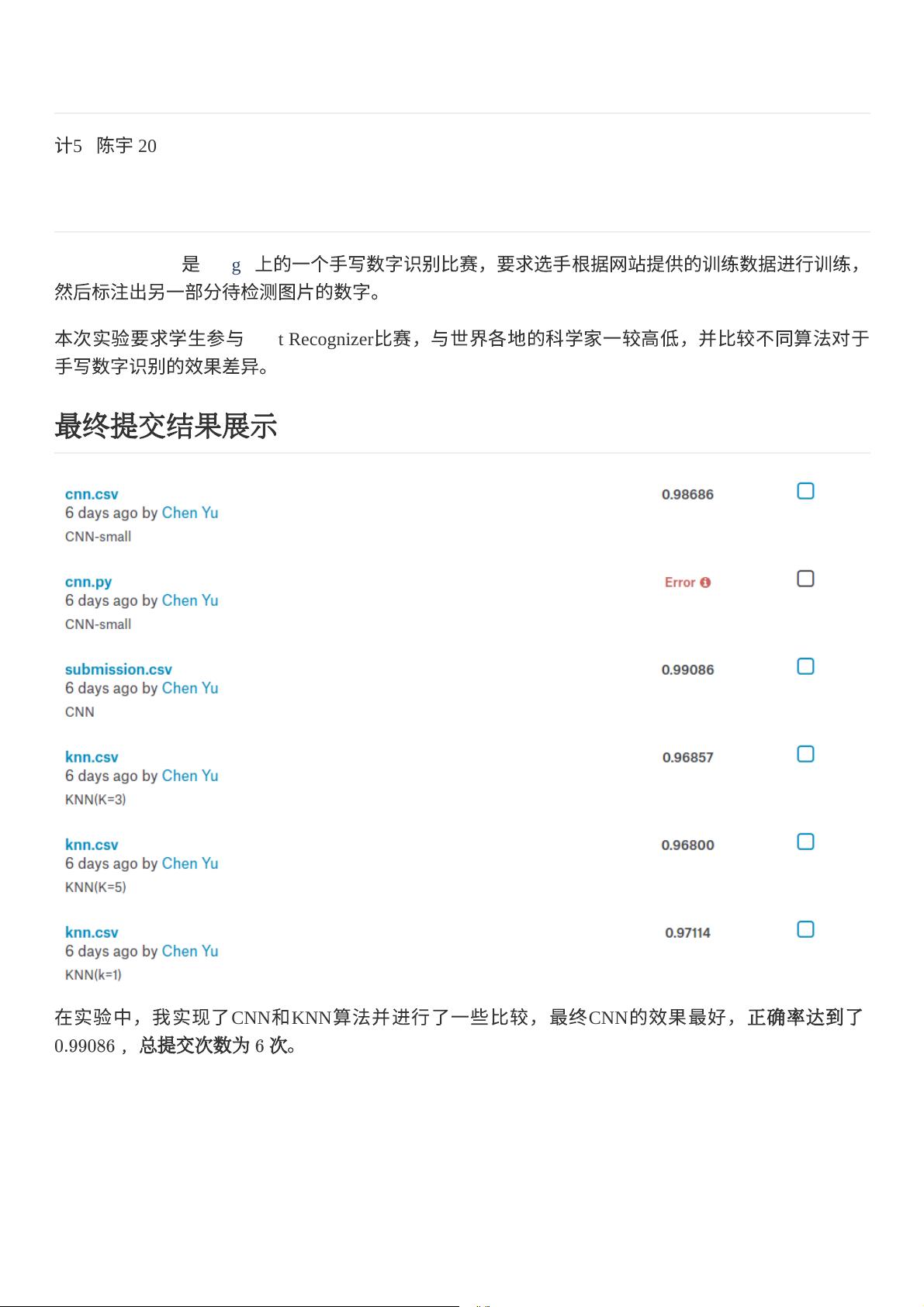

这篇实验报告主要探讨了在Kaggle平台上的DigitRecognizer比赛,目标是识别手写数字。参赛者需基于提供的训练数据训练模型,然后对未知图片进行分类。实验者采用了两种不同的算法:卷积神经网络(CNN)和K近邻(KNN),并对它们进行了性能比较。

首先,实验结果显示,CNN在手写数字识别任务上表现出色,经过一整晚的训练,模型的正确率高达0.99086,提交了6次结果。相对而言,KNN的性能稍逊一筹,尽管KNN在运行速度上较快,但随着K值的增加,正确率并没有显著提升,最高达到的是K=1时的0.97114。

在CNN模型的设计上,实验者采用了Tensorflow框架,构建了一个类似MINST数据集网络结构的模型。输入图像先通过reshape操作转换为28x28大小,随后使用32个5x5大小的卷积核进行卷积。选择5x5的卷积核是为了保持模型的鲁棒性,应对图像的旋转和平移,同时避免过大的卷积核可能导致特征混合和过拟合问题。卷积后,通过ReLU激活函数,该函数模拟生物神经元的激活过程,将负值置零,引入非线性特性。

接着,数据经过一个2x2的MaxPooling层,该层以2x2窗口对数据进行下采样,选取最大值,起到增强模型对图像平移不变性的效果。实验者指出,多层卷积与MaxPooling的组合能更好地提取和处理图像特征。

报告中虽未详细展开后续层的设计,但可以推断,实验者可能增加了更多的卷积层和池化层以提高模型的复杂性和表达能力,最后通过全连接层进行分类决策。

这个实验揭示了在手写数字识别任务中,深度学习模型如CNN相对于传统机器学习方法如KNN的优势,同时展示了模型设计的关键要素,如卷积核大小的选择、激活函数的运用以及池化层的作用。通过这样的对比,可以为今后类似的图像识别任务提供参考和优化思路。

821 浏览量

点击了解资源详情

147 浏览量

139 浏览量

303 浏览量

177 浏览量

2022-01-11 上传

邢小鹏

- 粉丝: 34

- 资源: 327

最新资源

- 2013年 " 蓝桥杯 "第五届全国软件和信息技术专业人才大赛 嵌入式设计与开发项目模拟试题——·双路输出控制器·代码.zip

- CookingApp_v1

- 国际象棋

- 图形窗口生成器 fig.m,版本 3.1:打开具有指定大小的新图形窗口-matlab开发

- front-end-samples:前端样本

- 电路方面的仿真操作 资料

- AR256_Demon_killers:预测棉花的未来价格趋势并提出合适的价格模型并缩小买卖双方之间的差距(SIH-2020)

- My-OOP-endterm-project:Bakhytzhan SE-2016

- rest:基于 https 的流星休息

- EI会议海报可编辑模板,高效解决新手小白对不知道如何制作海报的困惑

- 保险行业培训资料:一诺千金产品基础班

- state-csv.zip

- 图书馆应用

- 带有 3D 误差条的简单条形图:带有 3D 误差条的简单条形图。-matlab开发

- 保险公司讲师邀请函版本

- tamplated-road-trip