Spark集群配置指南:Ubuntu与Hadoop环境

需积分: 0 105 浏览量

更新于2024-08-04

收藏 1.99MB DOCX 举报

"Spark集群配置1,涉及环境包括Ubuntu、Hadoop、Scala以及JDK,并需要SSH设置。提供了Scala的下载链接以及配置环境变量、安装Scala和Spark的基本步骤。"

在搭建Spark集群时,首先需要一个合适的运行环境。在这个配置过程中,提到了以下四个主要组件:

1. Ubuntu操作系统:Ubuntu是基于Debian的Linux发行版,常被用作服务器操作系统,特别是对于大数据处理工具如Spark而言,它提供了一个稳定且易管理的基础平台。

2. Hadoop:Hadoop是Apache软件基金会的一个开源框架,用于存储和处理大规模数据。Spark可以很好地与Hadoop集成,利用其分布式文件系统HDFS进行数据读写。

3. Scala编程语言:Spark主要是用Scala编写的,因此在安装Spark之前,需要在系统上安装Scala环境。提供的链接指向了Scala 2.10.4的下载页面,但请注意,Spark可能需要更高版本的Scala,例如2.11.x。

4. JDK:Java Development Kit是运行Java应用程序的必备组件,Spark和Scala都是基于Java的,因此需要安装JDK来编译和运行Spark程序。

配置步骤主要包括:

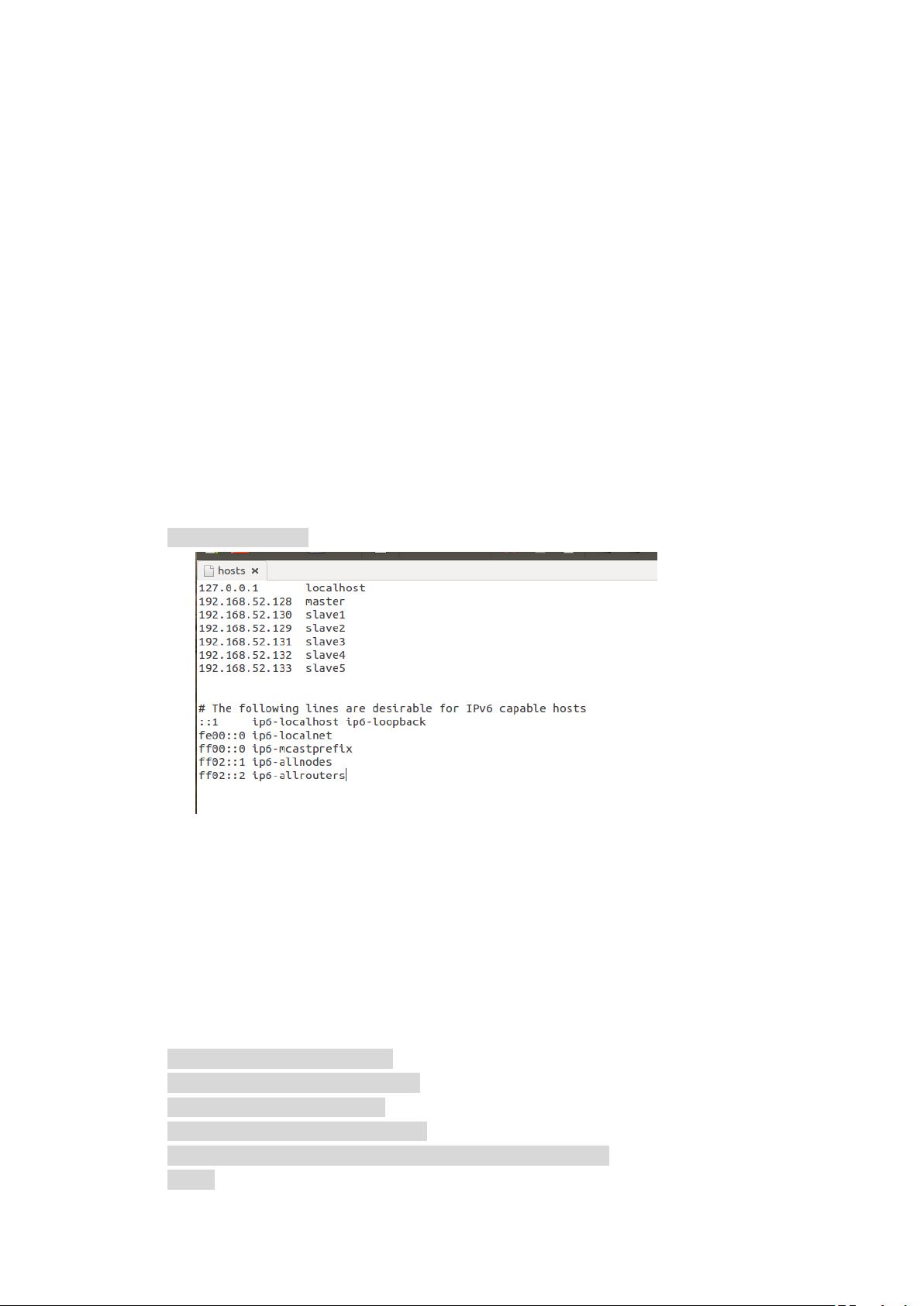

1. 前期准备:确保所有集群节点间可以通过SSH无密码互访,这通常通过SSH密钥对配置实现。同时,确保所有机器在同一个网络中,并在`/etc/hosts`文件中添加节点间的IP和主机名映射,以便于相互识别。

2. 环境变量设置:在系统级配置文件`/etc/profile`中添加JDK、Hadoop、Scala和Spark的路径,使得全局环境变量包含这些软件的位置。另外,也可以在用户级配置文件`~/.bashrc`中添加这些环境变量,使得每次登录时都能自动加载。

3. 安装Scala:下载Scala的tgz文件,然后创建一个新的目录用于安装,并解压到指定目录。安装完成后,Scala的可执行文件应该可以在系统路径中找到。

4. 安装Spark:同样,下载Spark的预编译版本,解压并指定其在系统中的位置。Spark的版本应与Hadoop的版本兼容,这里示例的是`spark-1.2.0-bin-hadoop2.4.tgz`,表明它是针对Hadoop 2.4构建的。

5. 配置Spark:Spark的配置通常涉及到修改`conf`目录下的文件,如`spark-env.sh`和`slaves`。`slaves`文件列出集群中的工作节点,而`spark-env.sh`则用于设置Spark相关的环境变量和配置选项,如内存分配、日志级别等。

完成以上步骤后,还需要启动Hadoop和Spark的服务,确保它们正常运行。在多节点集群中,通常会使用`start-all.sh`或类似的脚本来启动所有服务。最后,测试Spark集群的功能,可以通过运行简单的Spark作业来验证集群配置是否正确。

请注意,上述步骤仅为基本配置,实际部署可能需要考虑更多因素,如安全性、性能优化、资源调度策略等。在生产环境中,可能还需要使用像YARN或Mesos这样的资源管理器来更好地管理和调度Spark作业。

336 浏览量

3760 浏览量

2021-05-13 上传

390 浏览量

219 浏览量

点击了解资源详情

点击了解资源详情

336 浏览量

点击了解资源详情

不知者无胃口

- 粉丝: 32

最新资源

- 免费教程:Samba 4 1级课程入门指南

- 免费的HomeFtpServer软件:Windows服务器端FTP解决方案

- 实时演示概率分布的闪亮Web应用

- 探索RxJava:使用RxBus实现高效Android事件处理

- Microchip USB转UART转换方案的完整设计教程

- Python编程基础及应用实践教程

- Kendo UI 2013.2.716商业版ASP.NET MVC集成

- 增强版echarts地图:中国七大区至省详细数据解析

- Tooloop-OS:定制化的Ubuntu Server最小多媒体系统

- JavaBridge下载:获取Java.inc与JavaBridge.jar

- Java编写的开源小战争游戏Wargame解析

- C++实现简易SSCOM3.2功能的串口调试工具源码

- Android屏幕旋转问题解决工具:DialogAlchemy

- Linux下的文件共享新工具:Fileshare Applet及其特性介绍

- 高等应用数学问题的matlab求解:318个源程序打包分享

- 2015南大机试:罗马数字转十进制数代码解析