深度学习实践:注意力机制与Seq2seq模型解析

146 浏览量

更新于2024-08-30

1

收藏 775KB PDF 举报

"动手学习深度学习,关注注意力机制和Seq2seq模型的应用"

在深度学习领域,注意力机制(Attention Mechanism)和Seq2seq(Sequence to Sequence)模型是两种非常重要的技术,尤其在自然语言处理(NLP)任务中发挥着关键作用。注意力机制允许模型在处理序列数据时,不仅关注整个输入序列,而是根据需要动态地分配权重给不同位置的元素,从而提高了模型的性能。Seq2seq模型则是一种用于序列到序列转换的任务,常用于机器翻译、语音识别等任务。

2.1.注意力机制

2.1.1.概念

注意力机制的核心思想是,模型在处理长序列时,可以"看"到序列中的每个部分,并根据其重要性分配不同的权重。这种机制借鉴了人类认知过程,即在理解一段话时,我们并不会平均对待每一个词,而是会将焦点集中在关键信息上。

2.1.2.框架

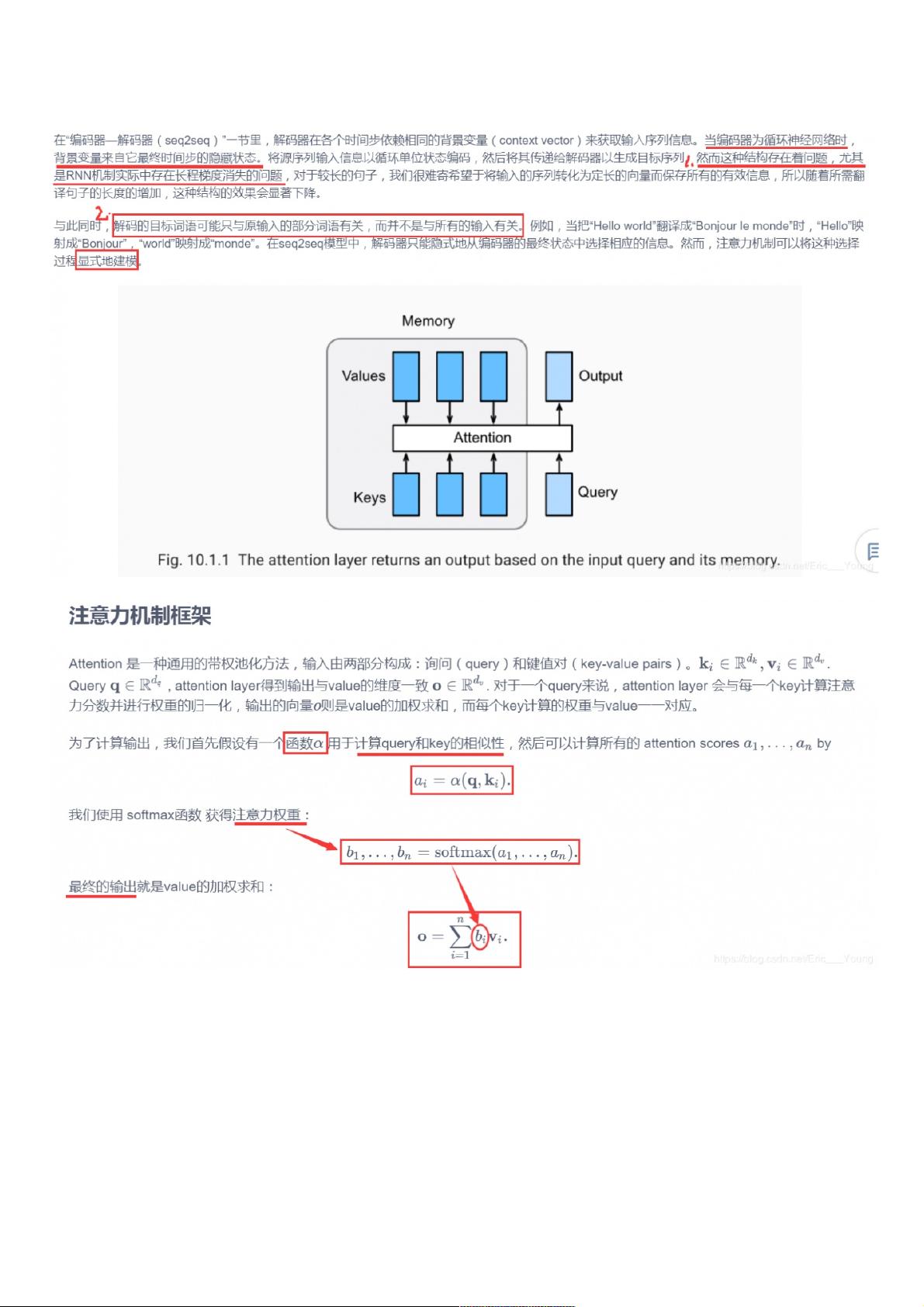

注意力机制通常包括三个主要组件:查询(Query)、键(Key)和值(Value)。查询代表当前需要关注的信息,键用来计算与查询的相似度,值则是根据相似度得分加权后的信息。不同的注意力层主要区别在于如何计算得分(Score Function),如 Dot-Product Attention 和 Multilayer Perceptron Attention。

- Dot-Product Attention:这是最简单也最常用的形式,它通过计算查询和键的点积来得到得分,然后通过softmax函数归一化。

- Multilayer Perceptron Attention:使用多层感知机来计算得分,可以引入更多的非线性特性,增加模型的表达能力。

在实际应用中,注意力机制常与Transformer或RNN等模型结合,形成如Transformer-Attention或RNN-Attention的架构。

2.2 Seq2seq模型

Seq2seq模型由编码器(Encoder)和解码器(Decoder)两部分组成。编码器负责理解输入序列,将其压缩成固定长度的向量(上下文向量),而解码器则根据这个向量生成目标序列。引入注意力机制后,解码器在生成每个目标词时,可以根据之前生成的词动态地关注输入序列的不同部分。

在实现一个带有注意力机制的Seq2seq模型时,通常会包含以下步骤:

1. 构建编码器和解码器网络结构,可能包括LSTM、GRU等RNN单元,或者Transformer等结构。

2. 定义注意力层,选择合适的score函数。

3. 在解码器中引入注意力机制,计算加权后的上下文向量。

4. 训练模型,使用如交叉熵损失作为优化目标。

5. 应用模型进行序列到序列的预测,如英法翻译。

在代码示例中,`file_name_walk`函数用于遍历指定目录下的文件,这可能用于加载训练数据。`SequenceMask`函数是用于处理变长序列的掩码操作,它可以屏蔽掉那些不相关的“padding”位置,避免在计算时受到它们的干扰。`masked_softmax`函数则是在计算softmax时考虑了序列的有效长度,避免了对无效位置的计算。

在实际应用中,使用注意力机制和Seq2seq模型的深度学习系统往往能更好地处理复杂序列任务,提供更准确的预测结果。在训练过程中,需要注意优化策略的选择、模型的正则化以及避免过拟合等问题,同时,合理的数据预处理和模型超参数调整也是提升模型性能的关键。

3846 浏览量

223 浏览量

228 浏览量

1479 浏览量

329 浏览量

283 浏览量

335 浏览量

218 浏览量

162 浏览量

weixin_38732343

- 粉丝: 5

最新资源

- 足球模拟标记语言FerSML开源项目发布

- 精选awesome twitter工具列表:提升社交媒体管理效率

- 自制汇编语言计算器:基础运算与存储功能

- 泰迪科技数据产品分析及PowerBI可视化教程

- Elasticsearch聚合值过滤的实现方法

- Android网络通信组件EasyHttp:全面支持Get/Post及下载上传功能

- React元素平移组件:实现Google Maps式DOM操作

- 深入浅出Ajax开发讲义与完整源代码分析

- Vue.js + Electron打造的Twitter客户端功能全面上线

- PHP开发威客平台源码分享:前端后端及多技术项目资源

- 掌握XSS防护:使用xssProtect及核心jar包

- zTree_v3树形结构和拖拽效果的演示与API文档

- Matlab运动检测与测速GUI程序详解与打包指南

- C#中GridView Eval()方法实现数据格式化详解

- Flex快速入门到精通的电子资源与源码

- gulp与Maven结合的示例项目实践指南