ShuffleNet算法详解:移动设备上的高效CNN

需积分: 0 95 浏览量

更新于2024-08-05

收藏 693KB PDF 举报

ShuffleNet算法详解是CSDN博客上一篇介绍Face++开发的高效深度神经网络结构的文章,其核心目标是在移动设备上实现高效的计算性能。这篇论文的原始文献链接为[1],发表于2017年的arXiv上,与MobileNet、Xception和ResNeXt等深度学习模型的设计理念相似,它们都在寻找减少模型复杂度,提升计算效率的方法。

首先,ShuffleNet借鉴了历史上的group操作,这一概念最早在AlexNet中被用于处理模型在多GPU环境下的训练。ResNeXt在此基础上进行了优化,通过分组卷积增强了ResNet的基础结构。MobileNet则引入了深度可分离卷积(Depthwise Separable Convolution),这是一种将卷积分解为两个独立步骤的策略:深度卷积(只在通道维度上进行)和点积(仅在空间维度上进行),极大地降低了计算负担,同时保持了较高的准确率,MobileNets系列就是这一思想的实践案例。

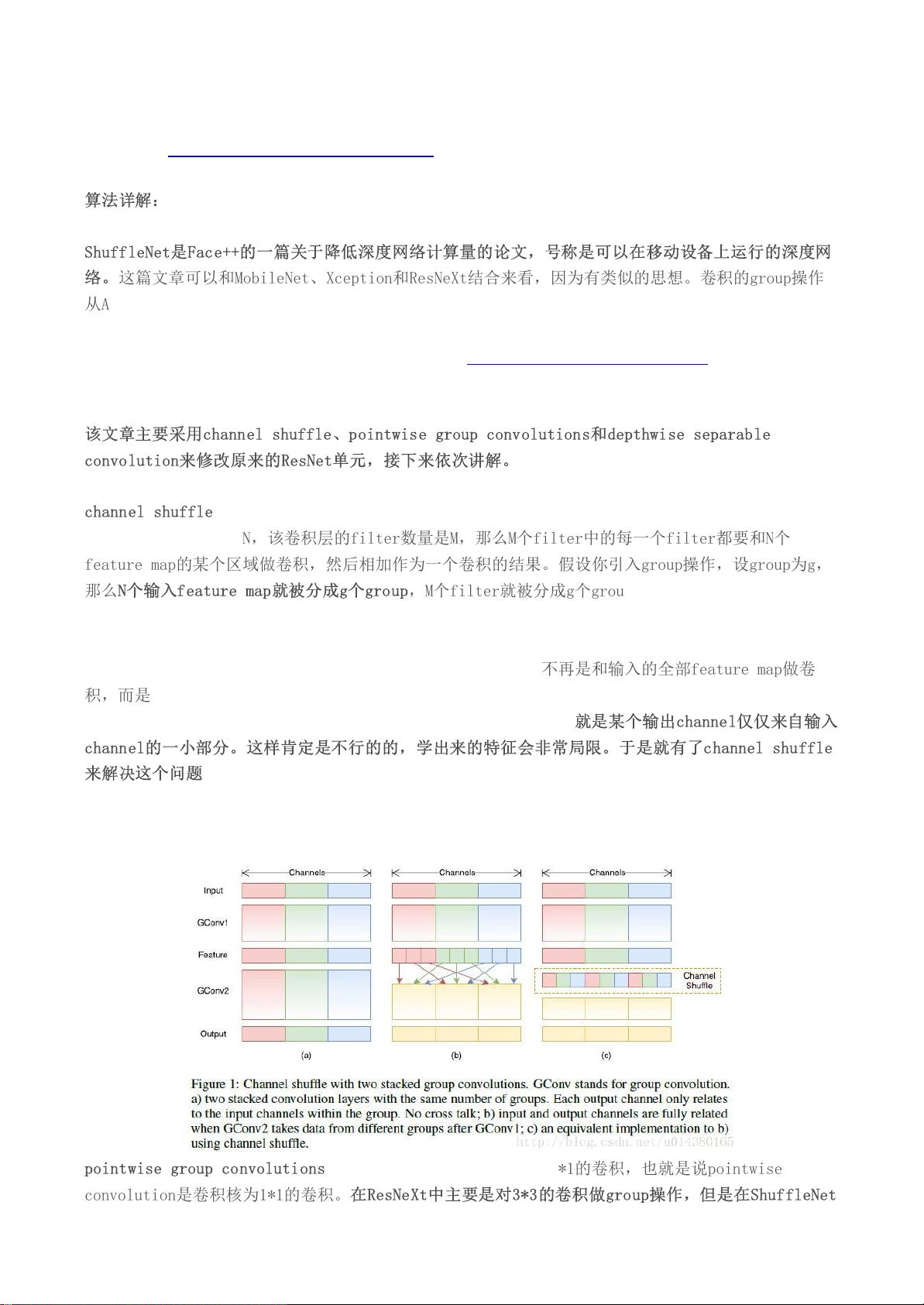

ShuffleNet的独特之处在于它采用channel shuffle操作,如图1所示。传统卷积中,每个滤波器与输入特征图的所有部分进行卷积,而在ShuffleNet中,输入特征图被分为多个组(如图1中的不同颜色),滤波器也按组进行划分。这样,每个滤波器只与对应组的特征图进行卷积,减少了跨组的计算,显著地节省了计算资源。此外,论文还提出了pointwise group convolution,这是一种结合了点积和分组卷积的技术,进一步提升了模型的效率。

深度可分离卷积同样被ShuffleNet所采用,但文章中提到的其他创新方法,如channel shuffle,对于提高网络的计算效率和模型的轻量化至关重要。ShuffleNet旨在提供一个能在移动设备上运行的高性能网络,能够在保持相对较好性能的同时,对资源占用进行严格的控制,这对于移动AI应用来说具有重要意义。

总结来说,ShuffleNet算法是一个围绕深度学习模型的效率和移动设备适应性进行设计的创新框架,通过channel shuffle、pointwise group convolution和深度可分离卷积等技术,实现了在资源受限环境下保持较高准确性的目标。理解并深入研究ShuffleNet,有助于开发者在实际项目中选择适合的轻量化模型,提升移动端的AI体验。

2021-09-25 上传

2024-09-06 上传

2023-09-15 上传

2022-05-03 上传

2022-05-03 上传

2022-03-27 上传

2022-04-20 上传

2022-05-12 上传

2022-04-06 上传

lirumei

- 粉丝: 72

- 资源: 301

最新资源

- Raspberry Pi OpenCL驱动程序安装与QEMU仿真指南

- Apache RocketMQ Go客户端:全面支持与消息处理功能

- WStage平台:无线传感器网络阶段数据交互技术

- 基于Java SpringBoot和微信小程序的ssm智能仓储系统开发

- CorrectMe项目:自动更正与建议API的开发与应用

- IdeaBiz请求处理程序JAVA:自动化API调用与令牌管理

- 墨西哥面包店研讨会:介绍关键业绩指标(KPI)与评估标准

- 2014年Android音乐播放器源码学习分享

- CleverRecyclerView扩展库:滑动效果与特性增强

- 利用Python和SURF特征识别斑点猫图像

- Wurpr开源PHP MySQL包装器:安全易用且高效

- Scratch少儿编程:Kanon妹系闹钟音效素材包

- 食品分享社交应用的开发教程与功能介绍

- Cookies by lfj.io: 浏览数据智能管理与同步工具

- 掌握SSH框架与SpringMVC Hibernate集成教程

- C语言实现FFT算法及互相关性能优化指南