卷积神经网络历程与经典模型总结

需积分: 39 190 浏览量

更新于2024-01-13

2

收藏 6.52MB PDF 举报

卷积神经网络(CNN)是一种深度学习模型,已经成为计算机视觉领域的重要工具。在过去的几十年里,CNN经历了不断的发展和完善,各种经典模型也相继涌现。本文将会对CNN的发展历程和部分经典模型进行总结和回顾。

一、LeNet之后的CNN网络结构发展重要时间线

LeNet被认为是CNN的鼻祖,在1998年由Yann LeCun等人提出。LeNet在手写数字识别方面取得了很好的效果,为之后的CNN研究奠定了基础。而在之后的发展中,CNN网络结构也不断得到改进和完善。其中,AlexNet是一个重要的时间节点。

二、AlexNet

1. 模型作者

AlexNet是由Alex Krizhevsky等人在多伦多大学提出的。

2. 模型被提出的原因

在AlexNet之前,CNN在小型数据集上表现良好,但在现实生活中的大型和多变的数据集上表现不佳。因此,AlexNet的提出主要是为了解决对大规模数据集的有效训练,并取得更好的效果。

3. 历史

2012年9月30日,Alex团队使用AlexNet参加ImageNet大规模视觉识别挑战(ILSVRC),并获得了冠军。AlexNet在比赛中取得了15.3%的top-5错误率,比亚军低了10.8个百分点。这个成绩引起了人们对CNN的广泛关注,也推动了CNN的发展和应用。

除了LeNet和AlexNet之外,还有一些其他重要的CNN模型,例如VGG、GoogLeNet、ResNet等,它们分别在网络深度、特征提取、网络结构等方面进行了创新和突破。

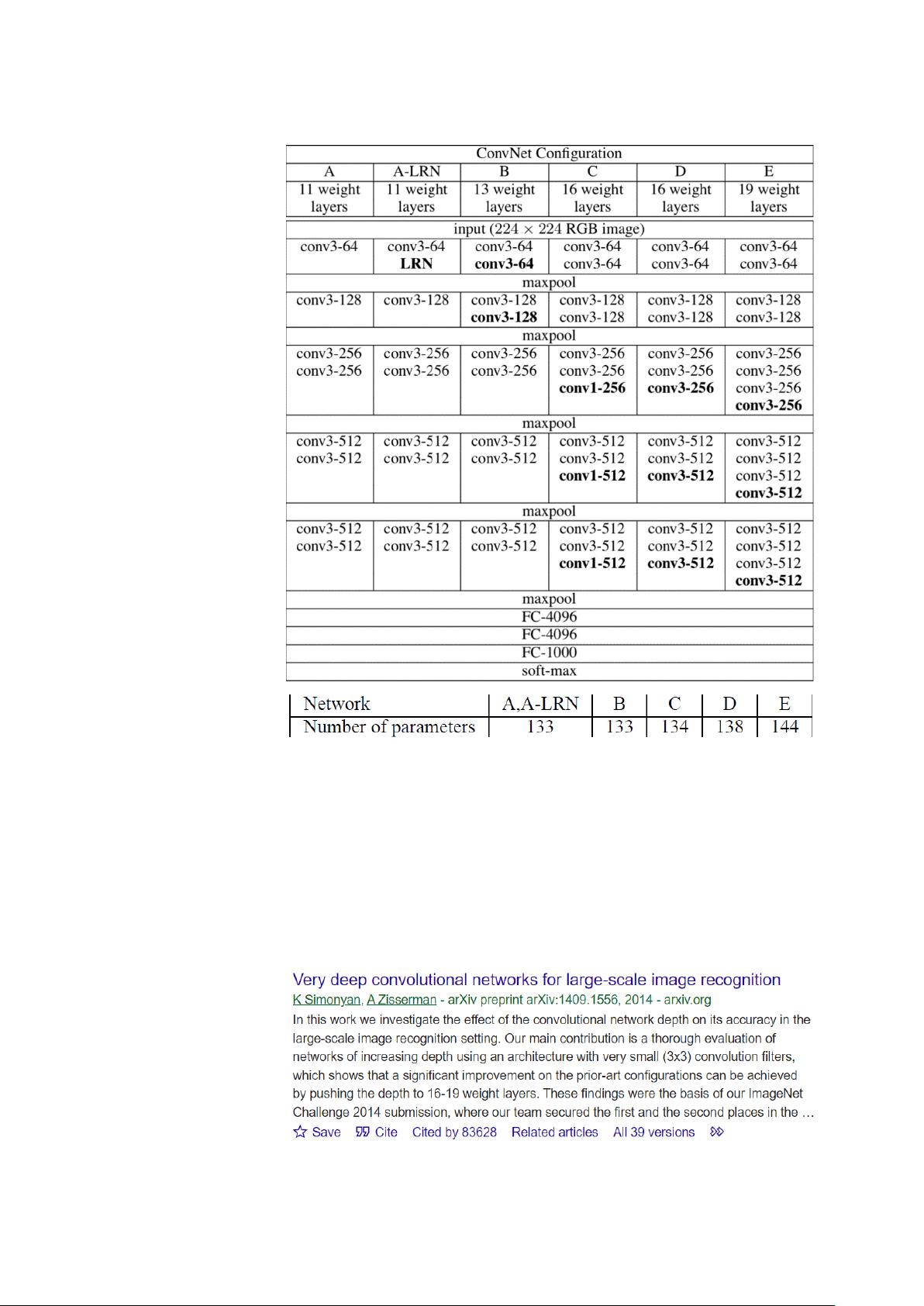

VGG模型提出了在网络中使用多个3x3的卷积核来替代更大kernel大小的思想,从而在保持感受野的情况下提高了网络的深度。GoogLeNet引入了Inception模块,实现了网络的高效性能和更低的参数数量。ResNet通过引入了残差连接,解决了深度网络训练中梯度消失等问题,使得网络深度得以进一步扩展。

在这些经典模型的不断发展和完善中,CNN的结构不断变得更加复杂和高效,同时也取得了更好的性能。这些模型的出现,推动了计算机视觉领域的发展,也为其他领域的深度学习研究提供了重要参考。

总之,CNN经历了从LeNet到AlexNet再到VGG、GoogLeNet、ResNet等一系列经典模型的发展和演变,不断完善和改进网络结构,取得了一系列在图像识别、目标检测、语义分割等任务中的重大突破。这些模型的成功应用,使得CNN在计算机视觉领域的地位愈发重要,为实际应用和学术研究提供了强有力的支持。CNN的未来发展,将会继续在模型效果、结构优化和应用领域等方面取得更多的进展和突破。

2021-01-07 上传

2021-01-20 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

lil_Cris

- 粉丝: 3

- 资源: 1

最新资源

- 数据-行业数据-天立教育:2020年度报告.rar

- 硬件记录

- Pytorch 快速入门实战之 Fashionmnist

- 程序等待-易语言

- zabbix-html-email-template:可自定义的Zabbix HTML电子邮件模板-ProblemRecovery

- set-compose-tags

- DotinPolygonAlgorithm:DotinPolygon算法

- 行业分类-设备装置-可记录媒体的分离装置.zip

- WindowsFormsApplication1.rar

- 仿QQ登录界面-易语言

- IBM应用数据科学Capstone

- Python库 | outlier_akashjindal347-0.0.1-py3-none-any.whl

- TheWorldBetweenUs:豆瓣评论分析

- bgpvis:bgpdump数据分析

- plasmid_mapR:用于在整个基因组序列数据集中进行质量计算和可视化参考质粒覆盖范围的软件包

- 行业分类-设备装置-叶片平台的冷却.zip