知识增强的图语义理解技术:ERNIE在深度应用

版权申诉

127 浏览量

更新于2024-07-05

收藏 7.31MB PDF 举报

"1-1知识增强图语义理解技术.pdf"是一份由百度资深工程师黄正杰在2021年的DataFunSummit会议上发表的论文,主要探讨了如何利用知识增强的方法提升图语义理解的技术水平。该研究聚焦于预训练模型与外部知识的融合,特别是在语义理解和图学习领域的应用。

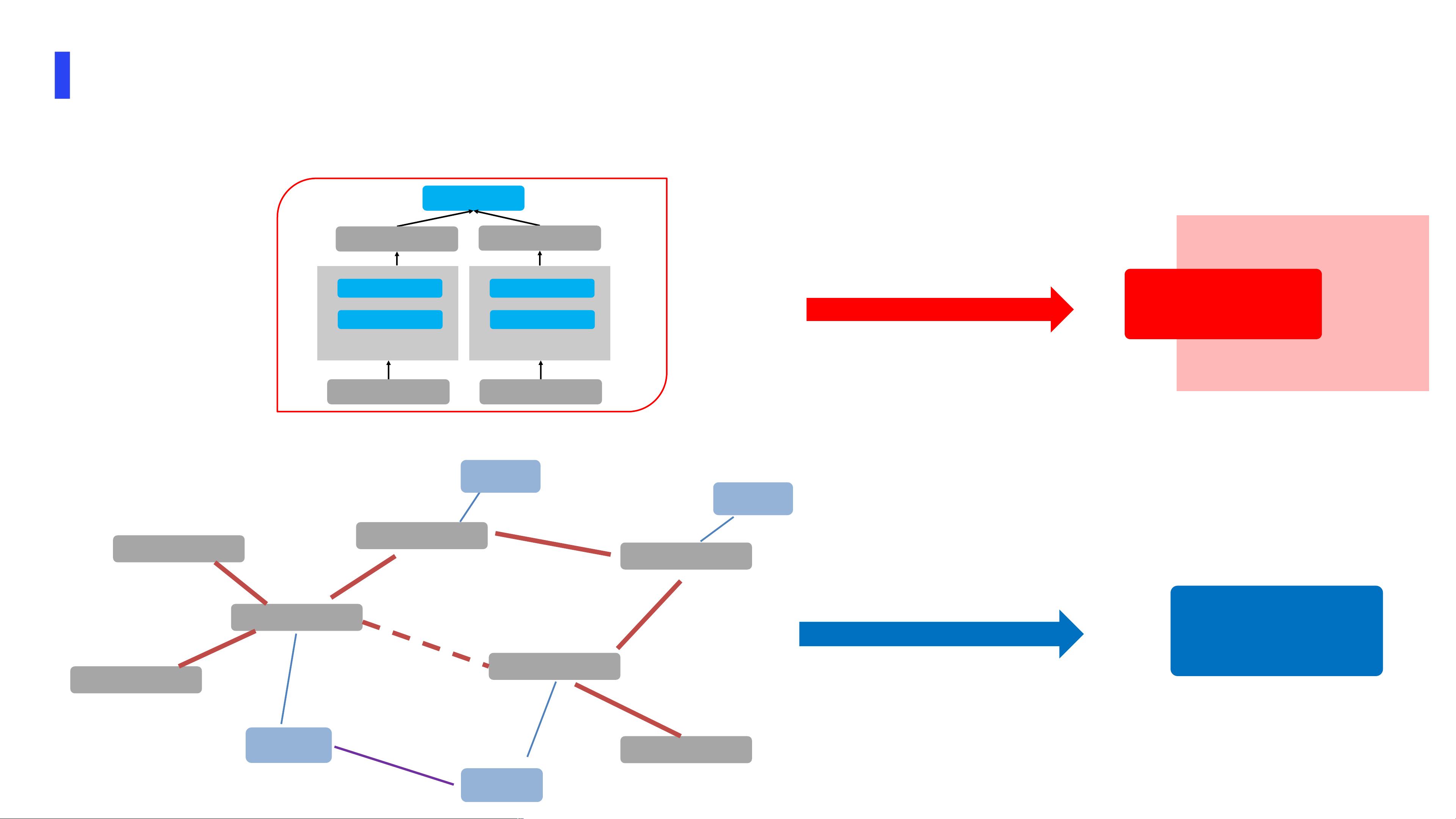

论文首先介绍了语义理解与图的结合,强调了图语义理解技术作为文本处理的新物种,能够从多个视角进行文本匹配,包括从传统意义上的语义匹配(如Cosine相似度和T1-CLS/T2-CLS等方法)以及图学习视角,例如GraphSage,它既能捕捉结构信息又能关注文本内容。

ERNIE(Encoder Representations from Transformers for Information Extraction)是百度推出的语义理解核心技术,它最初的核心思想是知识增强。通过引入外部知识,ERNIE1.0能够在语言理解任务中表现出色,特别是在处理涉及实体关系和事件理解等复杂问题时。论文进一步提到,随着技术的发展,ERNIE2.0引入了持续学习框架,如AAAI 2020年Sun等人所提出的模型,这使得ERNIE能够在不断学习新的数据和知识的基础上持续提升其性能。

以实际例子展示,比如将哈尔滨与黑龙江的省会以及国际冰雪文化名城的关系进行解析,ERNIE利用Transformer架构和预训练的优势,不仅能识别出实体(如哈尔滨、黑龙江),还能理解并整合这些实体之间的深层次语义关系。通过对比LearntbyBERT和LearntbyERNIE的处理方式,可以看出ERNIE在知识增强方面的重要改进。

总结来说,这份论文深入剖析了知识增强在图语义理解中的作用,展示了ERNIE在预训练模型中的关键角色,并探讨了如何通过持续学习框架不断优化这一技术,使其在实际应用场景中如搜索排序、信息流推荐等情境下更有效地实现文本理解与知识推理。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2022-07-04 上传

2021-09-25 上传

2021-03-27 上传

2022-07-03 上传

2022-04-15 上传

2021-03-27 上传

普通网友

- 粉丝: 13w+

- 资源: 9195

最新资源

- Evergarden:思想和笔记的公共数字花园

- [论坛社区]okphp BBS v4.0_okphpbbs.rar

- ipetfinals

- ASP 网站站长计数器 v1.0

- DICOM 示例文件:包含大脑 MR 图像的示例 DICOM 文件。-matlab开发

- FM5830_code,c语言源码怎么写,c语言项目

- C-Blog 2.1 正式版_cblog2-mysql_博客论坛网站开发模板(使用说明+源代码+html).zip

- todo-cloudbuild

- SpeakT-crx插件

- 安卓伏羲X v2.0.1双版 免Root装载Xposed模块功能.txt打包整理.zip

- json-conditions:简单的条件逻辑以针对javascript对象进行评估

- 分子查看器:用于绘制简单的 .pdb 文件的轻量级 m 文件。-matlab开发

- 绿色耀眼互联网产品企业网站模板5536_网站开发模板含源代码(css+html+js+图样).zip

- light-sphere.tar.gz_C/C++_源码,c语言读网页源码,c语言项目

- wztlink1013_github_io-master.zip

- kirby-multilist:在Kirby 3中快速管理具有多个字段的列表