深度残差学习:ResNet网络解析与优势

需积分: 5 120 浏览量

更新于2024-08-03

2

收藏 6.34MB PDF 举报

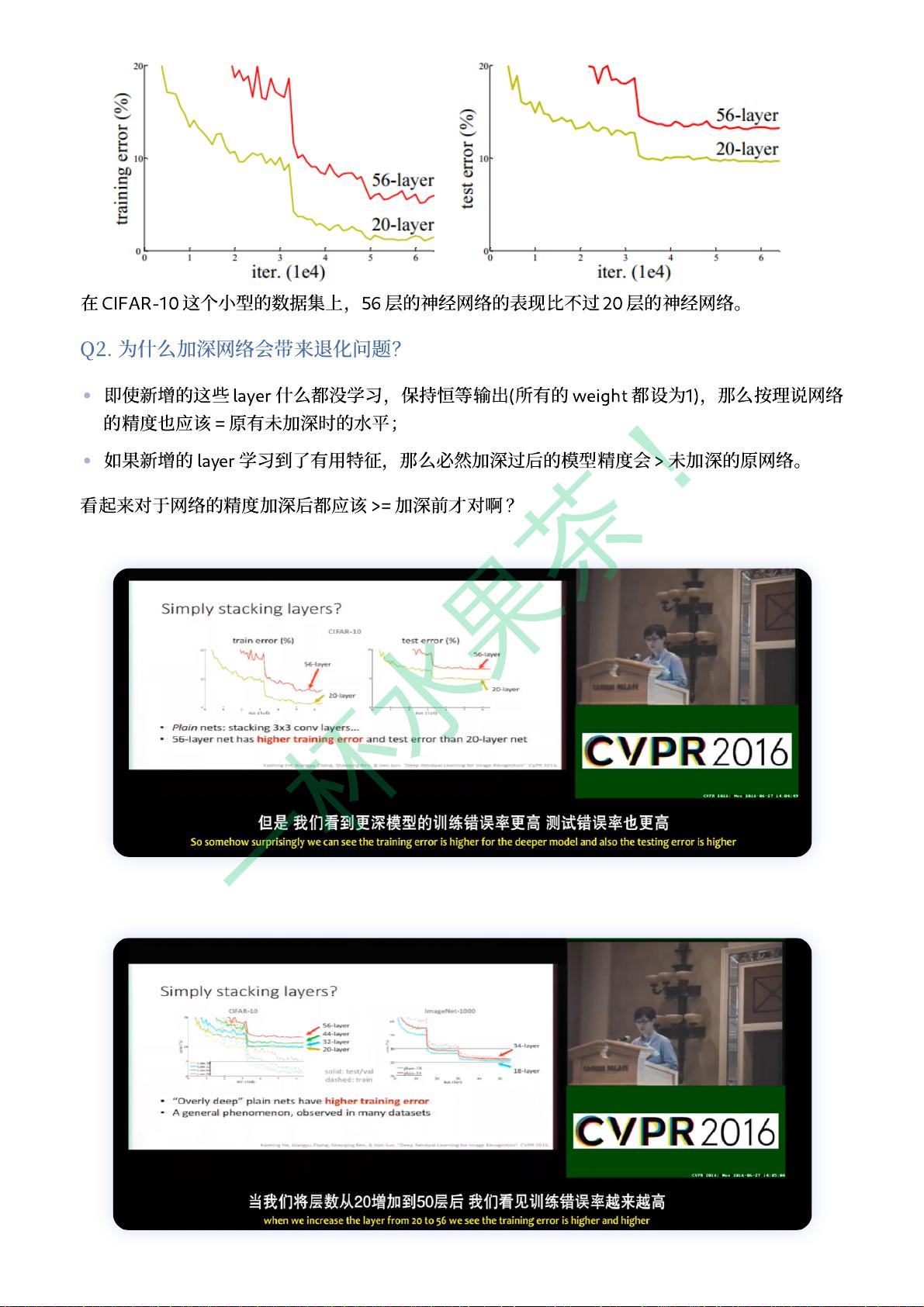

"这篇资源主要围绕ResNet论文展开,详细解释了ResNet网络的设计理念和残差学习框架,包括为何更深的神经网络更难训练,以及如何通过残差块简化深度学习的优化过程。ResNet在ImageNet数据集上达到了优秀的性能,其提出的深度残差网络结构使得网络层数可以达到前所未有的深度,如152层,并在ILSVRC 2015分类任务中取得最佳结果。此外,资源也提到了ILSVRC比赛的历史和历年冠军网络,如AlexNet、ZFNet、VGGNet和GoogLeNet,展示了深度学习在计算机视觉领域的演进和发展。"

在ResNet论文中,作者面对的是深度神经网络训练的问题。随着网络层数的增加,通常会出现梯度消失或爆炸,导致网络难以优化。为了解决这个问题,他们引入了残差学习框架。这个框架的核心思想是,不是让网络直接学习输入到输出的整体映射,而是学习输入与输出之间的差异,即残差函数。残差块的设计使得网络能够通过学习这种差异来构建复杂的函数关系,从而实现深度网络的高效训练。

每个残差块由两个或三个连续的卷积层组成,中间可能包含批量归一化和激活函数。块的输入通过一个恒等映射直接连接到输出,使得网络可以学习“添加”或“跳过”的信息,而不是从零开始学习整个映射。这种设计极大地缓解了深度网络的优化难度,允许网络达到前所未有的深度,如152层,同时保持或提高准确性。

在实验部分,ResNet在ImageNet数据集上展示了其优势,与只有16或19层的VGGNet相比,尽管更深,但其复杂性和计算需求却相对较低。在ILSVRC 2015竞赛中,ResNet获得了3.57%的测试集误差,成为当年的冠军网络,标志着深度学习的一个重要里程碑。

通过对比历年的ILSVRC冠军网络,我们可以看到深度学习模型的进化。从AlexNet开始,深度学习逐渐崭露头角,接着ZFNet通过改进进一步优化,VGGNet展示了深度对于性能的提升,GoogLeNet则引入了Inception结构以减少参数数量。这些发展最终引导到了ResNet的出现,它不仅深化了网络架构,还解决了训练难题,推动了计算机视觉技术的进步。

2021-10-04 上传

2020-01-27 上传

2024-07-11 上传

2017-10-27 上传

2012-11-19 上传

2018-09-14 上传

2023-05-15 上传

2021-02-16 上传

2017-12-09 上传

一杯水果茶!

- 粉丝: 2170

- 资源: 26

最新资源

- 单片机串口通信仿真与代码实现详解

- LVGL GUI-Guider工具:设计并仿真LVGL界面

- Unity3D魔幻风格游戏UI界面与按钮图标素材详解

- MFC VC++实现串口温度数据显示源代码分析

- JEE培训项目:jee-todolist深度解析

- 74LS138译码器在单片机应用中的实现方法

- Android平台的动物象棋游戏应用开发

- C++系统测试项目:毕业设计与课程实践指南

- WZYAVPlayer:一个适用于iOS的视频播放控件

- ASP实现校园学生信息在线管理系统设计与实践

- 使用node-webkit和AngularJS打造跨平台桌面应用

- C#实现递归绘制圆形的探索

- C++语言项目开发:烟花效果动画实现

- 高效子网掩码计算器:网络工具中的必备应用

- 用Django构建个人博客网站的学习之旅

- SpringBoot微服务搭建与Spring Cloud实践