深入理解RNN:李宏毅教授的循环神经网络教程

需积分: 13 143 浏览量

更新于2024-07-18

收藏 5.71MB PPTX 举报

"李宏毅教授的讲解涵盖了RNN(循环神经网络)的基本概念和应用,特别是用于槽填充(Slot Filling)的问题。通过深度学习的视角,深入解析了如何用RNN解决自然语言处理中的序列建模挑战。"

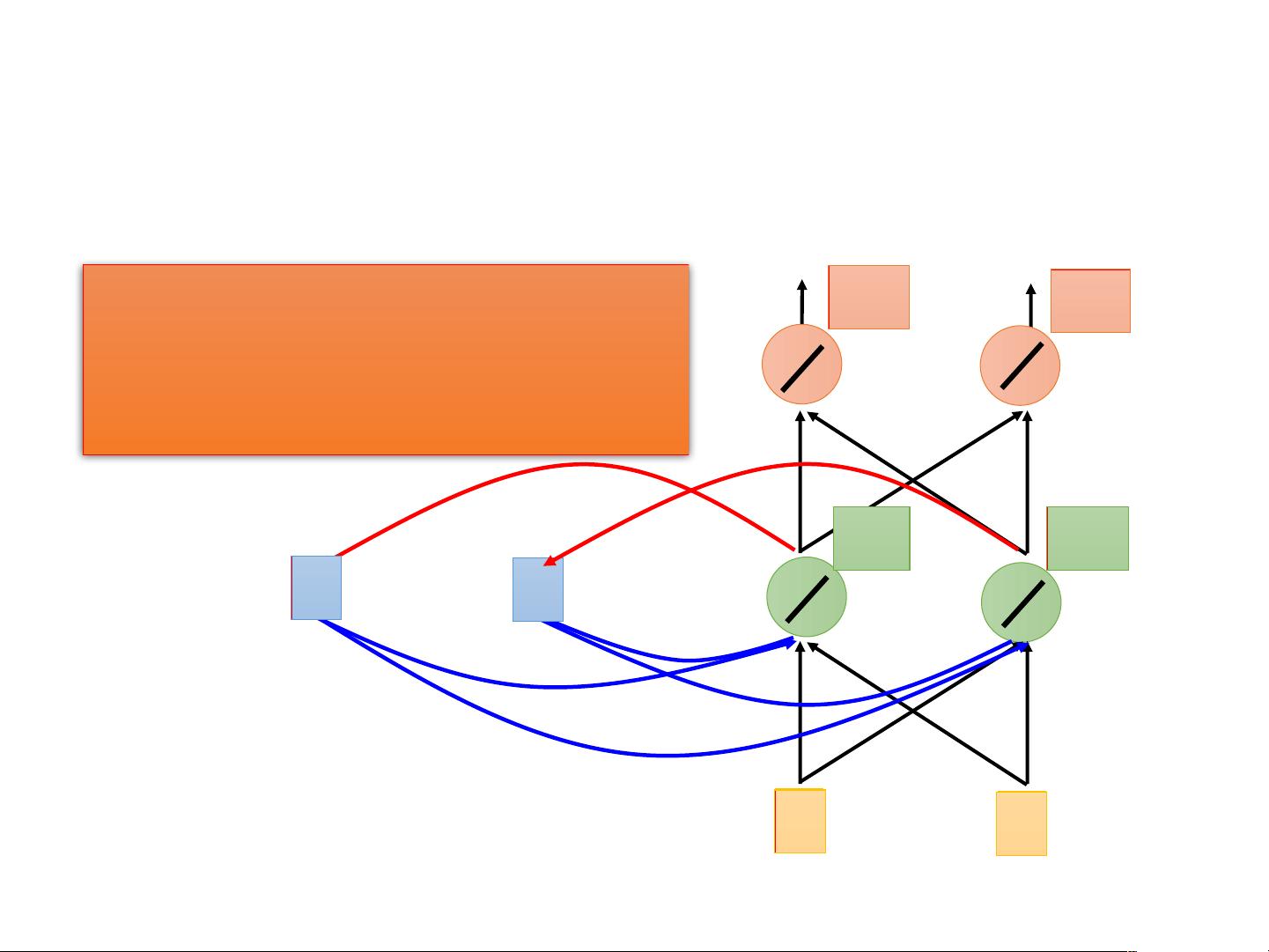

RNN循环神经网络是一种在深度学习领域广泛应用的模型,特别适合处理序列数据,如时间序列分析、自然语言处理等。与传统的前馈神经网络(Feedforward Neural Network)不同,RNN在结构上引入了循环连接,允许信息在时间轴上传递,这样网络就能够记住前面输入的信息,并将其与当前输入相结合,用于预测或生成序列中的下一个元素。

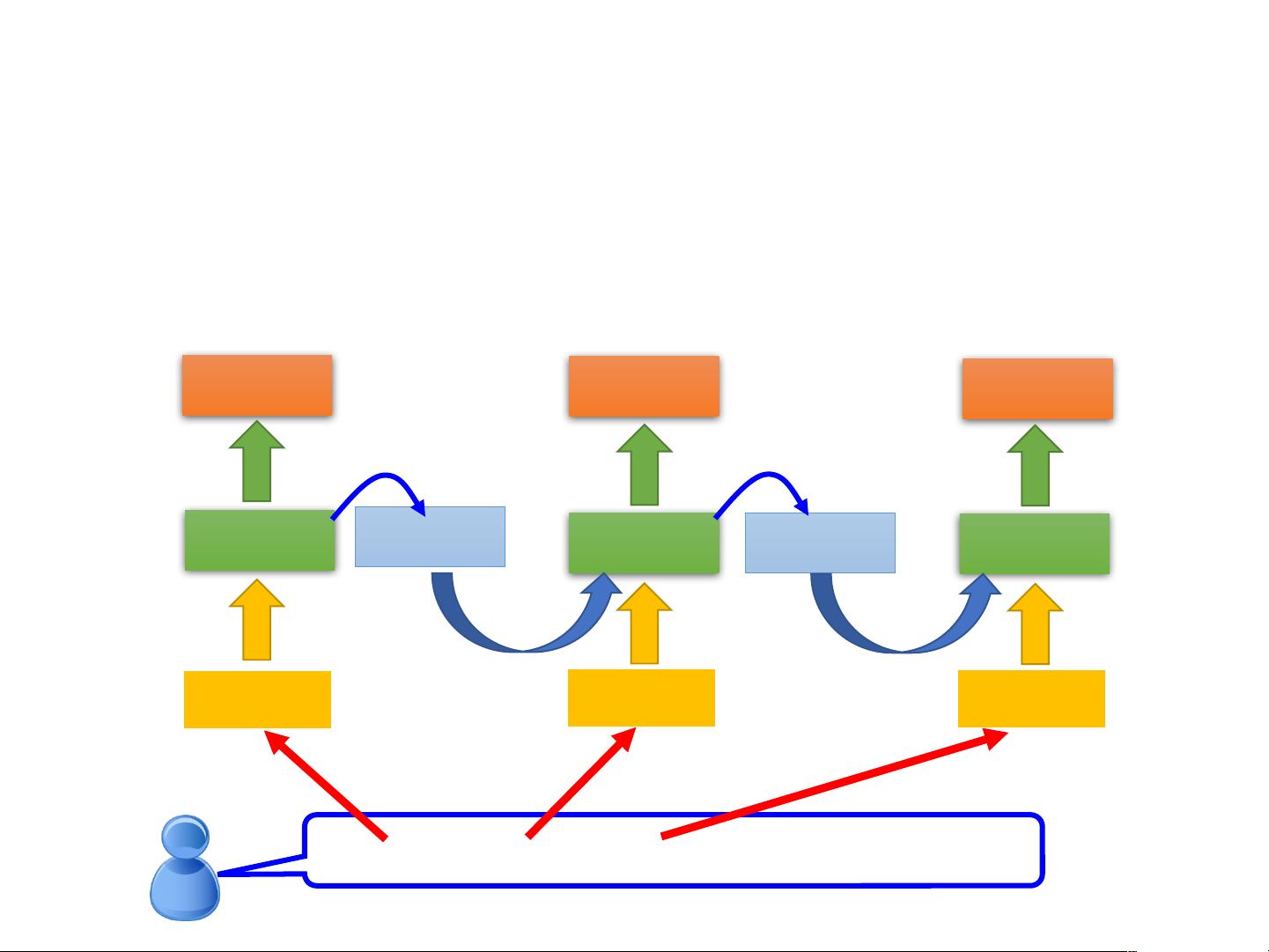

在李宏毅教授的讲解中,他以一个机票预订系统的例子来说明RNN的工作原理。例如,用户想要在11月2日到达台北,这是一个典型的槽填充问题,需要确定目的地(Taipei)、到达时间(November 2nd)等信息。传统方法可能使用1-of-N编码,其中每个单词对应词典中的一个维度,如果该词存在,则对应的维度为1,其他为0。如词典包含“apple”、“bag”、“cat”、“dog”和“elephant”,则“apple”的向量表示为[10000],以此类推。

然而,这种1-of-N编码方法限制了模型捕捉到词汇间的语义关系。为了更有效地表示每个词,可以使用词嵌入(Word Embedding),如词袋模型(Bag-of-Words)或者词向量模型(如Word2Vec、GloVe),将每个词映射到高维空间的连续向量,使得语义相似的词在向量空间中距离较近。

对于输入的序列,如“Taipei”和“arrive”,RNN会将每个词的向量作为输入,然后通过隐藏层进行计算,更新其内部状态。在输出层,RNN可以生成概率分布,表示输入词可能属于的槽位,如“destination”、“time of arrival”。这在自然语言理解和生成任务中非常有用,比如在机票预订场景下,确定用户的出行目的地和时间。

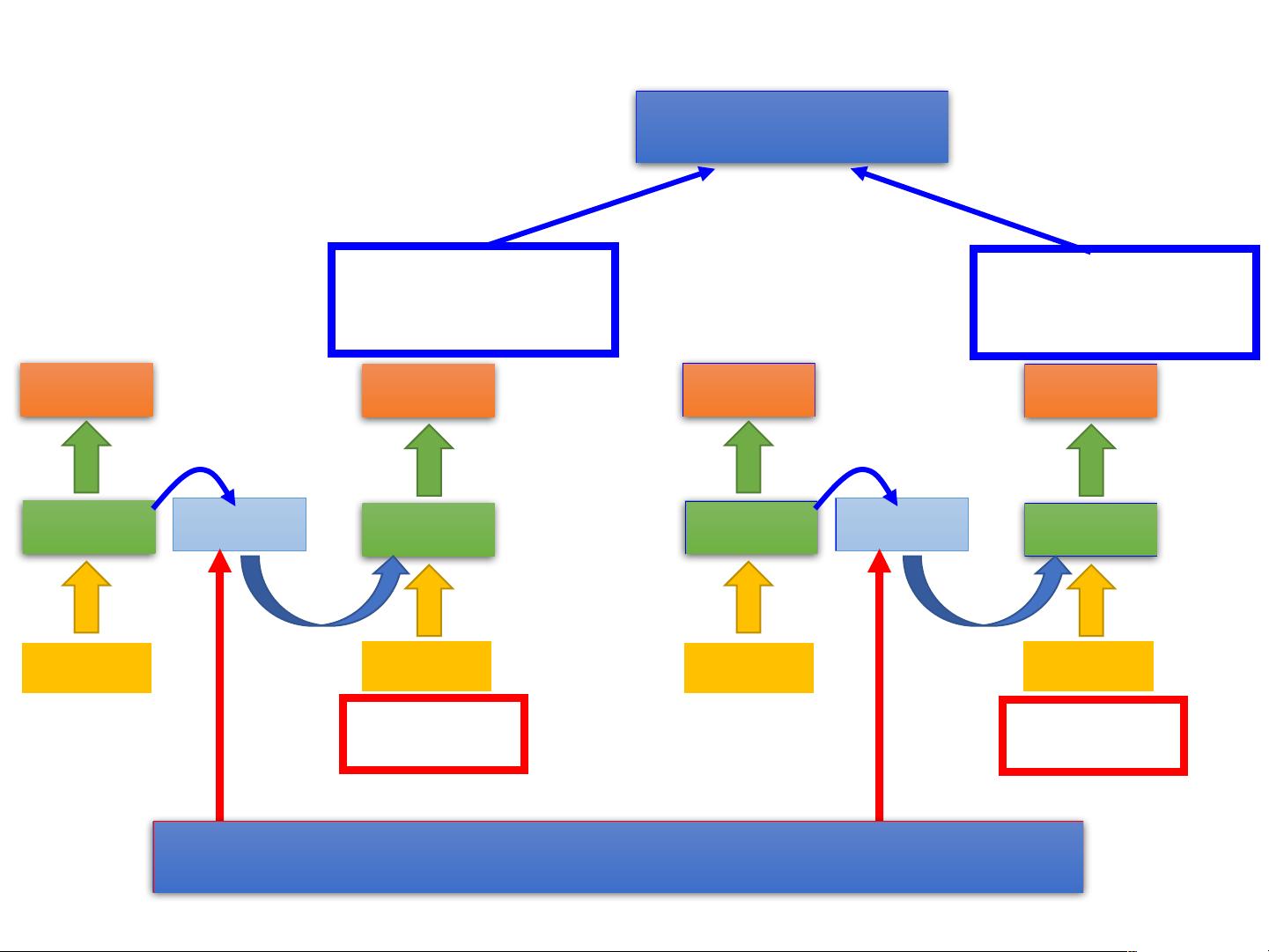

通过这样的方式,RNN能够处理变长的输入序列,且能够捕获序列内的依赖关系,这对于解决如自动填表、机器翻译、对话系统等自然语言处理任务有着显著的优势。然而,标准的RNN存在梯度消失和梯度爆炸的问题,这限制了它们处理长期依赖的能力。为了解决这些问题,研究人员提出了LSTM(长短时记忆网络)和GRU(门控循环单元)等改进的RNN结构,它们在保持序列信息方面表现得更为有效。

RNN循环神经网络是深度学习中处理序列数据的关键工具,李宏毅教授的讲解帮助学习者深入理解了RNN如何工作,以及如何利用它来解决实际问题,如自然语言处理中的槽填充任务。通过不断的研究和改进,RNN及其变体在诸多领域继续发挥着重要作用。

152 浏览量

559 浏览量

132 浏览量

125 浏览量

118 浏览量

一..一

- 粉丝: 22

- 资源: 51

最新资源

- 2023-12版本ZLM流媒体平台Windows安装包

- MapReduce实现TopN中文词频统计+英文词频统计+中文词频统计

- c++信息学竞赛及算法4阶段60节体系课程PPT,循环嵌套,递归排序,贪心算法等

- 基于nodejs人事管理系统的设计与实现(论文+源码)-kaic.rar

- 计算机控制系统课程设计说明.rar+word格式

- 基于UDP的聊天机器人源码

- gan.rargan.rargan.rar

- 关于医院系统的mysql面试题及答案.rar

- C基础系列-第一个C程序HelloWorld

- log4j日志写入redis扩展

- springboot整合log4j入门程序

- STM32 密码锁程序加Proteus仿真

- CBM209X-UMPToolV7200(2020-05-20).zip

- C++ 数据结构知识点合集-C/C++ 数组允许定义可存储相同类型数据项的变量-供大家学习研究参考

- 快速搭建基本设计还原效果的 Android 项目QMUI-Android-master

- pdf转换工具-转换word、excel、PPT等