Kafka+Storm+Hbase构建风电数据分析与实时报警系统

需积分: 0 32 浏览量

更新于2024-08-04

收藏 1.47MB DOCX 举报

本篇文档是一份详细的步骤指导书,旨在指导用户在IT环境中构建一个风电机组运行数据分析系统。该系统主要依赖于Apache Kafka、Apache HBase和MySQL数据库,以及Apache Storm进行实时数据处理。

1. **前期准备**:

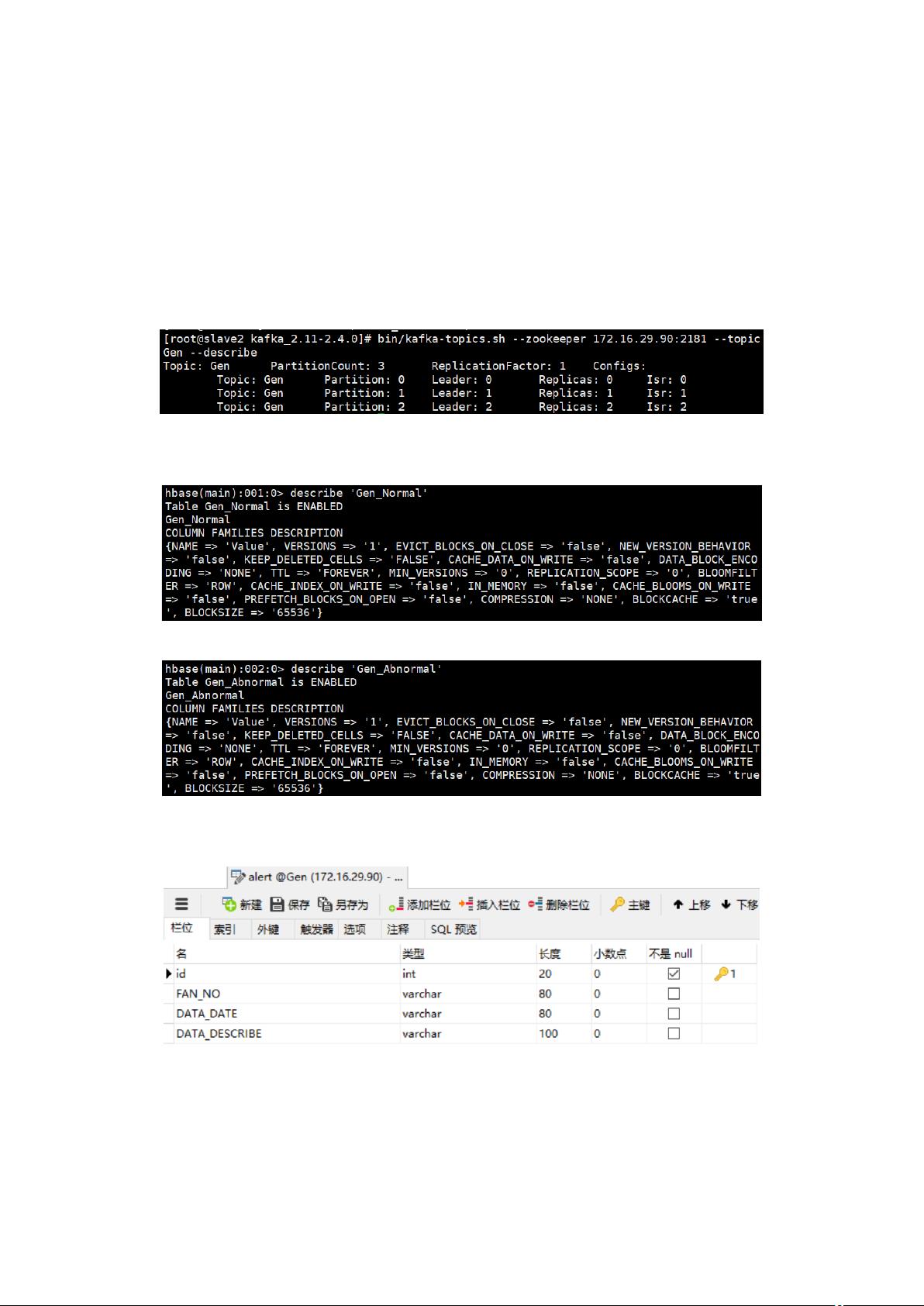

- 在分布式消息队列Kafka中创建一个名为`Gen`的Topic,用于存放模拟的风电机组运行数据。这个Topic是数据流的主要入口,所有风机数据都将通过此Topic流入系统。

- 在NoSQL数据库HBase中,创建了两个表:`Gen_Normal`用于存储正常运行的数据,`Gen_Abnormal`则用来存放异常或不合理的数据。HBase以其高并发和大数据存储能力支持实时数据的存储和分类。

- MySQL数据库用于存储管理数据,包括数据清洗规则表`rule`,用于定义数据清洗的阈值和报警条件,以及报警数据表`alert`,记录风机运行中的报警信息。

2. **Storm代码编写**:

- Storm代码的核心任务是实时处理Kafka中的数据。首先,从CSV文件中导入风机数据并将其写入Kafka。接着,从Kafka读取数据,对数据进行实时清洗,规则由MySQL中的`rule`表提供。数据清洗后的结果被进一步划分成正常和异常数据,分别存入HBase的`Gen_Normal`和`Gen_Abnormal`表。

- 通过时间窗口分析正常数据,一旦监控指标超出预设的报警条件(同样来自`rule`表),Storm将触发报警并将其存储在MySQL的`alert`表中。

3. **Web前端与后端**:

- 开发了一个Web应用,前端使用WebSocket技术实现实时通信,展示报警信息列表,并利用Echarts绘制近1小时每10分钟的报警数量趋势图,直观显示系统的实时监控状态。

- 用户界面允许用户配置数据清洗规则和监控报警条件,这些设置会实时保存到MySQL的`rule`表中,确保系统的灵活性和可定制性。

4. **运行步骤**:

- 完成所有前期准备工作后,用户需运行Kafka的`App`类,启动数据流入;然后运行Storm的`Topology`类,处理实时数据;最后,部署Gen_Web工程,通过Tomcat启动Web应用,实时查看报警信息和数据处理结果。

5. **监控与反馈**:

- 控制台输出将显示数据清洗过程中的关键信息,如HBase表的更新情况。通过Web界面,用户可以监控数据清洗和报警状态,实时调整和优化数据处理策略。

这份文档提供了一个完整的流程,涵盖了从数据源接入、实时处理、存储和可视化到用户配置的全方位指导,有助于构建一个高效且可维护的风电机组运行数据监控系统。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2009-06-02 上传

2023-07-11 上传

2023-07-11 上传

2023-07-11 上传

艾斯·歪

- 粉丝: 42

- 资源: 342

最新资源

- Cucumber-JVM模板项目快速入门教程

- ECharts打造公司组织架构可视化展示

- DC Water Alerts 数据开放平台介绍

- 图形化编程打造智能家居控制系统

- 个人网站构建:使用CSS实现风格化布局

- 使用CANBUS控制LED灯柱颜色的Matlab代码实现

- ACTCMS管理系统安装与更新教程

- 快速查看IP地址及地理位置信息的View My IP插件

- Pandas库助力数据分析与编程效率提升

- Python实现k均值聚类音乐数据可视化分析

- formdotcom打造高效网络表单解决方案

- 仿京东套餐购买列表源码DYCPackage解析

- 开源管理工具orgParty:面向PartySur的多功能应用程序

- Flutter时间跟踪应用Time_tracker入门教程

- AngularJS实现自定义滑动项目及动作指南

- 掌握C++编译时打印:compile-time-printer的使用与原理