Kettle ETL安装与MySQL数据库配置教程

需积分: 15 73 浏览量

更新于2024-07-09

收藏 2.81MB PDF 举报

"ETL实验课程笔记.pdf"

ETL(Extract, Transform, Load)是数据处理领域中的一个关键过程,用于从不同的数据源抽取数据(Extract),对数据进行清洗、转换(Transform),然后加载(Load)到目标系统,例如数据仓库或大数据平台。本实验课程主要围绕Kettle这个ETL工具展开,Kettle是Pentaho Data Integration的别名,是一款开源的数据集成解决方案。

首先,课程介绍了如何获取并安装Kettle。你可以从Kettle的官方网站或者国内镜像站点下载最新版或稳定版的软件。由于Kettle是免安装的,只需将其解压缩到任意目录即可开始使用。

在安装过程中,确保已经安装了Java Development Kit (JDK),因为Kettle运行依赖于JDK环境。如果你尚未安装JDK,需要先进行安装。

接下来,课程指导如何运行Kettle的核心组件——Spoon。Spoon是Kettle的图形化工作台,通过执行Spoon.bat文件,用户可以启动这个可视化界面,进行ETL流程的设计和调试。

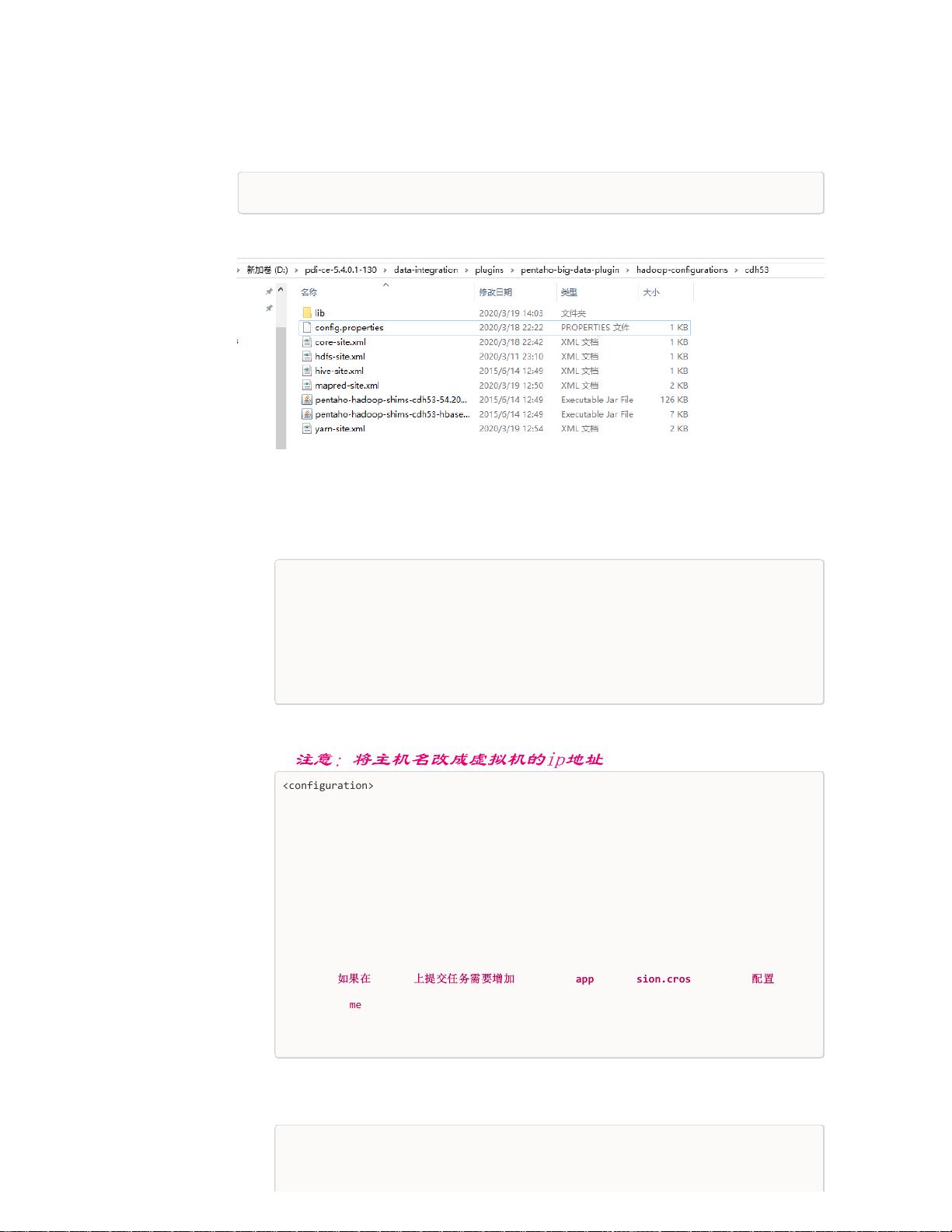

在Kettle中创建数据库仓库是ETL工作的重要步骤。以MySQL为例,你需要将MySQL的JDBC驱动复制到Kettle的lib目录下,然后在Spoon中创建新的数据库资源库。这包括定义资源库名称,创建数据库连接,并输入正确的连接参数,如连接名称、数据库类型、用户名和密码。完成这些设置后,测试连接以确保能成功连接到MySQL服务器。

一旦数据库连接成功,Kettle会自动在选定的数据库中创建必要的表,用于存储元数据和其他相关信息。在实验中,可以看到在名为cloudsch的数据库下,Kettle创建了所需的表。

此外,课程还涉及到了资源库的安全管理。Kettle允许设置用户权限,控制不同用户对资源库的访问。通过工具菜单下的“资源库”->“探索资源库”,可以添加新的用户,分配相应的用户名和密码,以此来管理和保护数据资源。

总结来说,这个ETL实验课程涵盖了Kettle的基本操作,包括安装、启动、数据库连接的配置以及用户权限管理。这些知识对于理解数据集成流程和熟练使用Kettle进行ETL操作至关重要。通过实践这些步骤,学习者能够掌握从数据源提取数据,进行预处理,再到加载到目标系统的基本流程,为后续的数据分析和挖掘奠定基础。

2021-05-17 上传

2022-06-05 上传

2022-07-14 上传

2019-03-08 上传

2021-07-18 上传

2021-03-05 上传

2022-07-14 上传

2020-01-02 上传

若兰幽竹

- 粉丝: 7679

- 资源: 71

最新资源

- CoreOS部署神器:configdrive_creator脚本详解

- 探索CCR-Studio.github.io: JavaScript的前沿实践平台

- RapidMatter:Web企业架构设计即服务应用平台

- 电影数据整合:ETL过程与数据库加载实现

- R语言文本分析工作坊资源库详细介绍

- QML小程序实现风车旋转动画教程

- Magento小部件字段验证扩展功能实现

- Flutter入门项目:my_stock应用程序开发指南

- React项目引导:快速构建、测试与部署

- 利用物联网智能技术提升设备安全

- 软件工程师校招笔试题-编程面试大学完整学习计划

- Node.js跨平台JavaScript运行时环境介绍

- 使用护照js和Google Outh的身份验证器教程

- PHP基础教程:掌握PHP编程语言

- Wheel:Vim/Neovim高效缓冲区管理与导航插件

- 在英特尔NUC5i5RYK上安装并优化Kodi运行环境