视觉-LiDAR融合SLAM技术综述

需积分: 50 108 浏览量

更新于2024-07-15

收藏 749KB PDF 举报

"A Review of Visual-LiDAR Fusion based Simultaneous Localization and Mapping"

本文是一篇文献综述,主要探讨了视觉-LiDAR融合在同时定位与建图(SLAM)中的应用。SLAM是自主导航系统的关键技术,广泛应用于移动机器人、自动驾驶汽车、无人机和水下无人器等领域。视觉SLAM和视觉-IMU SLAM已经得到了深入研究,但LiDAR-SLAM技术的发展相对停滞,尽管融合视觉和LiDAR传感器的数据可以显著提升SLAM性能,特别是在应对剧烈运动、光照不足或视觉特征缺乏的场景。

SLAM的基本思想是构建环境地图的同时估计自身位置,它通常涉及传感器数据的实时处理和映射与定位问题的联合解决。视觉传感器如摄像头提供丰富的环境信息,但易受光照、动态遮挡等因素影响;而LiDAR(光探测和测距)传感器则能提供精确的距离测量,但可能在纹理稀疏区域遇到困难。因此,视觉-LiDAR融合SLAM旨在结合两者的优点,提高系统的鲁棒性和精度。

文献回顾部分详细梳理了SLAM研究的历史和发展,包括早期的视觉SLAM方法,如基于特征的和直接法,以及后来的LiDAR SLAM技术,如基于点云的和基于网格的方法。此外,还重点分析了近年来的视觉-LiDAR融合SLAM算法,如多传感器数据融合策略、特征匹配和数据关联、误差校正模型等。

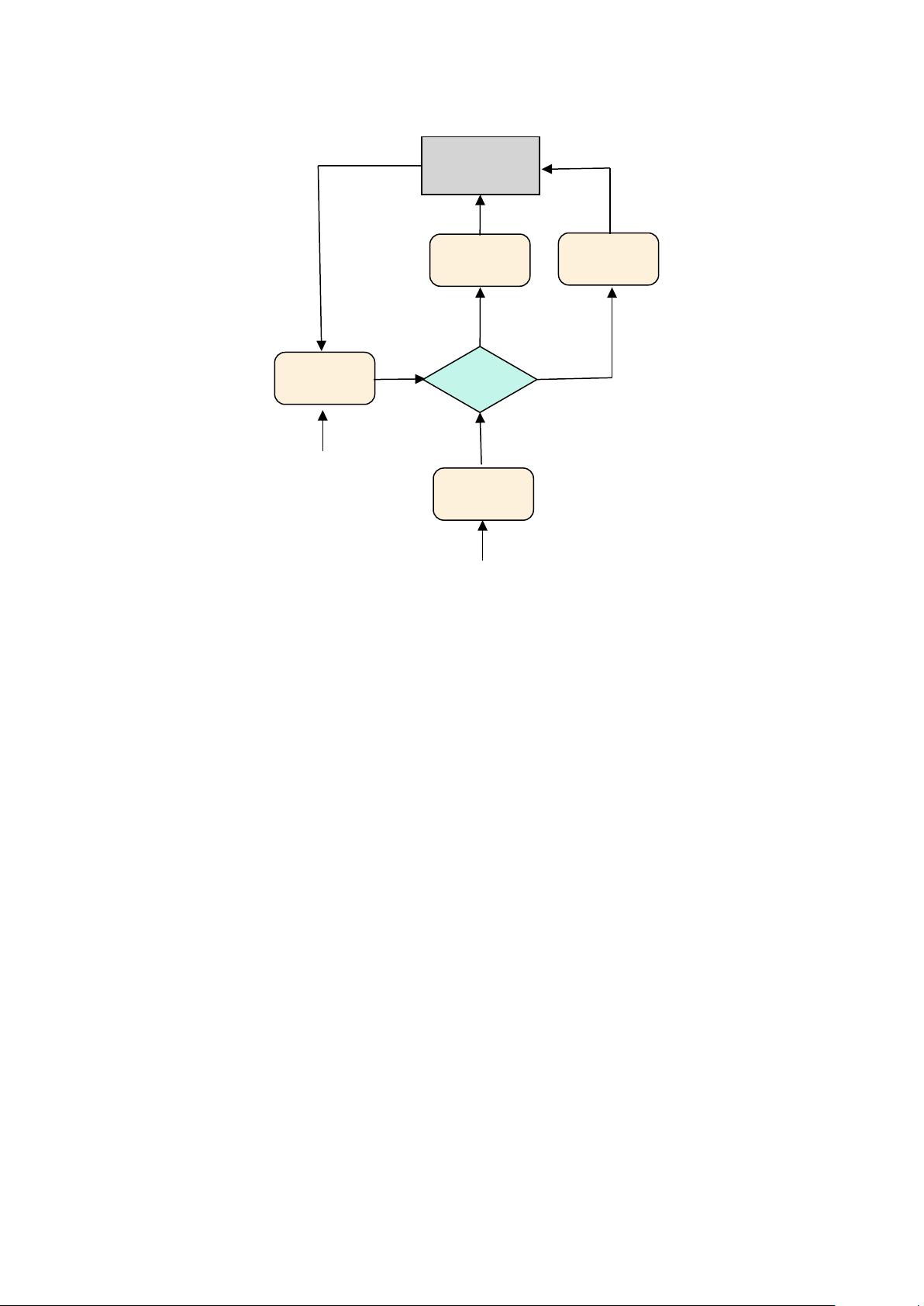

作者们讨论了各种融合方案,如早期融合、晚期融合和多层次融合,它们分别在不同层次上整合视觉和LiDAR信息。早期融合通常在原始传感器数据层面进行,晚期融合则在更高层次的特征或映射表示上进行。多层次融合则试图在多个层次上结合两种传感器的优势,以实现更优的性能。

此外,文章还涵盖了与视觉-LiDAR融合SLAM相关的挑战,例如传感器同步、数据一致性维护、噪声处理以及计算效率问题。为了克服这些挑战,研究者们提出了多种创新方法,如利用深度学习增强特征提取和匹配,以及采用优化理论来改进估计算法。

这篇综述为读者提供了视觉-LiDAR融合SLAM领域的全面视图,有助于理解当前的研究趋势和技术瓶颈,并为未来的研究方向提供启示。通过深入理解这些技术和方法,开发者和研究者能够更好地设计适用于复杂环境的高精度、高鲁棒性的自主导航系统。

135 浏览量

166 浏览量

103 浏览量

150 浏览量

2023-09-13 上传

236 浏览量

135 浏览量

2022-08-04 上传

498 浏览量

刀耕火种why

- 粉丝: 155

最新资源

- Homebridge Xbox电视插件:实现微软游戏机的HomeKit控制

- Code.js:打造前端开发中的语法高亮显示

- Java实现GDP经济地图可视化分析

- 解决Office 2003无法打开Office 2007文件的问题

- 使用Python实现K-Means进行文本聚类分析

- CentOS虚拟机模板使用指南及开源项目介绍

- Java实现的飞行模拟游戏项目

- 深入探究Windows 32位API的查询与应用

- 全面破解:U盘PE系统维护与分区工具教程

- Firefox OS NFC应用开发与远程内容加载实践

- Dart软件包管理器Pub的贡献指南与组织架构

- Spy4win8在Windows 8上的完美兼容性验证

- MySQL 5.7.16解压版:一键启动,简化数据库部署流程

- AMScrollingNavbar:Objective-C实现可滚动的UINavigationBar

- MYSQL培训经典教程 - 易学好用的数据库教程

- 探索CityGen道路插件:增强草图大师的道路生成功能