Ceph分布式存储详解:CRUSH算法与PG分布

需积分: 14 148 浏览量

更新于2024-07-18

收藏 668KB PPTX 举报

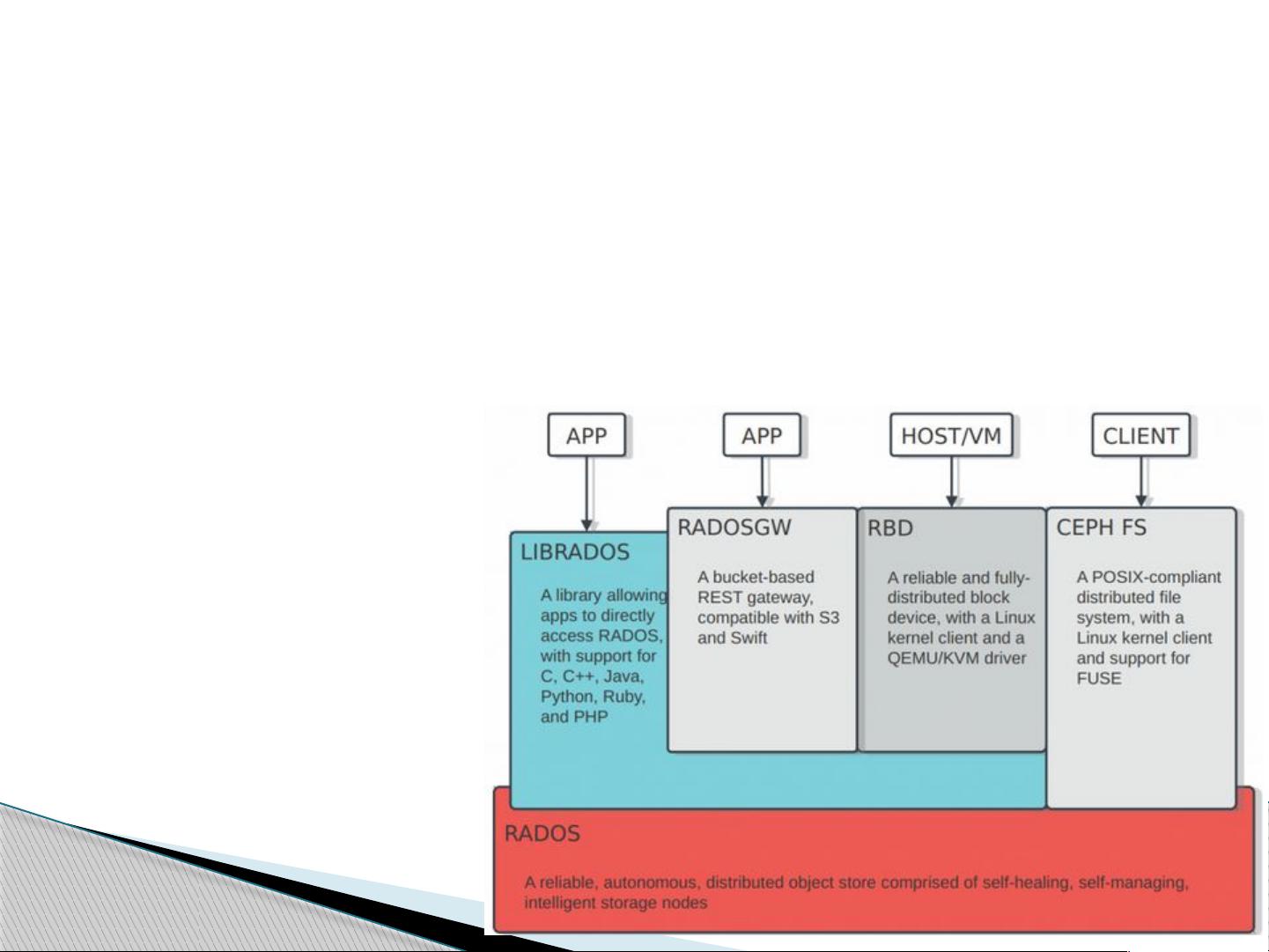

"Ceph是一种统一、分布式的存储系统,提供对象存储、块存储和文件系统存储功能。它的核心设计基于‘无需查表,算算就好’的理念,具有无中心结构和高可扩展性。Ceph在OpenStack社区中受到广泛关注。系统由四个层次构成:基础存储系统RADOS、基础库LIBRADOS、高层应用接口(RADOSGW、RBD、CephFS)和应用层。"

在深入理解Ceph之前,我们需要先了解其关键组件——RADOS(Reliable, Autonomic, Distributed Object Store)。RADOS是Ceph的基础,由OSD(Object Storage Device)和Monitor组成。OSDs是实际存储数据的实体,它们负责数据的存储和维护,而Monitors则监控整个系统的状态,通过集群映射(clustermap)来反映系统的工作状态。OSD由物理系统(如服务器、硬盘、网络设备)和运行在其上的OSD守护进程组成,守护进程执行所有的逻辑功能。

Ceph的核心特性之一是CRUSH(Controlled Replication Under Scalable Hashing)算法,它决定了数据如何在OSD之间分布,确保数据的冗余和容错能力。CRUSH算法使得数据分布无需依赖中央索引,而是通过计算确定,从而提高了效率和可扩展性。此外,PG(Placement Group)是数据分布的逻辑单位,它进一步细化了数据的管理,确保了数据的一致性和可靠性。

在数据操作流程中,当客户端请求写入或读取数据时,Ceph会根据CRUSH算法和PG分布策略定位到相应的OSD,然后执行相应的操作。数据的写入通常涉及多副本,以实现高可用性。在集群维护方面,Ceph能够自我修复,如果某个OSD故障,系统会自动将数据重新分布到其他健康的OSD上,保证服务不中断。

Ceph的高层应用接口包括RADOS Gateway(用于对象存储)、RBD(Reliable Block Device,用于块存储)和CephFS(用于文件系统存储),这使得Ceph能够适应多种应用场景。RADOS Gateway使得Ceph能够兼容S3或Swift等云存储接口,RBD可以作为块设备供虚拟机或应用程序直接使用,而CephFS则提供了标准的文件系统接口,便于用户以熟悉的方式访问存储。

Ceph的分布式架构、CRUSH算法和PG分布策略共同构建了一个高性能、高可用且易于扩展的存储解决方案。由于其特性,Ceph在云计算和大规模数据存储场景中具有广泛的应用潜力。对于希望构建高效、稳定且灵活的存储基础设施的组织来说,Ceph是一个值得考虑的选择。

2018-12-12 上传

110 浏览量

2021-10-12 上传

2019-01-17 上传

2018-11-11 上传

2018-12-27 上传

2021-10-13 上传

taolaning

- 粉丝: 3

- 资源: 4

最新资源

- 高清艺术文字图标资源,PNG和ICO格式免费下载

- mui框架HTML5应用界面组件使用示例教程

- Vue.js开发利器:chrome-vue-devtools插件解析

- 掌握ElectronBrowserJS:打造跨平台电子应用

- 前端导师教程:构建与部署社交证明页面

- Java多线程与线程安全在断点续传中的实现

- 免Root一键卸载安卓预装应用教程

- 易语言实现高级表格滚动条完美控制技巧

- 超声波测距尺的源码实现

- 数据可视化与交互:构建易用的数据界面

- 实现Discourse外聘回复自动标记的简易插件

- 链表的头插法与尾插法实现及长度计算

- Playwright与Typescript及Mocha集成:自动化UI测试实践指南

- 128x128像素线性工具图标下载集合

- 易语言安装包程序增强版:智能导入与重复库过滤

- 利用AJAX与Spotify API在Google地图中探索世界音乐排行榜