Hadoop MapReduce入门教程:基础与运行机制解析

需积分: 9 153 浏览量

更新于2024-09-08

收藏 761KB PDF 举报

"Hadoop MapReduce基础入门教程,涵盖了MapReduce的基本概念、运行机制以及核心流程。"

在大数据处理领域,Hadoop MapReduce扮演着至关重要的角色。它是一种分布式计算框架,使得用户能够轻松地处理和分析海量数据。MapReduce的设计理念是将复杂的分布式运算过程简化,让开发者可以专注于业务逻辑,而将底层的并行处理和容错管理交给框架自身。

1.1、什么是MapReduce

MapReduce是Hadoop生态系统中的核心组件之一,负责分布式数据处理。它将大任务分解为小任务(map阶段),并在多台机器上并行处理,然后将结果进行整合(reduce阶段)。通过这种模式,MapReduce使得处理海量数据变得可能,尤其是在单机无法应对的情况下。

1.2、为什么需要MapReduce

面对不断增长的数据量,传统的单机处理方式由于硬件限制难以胜任。MapReduce的出现解决了这一问题,它允许开发者将程序分布在大规模集群上运行,大大提升了处理能力。同时,MapReduce抽象了分布式计算的复杂性,使开发者可以专注于编写map和reduce函数,降低了开发难度。

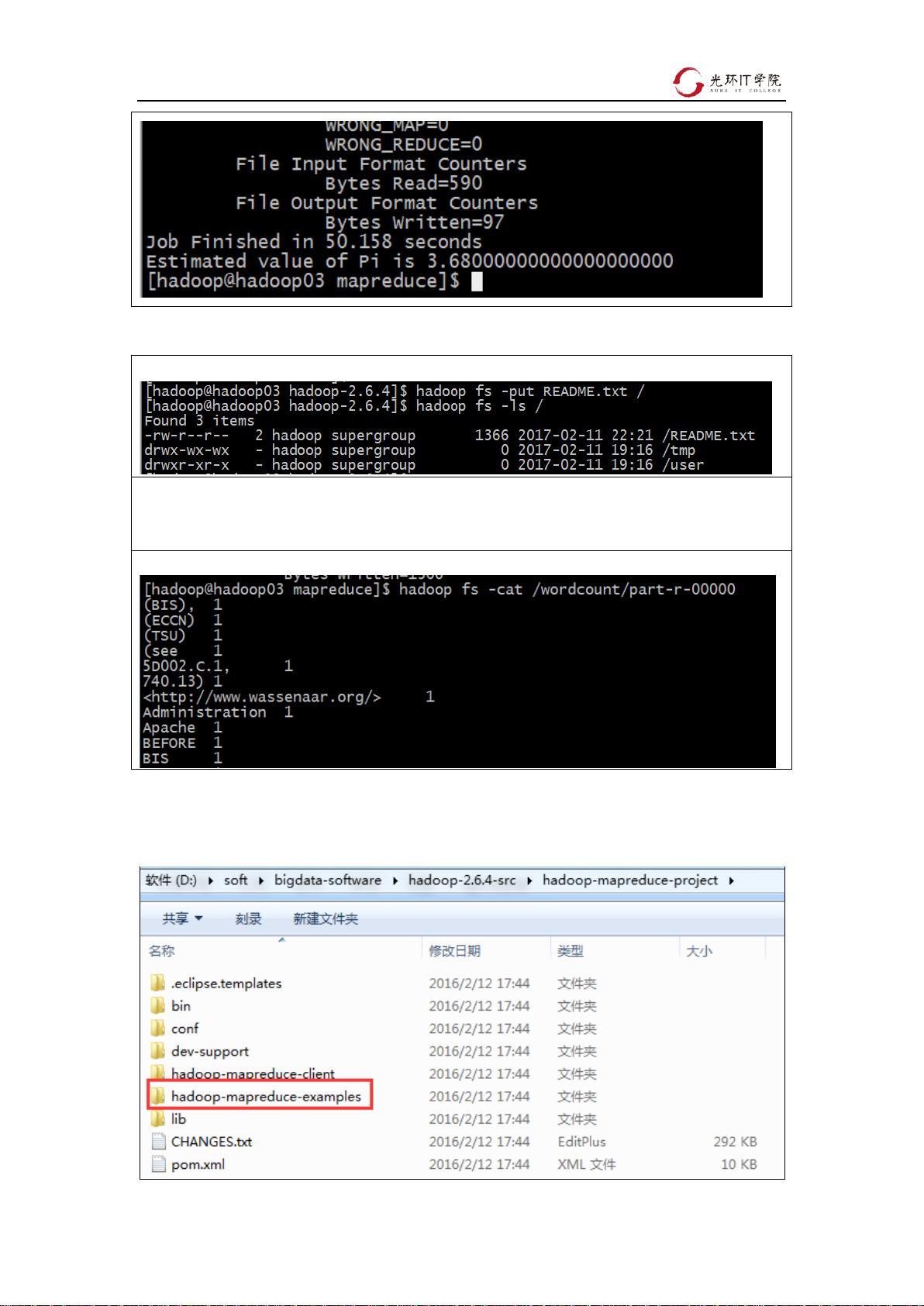

1.3、MapReduce程序运行演示

MapReduce的工作流程通常包括以下步骤:数据读取、split、map、shuffle、reduce和写入结果。map阶段,输入数据被分割为多个块,每个块由一个map任务处理;reduce阶段,map的输出经过排序和分区,作为reduce任务的输入,进行聚合操作。

1.4、MapReduce示例程序编写及编码规范

编写MapReduce程序时,需要实现Map和Reduce接口,定义键值对的映射和化简逻辑。此外,还需遵循一定的编码规范,如合理设置输入输出格式,正确处理数据类型转换,以及优化性能等。

1.5、MapReduce运行方式及Debug

MapReduce程序可以本地运行、伪分布式运行或完全分布式运行。调试MapReduce程序通常涉及到日志查看、错误定位和程序状态监控,通过Hadoop提供的工具如JobTracker或YARN Resource Manager可以查看作业状态和进度。

2.1、MapReduce程序的核心运行机制概述

MapReduce的核心机制包括数据分片、map任务分配、数据交换(shuffle)和reduce任务执行。这些过程确保了数据的并行处理和结果的正确性。

2.2、MapReduce程序的运行流程

数据首先被HDFS分片,map任务在各个节点上并行执行,生成中间结果;接着,shuffle阶段将中间结果按照key排序并分发到对应的reduce任务;最后,reduce任务聚合这些数据并产生最终输出。

2.3、MapTask并行度决定机制

MapTask的并行度取决于输入数据的大小和HDFS的块大小,以及集群中可用的任务槽位。

2.4、切片机制

切片是Hadoop将输入文件分成适合map任务处理的块的过程。每个map任务处理一个或多个切片,切片大小由InputFormat类确定。

2.5、MapTask并行度经验之谈

优化MapTask并行度可以提高整体效率,但过多的map任务可能导致资源浪费。合理的并行度应考虑集群资源和数据分布情况。

2.6、ReduceTask并行度决定机制

ReduceTask的数量通常是用户预先设定的,它影响了数据的聚合和输出阶段的并行性。减少reduce任务数量可以减少通信开销,但可能会限制并行性,增加计算时间。

Hadoop MapReduce提供了一种高效、可扩展的处理大数据的方案,通过将复杂的分布式计算抽象化,使得开发者可以更加专注于数据处理的业务逻辑,而不是底层的分布式实现细节。了解和掌握MapReduce的基本原理和运行机制,对于开发大规模数据处理应用至关重要。

2025-03-10 上传

2025-03-10 上传

2025-03-10 上传

2025-03-10 上传

zt110e5

- 粉丝: 1

最新资源

- 企业网络搭建实践方案:eNSP课程设计深度解析

- 利用Facebook API获取数据并生成PDF月报

- NHS.UK原型套件:创建交互式原型与安全性指南

- 全面的校园网络规划指南及 pkt 工具应用

- Delphi新手入门至高手的精要指南

- IIS部署Asp.Net Core 2.1.1需安装DotNetCore.2.0.8-WindowsHosting

- Suddenlink通信视频策略分析与客户价值提升

- CloudyTabs:轻松管理iCloud标签的菜单栏工具

- 工控机网卡唤醒功能的实用测试工具介绍

- PDFXViwer:高效PDF阅读与注释工具推荐

- MapWinGIS开发实例:图例展示技巧

- npm-audit-reporter-teamcity:实现在TeamCity中自动代码检查

- 安卓端学生管理系统的开发与应用

- Timm图像模型库指南:掌握深度学习图像处理

- 初学者易上手的JSP+Access网上书店教程

- Hive大数据开发工具包apache-hive-2.3.9-bin安装教程