Spark与Shark:集群计算与Hive工具详解

"Spark是一个开放源码的集群计算系统,专注于提高数据分析的速度,通过内存计算和简洁的API实现。Spark最初设计用于迭代算法和交互式数据挖掘,速度比Hadoop快很多。Spark支持在Mesos集群框架上运行,并且与Hadoop数据源兼容。Shark是基于Spark的,与Apache Hive兼容的数据仓库系统,提供更快的查询速度。Spark的机制基于无循环的数据流模型,但通过RDD(弹性分布式数据集)提供容错性和高效的内存计算,适合迭代和多查询场景。"

**一、Spark简介**

Spark作为一个高性能的集群计算框架,主要目标是提升数据分析的效率。它通过内存计算来加速数据处理,避免频繁的磁盘I/O,从而显著提升查询速度。Spark用Scala编写,提供了简洁的API接口,不仅支持Scala和Java,还允许通过Scala命令行进行大数据集的查询。Spark特别适合处理需要多次数据迭代的算法,如机器学习和图挖掘,以及交互式数据分析,其性能在这些场景下远超Hadoop。

**二、Spark机制介绍**

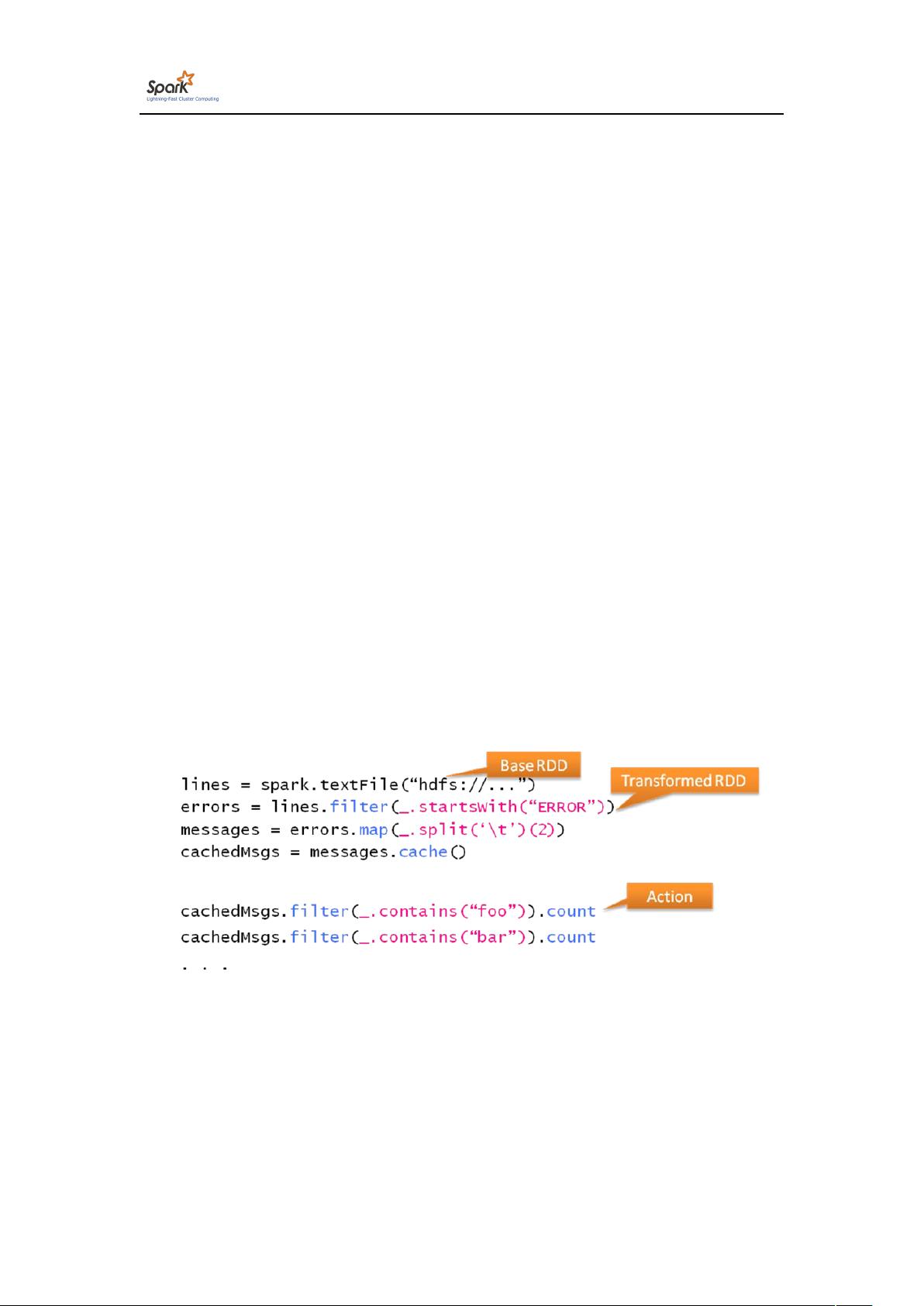

Spark的核心编程模型是基于弹性分布式数据集(RDD),这是一种容错的数据结构,可以在内存中高效处理。RDD允许数据在计算过程中被持久化,减少了对磁盘的依赖。此外,Spark支持动态调度,可以自动决定任务在集群中的执行位置,增强了系统的容错能力。相比传统的基于磁盘的数据流模型,Spark更适合需要多次聚合查询的在线分析处理(OLAP)场景。

**三、Spark的部署**

Spark的部署可以灵活地在多种环境中进行,包括独立模式、Hadoop YARN、Apache Mesos或者Kubernetes。在Mesos上,Spark能够利用其资源管理功能,实现跨应用共享集群资源。

**四、Spark支持的应用**

1. **Pregel on Spark (Bagel)**:Spark提供了对图计算的支持,Bagel是基于Pregel的分布式图计算框架,允许在Spark上执行大规模的图算法。

2. **Hive on Spark (Shark)**:Shark是AMPLab开发的,它是Apache Hive的快速版本,完全兼容Hive的查询语言(HQL),但利用Spark的计算引擎实现了更快的查询性能。

- **Shark架构**:Shark通过在Spark上运行Hive查询,利用Spark的内存计算优势,减少磁盘I/O,提高了数据仓库查询的效率。

- **执行SQL over RDDs**:Shark使得用户可以直接在RDD上执行SQL查询,简化了数据分析过程。

- **机器学习支持**:Spark还提供了MLlib库,支持多种机器学习算法,结合Shark可以加速机器学习任务的执行。

**五、性能对比与Shark的部署**

Spark的性能优势在与Hadoop的比较中尤为明显,尤其是在迭代计算和交互式查询上。Shark的部署通常涉及到配置Hive与Spark的集成,使得Hive查询可以直接利用Spark的计算能力。

**总结**

Spark的出现革新了大数据处理领域,它的内存计算和高效的编程模型使其成为大数据分析的首选工具。Shark作为Spark上的Hive加速器,进一步提升了数据仓库的查询速度。Spark的广泛应用和持续优化,使其在数据科学、机器学习和实时分析等多个领域都有广泛的影响。

2024-07-12 上传

2018-03-16 上传

2021-01-07 上传

2024-03-08 上传

2021-04-03 上传

2017-04-27 上传

2021-01-07 上传

2020-09-30 上传

2021-01-07 上传

zhengjian8972

- 粉丝: 0

- 资源: 4

最新资源

- 构建基于Django和Stripe的SaaS应用教程

- Symfony2框架打造的RESTful问答系统icare-server

- 蓝桥杯Python试题解析与答案题库

- Go语言实现NWA到WAV文件格式转换工具

- 基于Django的医患管理系统应用

- Jenkins工作流插件开发指南:支持Workflow Python模块

- Java红酒网站项目源码解析与系统开源介绍

- Underworld Exporter资产定义文件详解

- Java版Crash Bandicoot资源库:逆向工程与源码分享

- Spring Boot Starter 自动IP计数功能实现指南

- 我的世界牛顿物理学模组深入解析

- STM32单片机工程创建详解与模板应用

- GDG堪萨斯城代码实验室:离子与火力基地示例应用

- Android Capstone项目:实现Potlatch服务器与OAuth2.0认证

- Cbit类:简化计算封装与异步任务处理

- Java8兼容的FullContact API Java客户端库介绍