Linux下CentOS7部署Spark2.4.0分布式集群教程

需积分: 12 141 浏览量

更新于2024-09-05

收藏 761KB DOCX 举报

本文档详细记录了在Linux环境下搭建Spark开发环境,特别是在完全分布式集群下的步骤。作者分享了自己学习过程中的心得,并鼓励读者提出意见和问题以便及时修正。文章主要分为三个部分:JDK环境的安装与配置、Scala的安装与配置以及Hadoop的安装与配置。

1. **JDK环境的安装与配置**

- 首先,作者推荐从Oracle官网下载Java Development Kit (JDK) 1.8.0_171,并将其解压至`soft`目录。

- 接下来,设置环境变量,确保系统可以识别JDK路径。通过执行`java-version`命令来验证安装和配置是否正确。

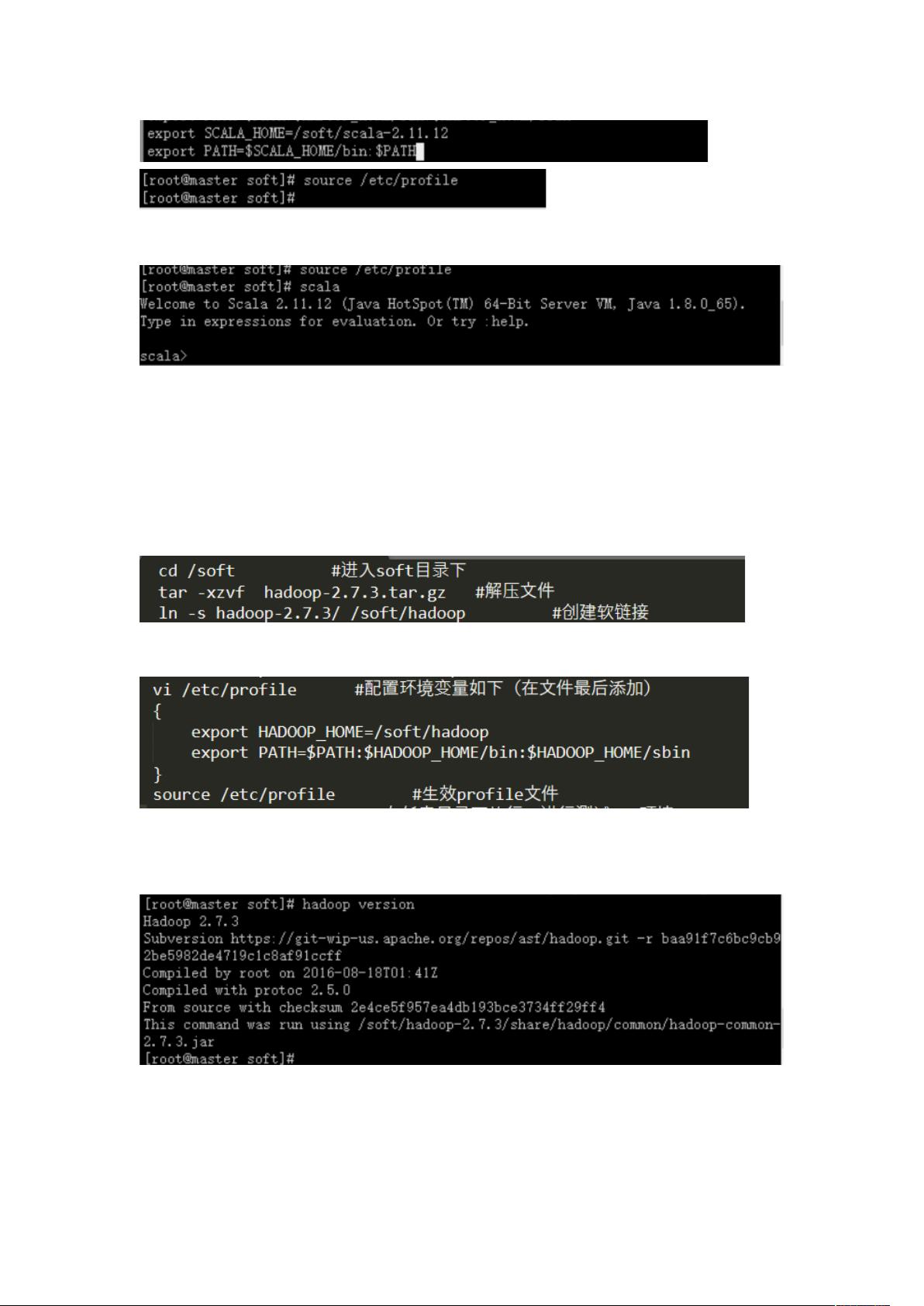

2. **Scala的安装与配置**

- 作者使用Scala 2.11.12版本,从官方网站下载并解压到`soft`目录。

- 在`/etc/profile`文件中添加Scala的环境变量配置,通过执行Scala版本检查命令进行测试。

3. **Hadoop的安装与配置**

- 从Apache Hadoop官网下载Hadoop 2.7.3版本,并解压到`soft`目录。

- 安装完成后,设置环境变量,然后执行`hadoopversion`命令验证Hadoop的安装。

- 对于完全分布式环境,文章提到需在多台CentOS上克隆Hadoop集群,将它们分别配置为master、slave1和slave2,调整各自的IP地址。

在整个过程中,作者强调如果有任何疑问或错误,读者可以通过私信与作者联系,以便及时解决问题。此外,作者也提醒读者在引用文章时务必标明出处,体现了良好的学术诚信。

这篇文档对于想要在Linux环境中搭建Spark开发环境,尤其是对分布式集群有一定需求的学习者来说,提供了实用且详尽的指导。通过跟随这些步骤,读者能够建立起一个稳定的基础环境,为后续Spark应用的开发打下坚实基础。

116 浏览量

2022-11-27 上传

150 浏览量

591 浏览量

729 浏览量

576 浏览量

625 浏览量

113 浏览量

620 浏览量

fy_1852003327

- 粉丝: 199

- 资源: 44

最新资源

- 基于Laravel 8.x的API接口签名认证系统

- PayPal-NET-SDK:用于PayPal RESTful API的.NET SDK

- aireACUMAR:阿卡马尔(ACUMAR)的拿破仑日报

- 广告说服观点

- 基于深度置信网络的多输入单输出回归预测(DBN)(Matlab完整程序和数据)

- decisionmaker:一个微型的Web应用程序,可以帮助您做出决策

- redditclone实践:遵循Spring Boot和Angular教程-通过freeCodeCampprogrammingtechie构建Reddit克隆(编码项目)

- pokemon-weakness-android:Pokemon Weakness的Android应用程序的源代码-Android application source code

- jsonlines:python库可简化jsonlines和ndjson数据的使用

- leetcode答案-EulerFS:欧拉FS

- AmazonS3Client.rar

- go-migrate:用Go编写的抽象迁移框架

- 监控视频.dav文件转码工具,支持转换为多种格式(MP4、AVI、WMV、MXF、GIF、DPG、MTV、AMV、SWF等)

- CM回购

- babel_pug_project:使用babel,pug,node,express进行Web服务器教育

- STNFCSensor_Android:ST NFC Sensor Android应用程序源代码-Android application source code