多变量线性回归与梯度下降法解析

下载需积分: 10 | DOC格式 | 5.25MB |

更新于2024-09-11

| 132 浏览量 | 举报

"Stanford University机械学习笔记,涵盖了多变量线性回归、梯度下降法及其在多变量线性回归中的应用,以及特征缩放和学习率的影响。笔记旨在通过实例解释复杂的机器学习概念,包括如何优化参数和提高计算效率。"

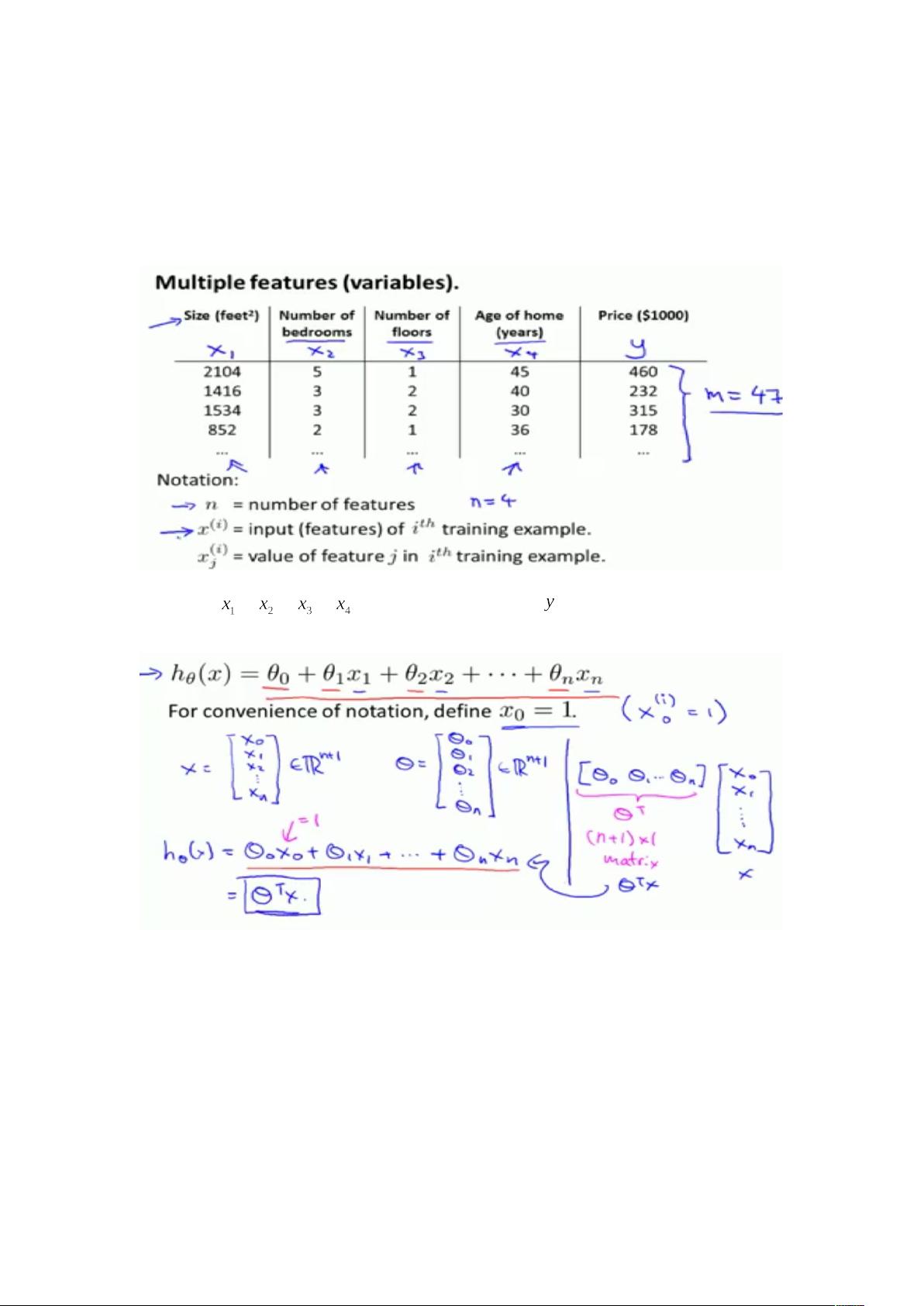

在机械学习领域,多变量线性回归是一种常见的预测模型,用于分析多个输入变量(自变量)如何影响一个输出变量(因变量)。在房价预测的例子中,房屋的卧室数量、楼层和房龄都是可能影响房价的因素。多变量线性回归函数将这些自变量与一个常数项结合,形成如下方程:

\[ \hat{y} = \theta_0 + \theta_1x_1 + \theta_2x_2 + \theta_3x_3 + ... \]

其中,\(\hat{y}\) 是预测的房价,\(\theta_0\) 是截距,\(\theta_1, \theta_2, \theta_3, ...\), 分别对应每个自变量\(x_1, x_2, x_3, ...\)的权重。

梯度下降法是求解多变量线性回归模型参数的常用方法。在多变量函数中,它通过迭代更新每个\(\theta\)的值,使其朝着代价函数(例如均方误差)最小的方向移动。对于每个\(\theta\),其更新规则与单变量线性回归类似,只是扩展到了多维空间。

特征缩放是提高梯度下降效率的技巧,通过对特征进行标准化,将它们的值约束在[0, 1]或接近[-1, 1]的范围内。这有助于加快算法的收敛速度,因为较小的特征值差异可能导致梯度更新步长过大,从而错过最优解。

均值归一化是另一种特征预处理方法,它不仅限制特征的范围,还减去每列样本的平均值,除以最大值和最小值的差,以消除特征的尺度影响:

\[ z = \frac{x - \mu}{\sigma} \]

这里,\(z\)是归一化后的特征值,\(x\)是原始特征值,\(\mu\)是特征的平均值,\(\sigma\)是特征的标准差。

学习率是梯度下降算法中的关键参数,它决定了每次迭代时参数更新的步长。合适的\( \alpha \)可以使算法在不跳过局部最小值的情况下快速收敛。通过绘制代价函数随迭代步数的变化图,可以直观地判断算法是否正常工作。理想的轨迹应该是代价函数值随迭代减少,并在后期逐渐趋于平稳。当连续几步的代价下降幅度小于某个阈值(如\( \epsilon \))时,可认为算法已经收敛。然而,实际操作中,监测这种微小的下降并不容易,因此通常需要调整学习率或采用其他优化策略,如动态学习率或适应性学习率算法。

相关推荐