DETR:Transformer在目标检测中的应用解析

版权申诉

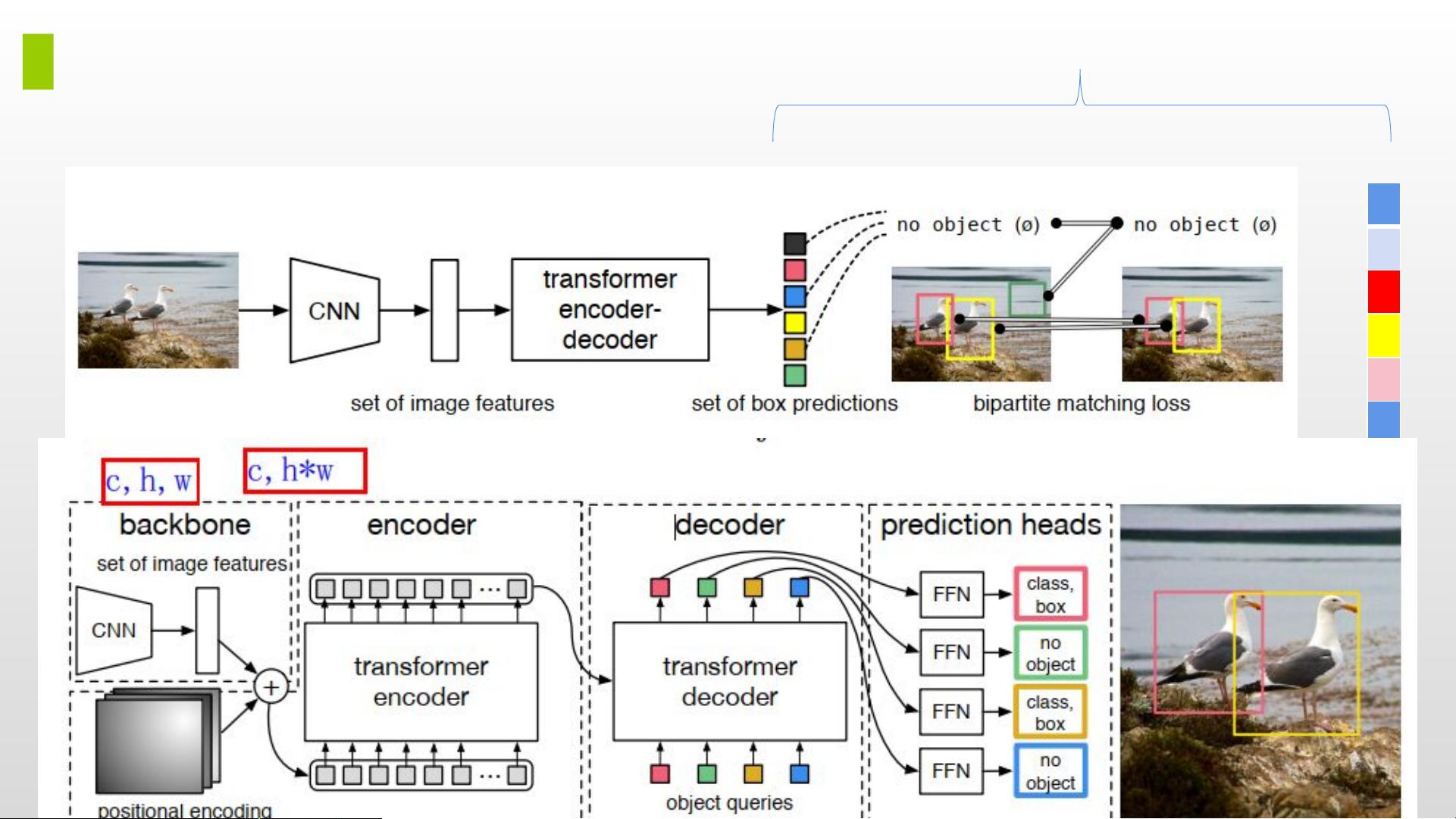

"DETR学习分享.pptx 是一份关于DETR(End-to-End Object Detection with Transformers)的文档,作者分享了如何使用Transformer架构进行端到端的目标检测。文档中详细介绍了Transformer的核心组件——多头自注意力机制,并提到了序列到序列模型在自然语言处理和计算机视觉中的应用。此外,还探讨了位置编码(Positional Encoding)的重要性,它是Transformer模型中捕捉序列顺序的关键部分。"

DETR是一种基于Transformer的端到端目标检测框架,它将Transformer的强大学习能力引入到传统的目标检测任务中,消除了以往方法中对先验框的依赖,实现了从输入图像直接到预测框的转化。Transformer的核心在于自注意力机制,其工作原理如下:

1. **自注意力(Self-Attention)**: 自注意力允许模型在处理序列数据时考虑每个元素与序列中所有其他元素的关系。在这个过程中,首先通过线性变换(query、key和value)将输入表示为三个不同的向量空间。然后,计算query向量和key向量之间的点积,经过归一化(softmax函数)得到注意力权重,最后使用这些权重加权求和value向量,得到最终的注意力输出。

2. **多头自注意力(Multi-Head Self-Attention)**: 为了增强模型的表达能力,多头自注意力将自注意力操作进行了并行化,分成多个“头”执行,每个头可以学习不同的注意力模式。每头部的输出被组合在一起,形成最终的自注意力输出。

3. **位置编码(Positional Encoding)**: Transformer模型是无序的,无法捕获序列中的位置信息。因此,位置编码被加入到输入序列中,为模型提供位置信息。位置编码通常采用两种方式:直接编码(如正弦和余弦函数,对应不同位置的固定值)或归一化编码(位置与最大位置的比率)。位置编码使得模型能够区分同一元素在不同位置的情况,保持了一定的顺序敏感性。

4. **匈牙利算法(Hungarian Algorithm)**: 在DETR中,匈牙利算法用于解决目标检测中的匹配问题,即找到预测框与 ground-truth 盒子的最佳一对一匹配,以优化损失函数。

5. **Transformer Encoder**: Transformer Encoders是Transformer结构的重要组成部分,它通过自注意力层和前馈神经网络层对输入序列进行编码,提取高级特征。

DETR模型利用Transformer的强大能力解决了传统目标检测算法的复杂性,简化了流程,提高了效率,而且其设计思路对计算机视觉领域有着深远的影响。文档中链接的博客提供了更深入的细节和实现代码,有助于进一步理解DETR的工作原理和应用。

253 浏览量

1141 浏览量

441 浏览量

410 浏览量

253 浏览量

2021-10-11 上传

536 浏览量

钱多多先森

- 粉丝: 4w+

最新资源

- 项目风险管理:识别、分析与应对策略

- UCLinux内核console_v0.2详解:BF561 DSP平台串口与早期启动支持

- Eclipse高效开发快捷键指南

- PMBOK指南2000版:项目管理核心知识

- Oracle PL/SQL编程与SQL查询指南

- JBPM入门教程:从基础到实践

- 单片机驱动智能交通灯控制系统设计与应用

- 键盘大揭秘:高手不靠鼠标,掌握这20个快捷键

- J2EE集群详解:从基础到实践

- 华为HCNE题库详解:中小企业网络技术认证

- 电脑硬件故障排查全攻略:从开机到POST自检

- Jboss Rule中文版:规则引擎在业务逻辑中的复用与实现策略

- Visual Basic 6_0 & 7_0 控件全览:迎接软件工程新挑战

- MyEclipse6中JPA应用开发实战指南

- C++期末考试样卷与解答:关键知识点解析

- C/C++编程指南:从基础到高级实践