深入剖析Hadoop源代码:从HDFS到MapReduce

需积分: 9 93 浏览量

更新于2024-07-24

收藏 5.91MB DOC 举报

"Hadoop源代码分析的完整版,聚焦于Hadoop的MapReduce和HDFS组件,以及它们在分布式计算中的角色。"

在Hadoop的世界里,MapReduce和HDFS是两个核心组件,它们共同构成了大数据处理的基础。MapReduce是一种编程模型,用于大规模数据集的并行计算,而HDFS则是分布式文件系统,为海量数据提供了高容错性和可扩展性的存储解决方案。

HDFS(Hadoop Distributed File System)是受到Google的GFS(Google File System)启发而创建的。GFS是一个针对大规模数据处理设计的分布式文件系统,它能够处理非常大的文件,并且支持流式数据访问。HDFS同样设计为能够容忍硬件故障,通过数据复制来确保数据的可用性。HDFS的API使得应用程序可以透明地访问分布式存储,无需关心数据的实际位置。

MapReduce则源于Google的MapReduce编程模型,它将大型计算任务分解为一系列小的"map"和"reduce"任务,这些任务可以在集群中的多台机器上并行执行。在Hadoop中,Map阶段处理数据并生成中间结果,Reduce阶段则将这些中间结果整合为最终结果。这种模型非常适合于批处理任务,如数据分析、日志处理等。

ZooKeeper是Apache Hadoop项目中的另一个关键组件,它类似于Google的Chubby,是一个分布式协调服务,用于管理分布式应用的配置信息、命名服务、同步服务和群组服务。

HBase是Hadoop生态系统中的NoSQL数据库,它借鉴了Google的BigTable设计,提供了一个高度可扩展的列式存储系统,适用于实时读取的大型数据表。

除此之外,Hadoop生态还包括许多其他工具,如Hive,它是一个数据仓库工具,允许用户使用SQL查询Hadoop上的数据,简化了大数据分析的复杂性。

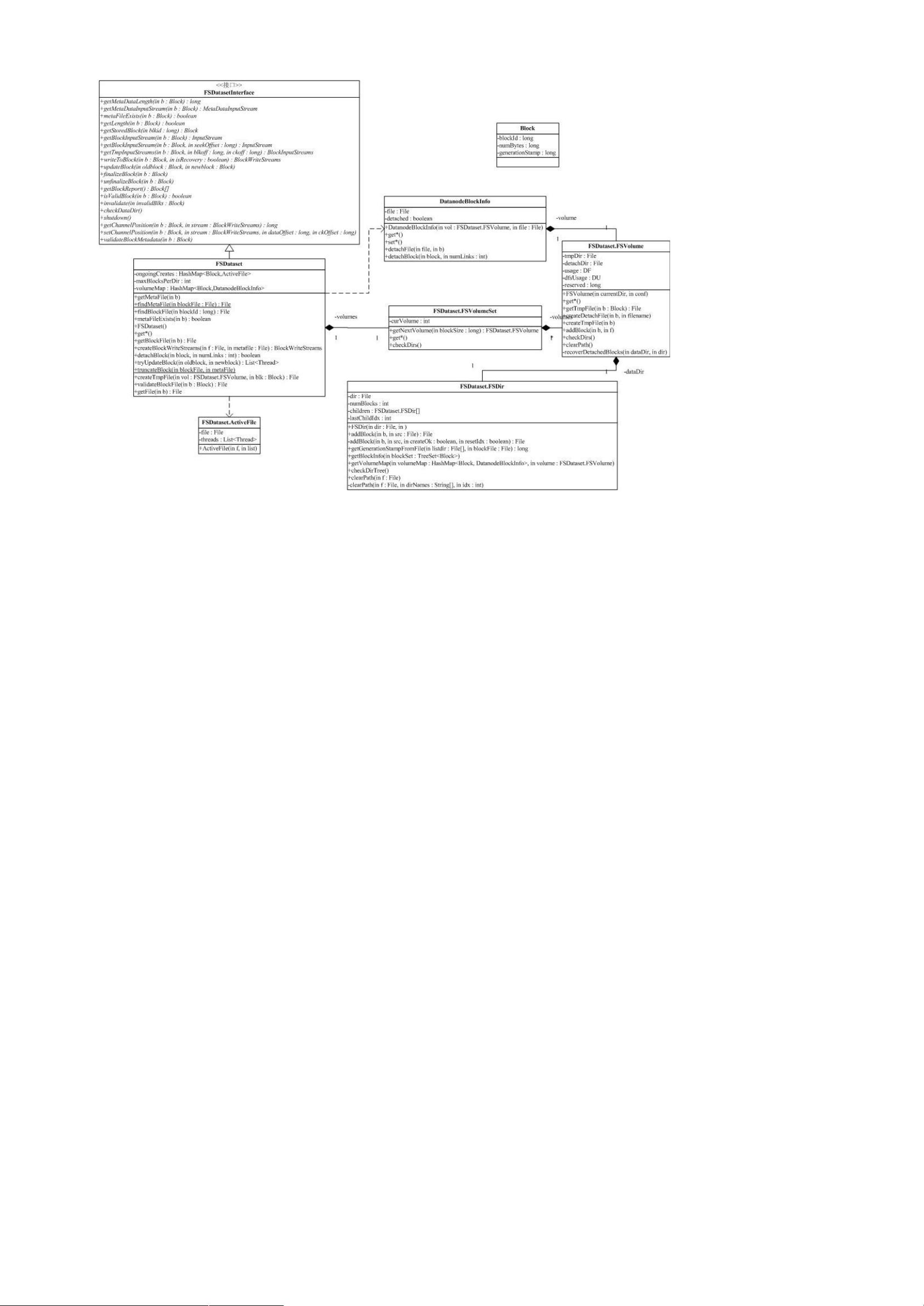

在Hadoop源代码分析中,理解包间的依赖关系至关重要。例如,conf包用于读取系统配置,它依赖于fs包来操作文件系统。这种复杂的依赖结构体现了Hadoop设计中的灵活性和功能复用。

通过对Hadoop源代码的深入分析,开发者可以更好地理解其内部工作机制,从而优化性能,调试问题,甚至开发新的功能和工具。这不仅有助于提升对分布式计算的理解,也为构建和维护大规模数据处理系统提供了基础。

2013-10-23 上传

3468 浏览量

166 浏览量

1063 浏览量

2013-09-12 上传

2022-06-18 上传

104 浏览量

liuxiaoyi216

- 粉丝: 27

- 资源: 5

最新资源

- Developmentment-school-template-:这是开发学校的静态网站

- 应用之间调用(iPhone源代码)

- Web Clipper Beta-crx插件

- FastDFS集群安装所需要的所有文件

- marklogic-workpapers:MarkLogic MEAN 堆栈应用程序

- Facebook登录页面复制

- simon:没有意义的游戏

- cp-database:编码海盗

- 易语言画心形画苹果形示爱程序-易语言

- scrcpy-win64-v1.14.zip

- Highcharts多个图表共用一个提示框,每个图表多条曲线

- Frosmo Preview-crx插件

- raxy:简单的状态管理器

- strudra:在Python中使用Ghidra结构

- GoStack-02Fundamentos-NodeJS-Desafio05:针对存储库模式的应用在NodeJS中的应用

- IP3_ALB