尚硅谷大数据技术:Flume详解

需积分: 9 141 浏览量

更新于2024-07-16

收藏 4.1MB DOCX 举报

"这份文档是关于大数据技术中的Flume的学习资料,主要介绍了Flume的基本概念、组件架构以及Source、Channel和Sink的详细功能。"

在大数据处理领域,Flume是一款非常重要的工具,由Cloudera开发,用于高效、可靠地收集、聚合和传输大量日志数据。Flume基于流式处理架构,设计简洁而灵活,适用于处理实时的日志流。

Flume的核心架构由三个主要组件构成:Source、Channel和Sink。

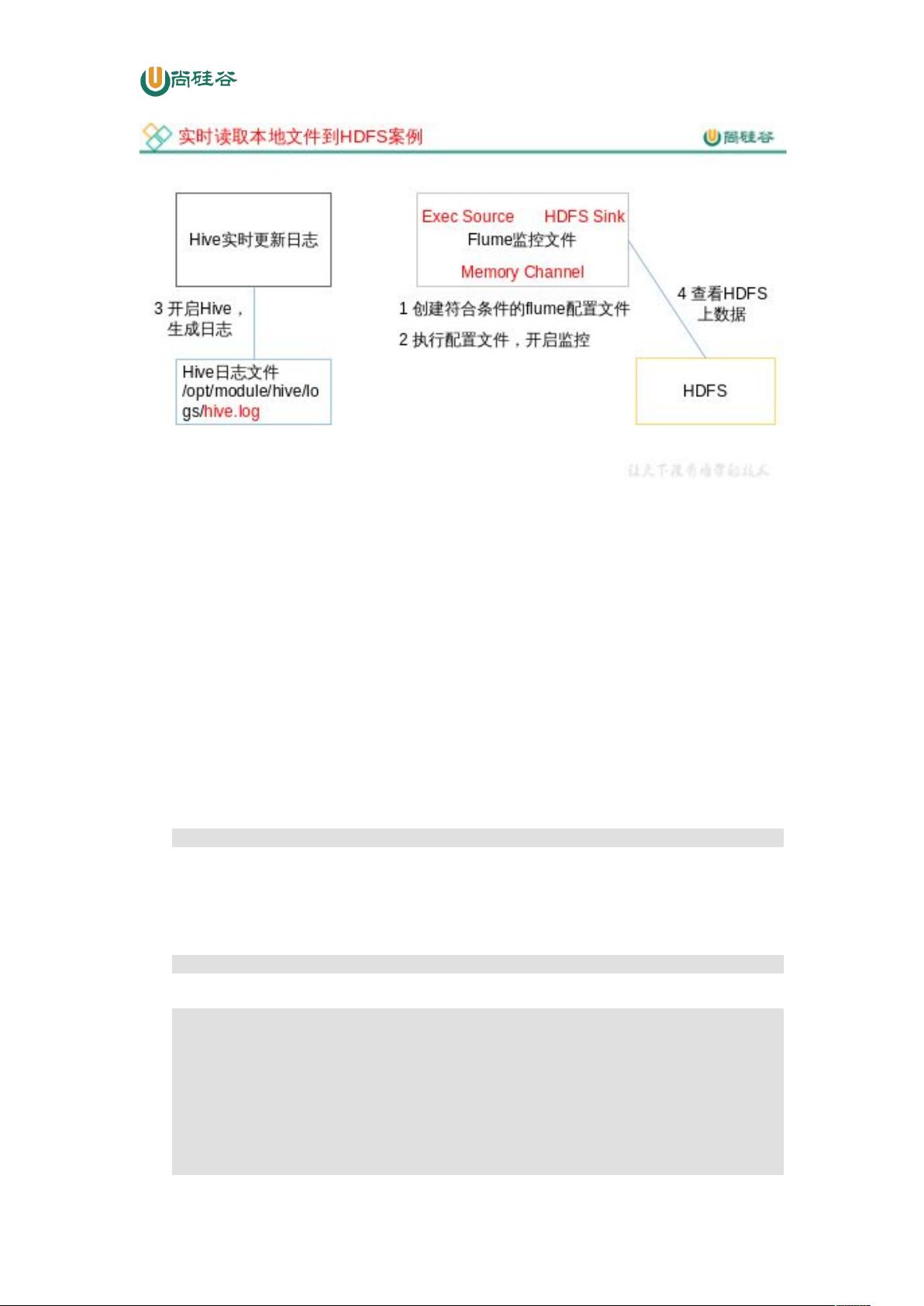

1. Source是Flume数据流入的入口,它负责从各种来源获取数据。Source支持多种类型的数据源,包括avro、thrift、exec、jms、spoolingdirectory、netcat、sequencegenerator、syslog、http和legacy等。这使得Flume能适应各种不同格式和来源的日志数据。

2. Channel是Flume架构中的数据缓冲区,它位于Source和Sink之间,起到数据中转的作用。Channel保证了即使Source和Sink的处理速度不匹配,数据也能被正确处理。Flume提供了两种内置的Channel类型:MemoryChannel和FileChannel。MemoryChannel将数据存储在内存中,适合对数据丢失不敏感的情况,但当系统崩溃时,可能会丢失数据。相比之下,FileChannel将数据写入磁盘,确保在系统故障后数据的持久性。

3. Sink是Flume架构的出口,它从Channel中取出事件并批量写入目标系统,如HDFS、logger或传递到另一个FlumeAgent。Sink的工作是事务性的,确保数据的安全传输。在写入目标系统之前,Sink会启动一个事务,一旦批量事件成功写入,就提交事务,此时Channel才会从其内部缓冲区删除这些事件。

Flume的这种设计使得它能够灵活地构建复杂的数据流管道,实现大规模数据的实时处理和传输。在大数据环境中,Flume常用于收集分布式系统的日志数据,然后将这些数据传输到分析工具或存储系统,如Hadoop HDFS,进行进一步的处理和分析。

Flume是大数据生态系统中不可或缺的一部分,它简化了日志数据的收集和管理,提高了数据处理的效率和可靠性。通过深入理解和熟练运用Flume,我们可以更有效地管理和利用大数据环境中的日志信息。

mhbin6

- 粉丝: 0

- 资源: 15

最新资源

- ajax局部刷新技术ajax局部刷新技术ajax局部刷新技术

- Linux完全教学手册.pdf

- 算法总结 排序 最短路径 枚举 排序 堆与二叉查找树 图 DFS BFS

- Data Mining - Know It All (Elsevier, 2009).pdf

- Android-Anatomy-GoogleIO-partrick.pdf

- zigbee与单片机的无线传输

- linux块设备驱动-farsight081213linuxdrive-1.pdf

- 电力系统自动装置原理学习指导

- UNIX SHELL Quote Tutorial

- 计算机操作系统(汤子瀛)习题答案

- Linux必学的重要命令

- NS2手册(中文版)

- AJAX指南(作者——王娜)

- AJAX基础教程中文版

- python入门指导

- 基于C8051F330的野战灭菌器智能模糊PID温度控制器的设计