Kettle开发与配置完全指南

"Kettle操作手册,包括安装配置和案例,适合初学者"

Kettle,全称为Pentaho Data Integration,是一种强大的ETL工具,它采用完全的Java编写,提供免费开源的解决方案,用于数据的抽取、转换和加载。这个名称来源于其创始人MATT的设想,将各种数据比作壶中的水,经过处理后按照特定格式输出。Kettle因其灵活性和易用性,在数据集成领域被广泛应用,特别是在不同数据库系统间进行数据迁移的场景。

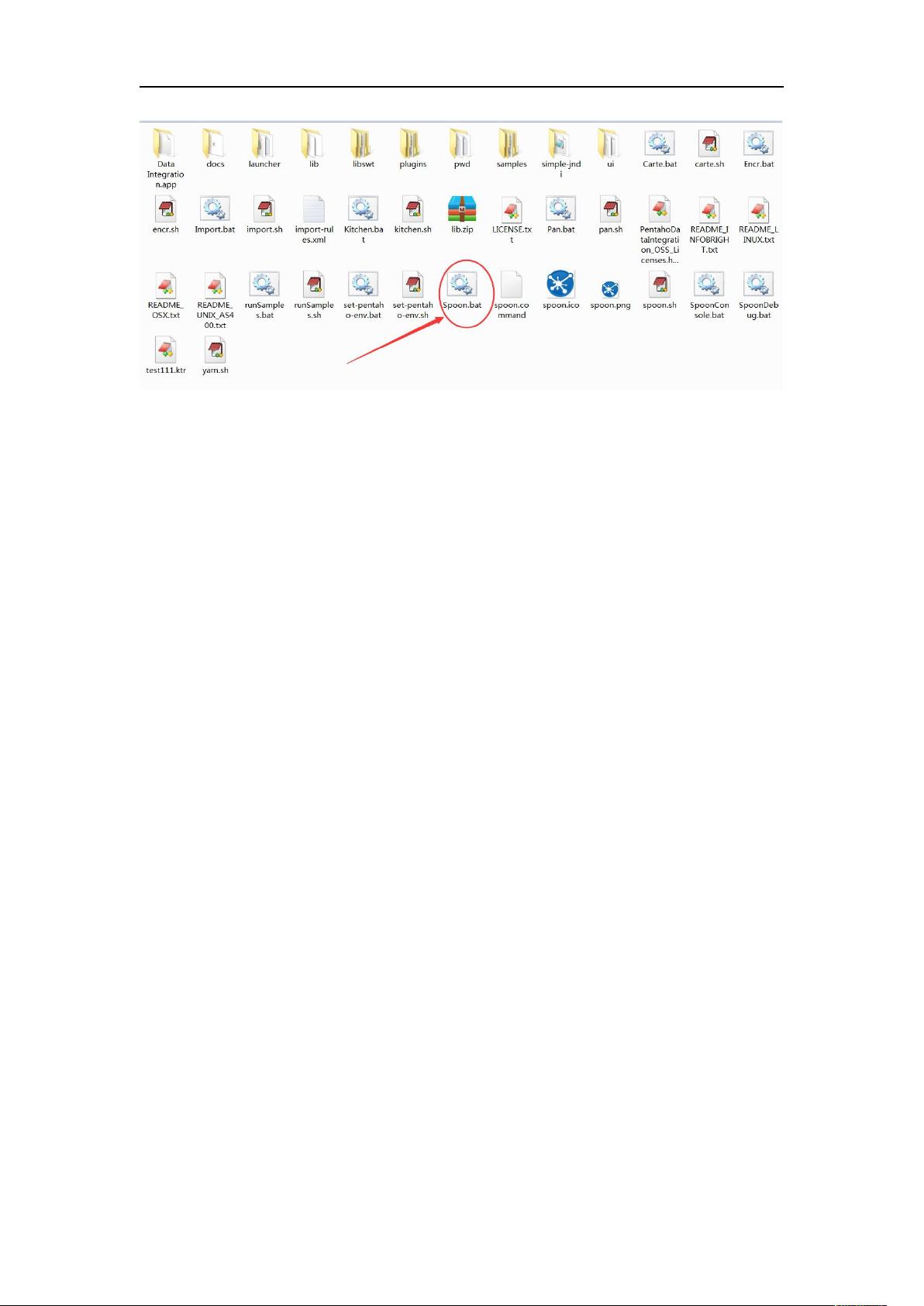

安装Kettle非常简单,只需下载相应版本的压缩包并解压,确保本地已经安装了满足要求的JDK环境(如JDK 1.6或1.7)。启动Kettle可以通过双击解压后的批处理文件spoon.bat。

Kettle的核心操作之一是使用Repository资源库来管理所有的Kettle文件。Repository是一种文件系统,用于存储和组织ETL作业和转换。创建Repository的步骤包括在工具菜单中选择“资源库”->“连接资源库”,然后新建一个kettlefilerepository,并选择一个本地目录作为根目录。连接到Repository后,用户可以在其下创建和组织作业和转换,确保与数据交换平台的目录结构一致,方便迁移和管理。

在进行数据迁移时,Kettle首先要求在目标数据库中创建与源数据库类似的表结构。例如,如果要从Oracle数据库迁移数据到Greenplum数据库,需要在Greenplum中创建与Oracle中的T_SF_DWJFDJXX_TEST表结构相同的表。这一步是数据迁移的基础,确保后续的数据加载能够正确进行。

Kettle提供了丰富的数据转换组件,如表输入、表输出、字段映射、过滤、聚合等,用户可以根据需求组合这些组件,构建复杂的ETL流程。此外,Kettle还支持通过图形化界面设计和调试转换,使得非编程背景的用户也能轻松操作。

在实际操作中,用户可以利用Kettle的作业(Job)和转换(Transformation)功能来规划和执行数据处理任务。作业通常用来协调多个转换,而转换则专注于单一的数据处理任务。通过Repository,用户可以方便地版本控制和共享这些作业和转换,实现团队协作。

Kettle是一款功能强大的ETL工具,不仅适用于数据迁移,还能处理数据清洗、数据整合等多种数据处理需求。对于初学者,Kettle提供的案例和详细的使用手册是快速上手的好资源。

2018-04-30 上传

2019-11-06 上传

2012-12-26 上传

2013-08-06 上传

2014-07-10 上传

2015-07-22 上传

2020-07-18 上传

weiranth

- 粉丝: 4

- 资源: 10

最新资源

- Raspberry Pi OpenCL驱动程序安装与QEMU仿真指南

- Apache RocketMQ Go客户端:全面支持与消息处理功能

- WStage平台:无线传感器网络阶段数据交互技术

- 基于Java SpringBoot和微信小程序的ssm智能仓储系统开发

- CorrectMe项目:自动更正与建议API的开发与应用

- IdeaBiz请求处理程序JAVA:自动化API调用与令牌管理

- 墨西哥面包店研讨会:介绍关键业绩指标(KPI)与评估标准

- 2014年Android音乐播放器源码学习分享

- CleverRecyclerView扩展库:滑动效果与特性增强

- 利用Python和SURF特征识别斑点猫图像

- Wurpr开源PHP MySQL包装器:安全易用且高效

- Scratch少儿编程:Kanon妹系闹钟音效素材包

- 食品分享社交应用的开发教程与功能介绍

- Cookies by lfj.io: 浏览数据智能管理与同步工具

- 掌握SSH框架与SpringMVC Hibernate集成教程

- C语言实现FFT算法及互相关性能优化指南