循环神经网络RNN详解:结构、特点与应用

需积分: 0 60 浏览量

更新于2024-08-05

1

收藏 694KB PDF 举报

"第六章 循环神经网络(RNN)主要介绍了RNNs与传统前馈神经网络的区别、RNNs的特点以及它们在处理序列数据中的应用,特别是其在自然语言处理(NLP)领域的成功应用,如词向量表达、语句合法性检查和词性标注等。RNNs通过引入定向循环,能够处理输入之间存在前后关联的问题,其隐藏层的节点不再是无连接的,而是允许信息在时间步之间传递,形成了具有记忆功能的网络结构。"

在深度学习领域,循环神经网络(RNNs)是处理序列数据的一种重要模型,与传统的前馈神经网络(FNNs)相比,RNNs的最大特点是引入了循环结构。FNNs遵循固定的前向传播路径,即从输入层到隐藏层再到输出层,每一层的节点之间没有直接连接。然而,RNNs则允许信息在时间步之间流动,使得当前时间步的输出不仅依赖于当前的输入,还依赖于之前时间步的输出。这种设计使RNNs能够捕获序列数据中的长期依赖关系,尤其是在处理如语言、音频或时间序列数据时非常有用。

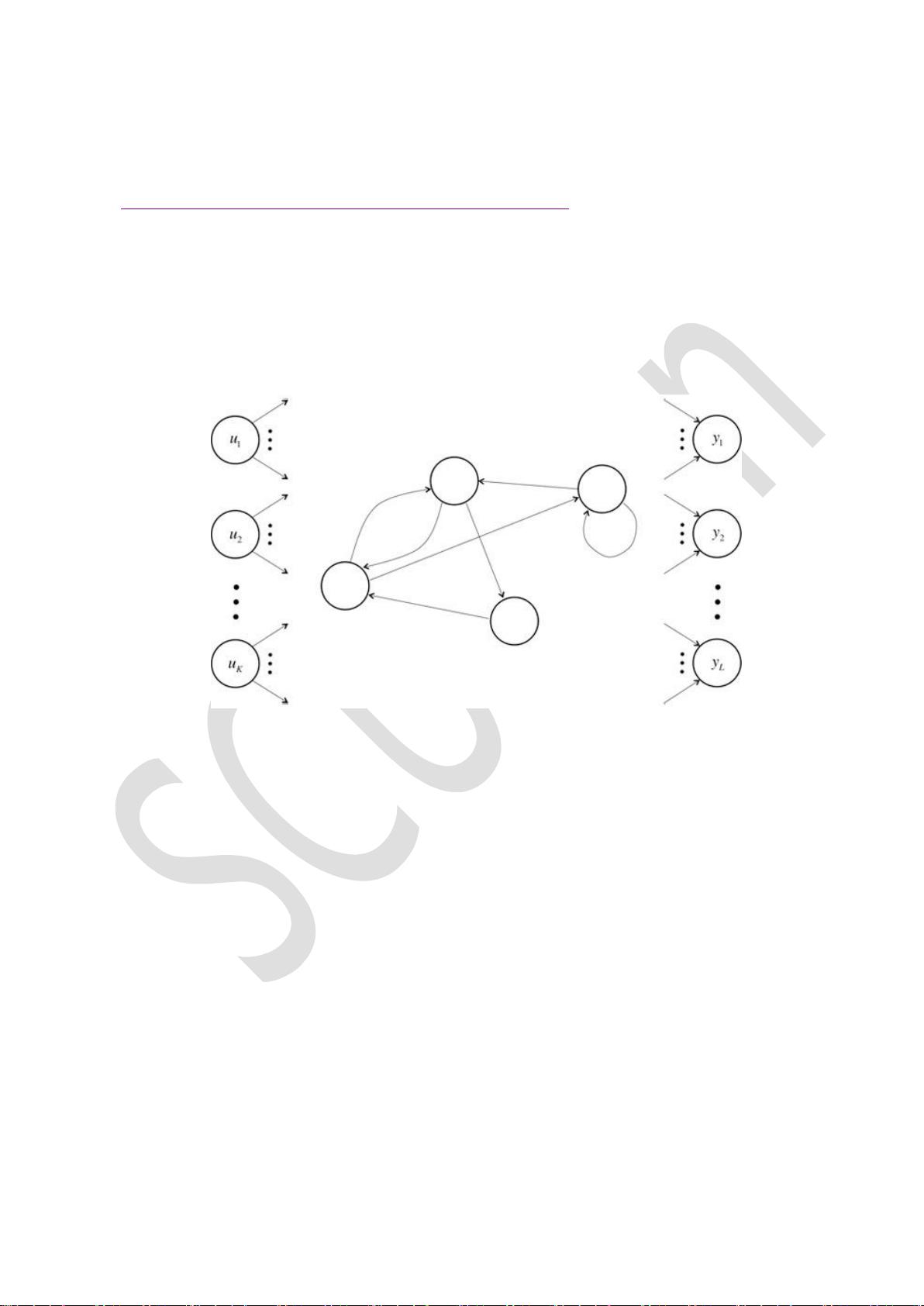

RNNs的结构通常包括输入单元、隐藏单元和输出单元。信息从输入单元单向传递到隐藏单元,再从隐藏单元传递到输出单元。此外,隐藏单元内部允许自连接和互连,这样可以存储和传递前一时刻的信息。这种机制使得RNNs能够处理任意长度的序列,虽然在实际应用中,由于梯度消失或梯度爆炸等问题,通常假设当前状态只与有限的历史状态相关。

RNNs在自然语言处理任务中表现出了强大的能力,例如,词向量表示(word embeddings)可以通过RNNs学习,捕捉词汇间的上下文关系;语句合法性检查可以利用RNNs来评估句子的语法正确性;词性标注任务中,RNNs可以分析单词上下文来确定其在句子中的角色。其中,LSTM(长短期记忆网络)作为RNNs的一个变种,特别有效地解决了长时间依赖问题,因此在许多序列建模任务中成为首选模型。

循环神经网络通过其独特的循环结构,为处理序列数据提供了一种强大而灵活的工具,尤其在处理时间序列和自然语言数据时,它的能力得到了广泛认可。不过,理解和解决RNNs的梯度消失和梯度爆炸问题仍然是研究的重要方向,以进一步提升模型的性能和稳定性。

4110 浏览量

550 浏览量

184 浏览量

182 浏览量

点击了解资源详情

点击了解资源详情

776 浏览量