迁移学习:ResNet模型在椅子识别中的微调实践

66 浏览量

更新于2024-08-30

收藏 146KB PDF 举报

"L23模型微调finetuning,涉及ResNet18模型,以及ImageNet数据集的使用,探讨了微调作为迁移学习的一种方法,用于处理中等规模数据集的问题。"

在深度学习领域,微调是迁移学习的一个重要策略,尤其在面对数据集规模介于小型和大规模之间的情况时。例如, Fashion-MNIST数据集虽小,易于训练,而ImageNet数据集则极其庞大,包含上千万张图像和数千类别,适合训练复杂的模型。但在实际应用中,我们常常遇到的是规模介于两者之间的数据集,如识别特定类型椅子的数据集。

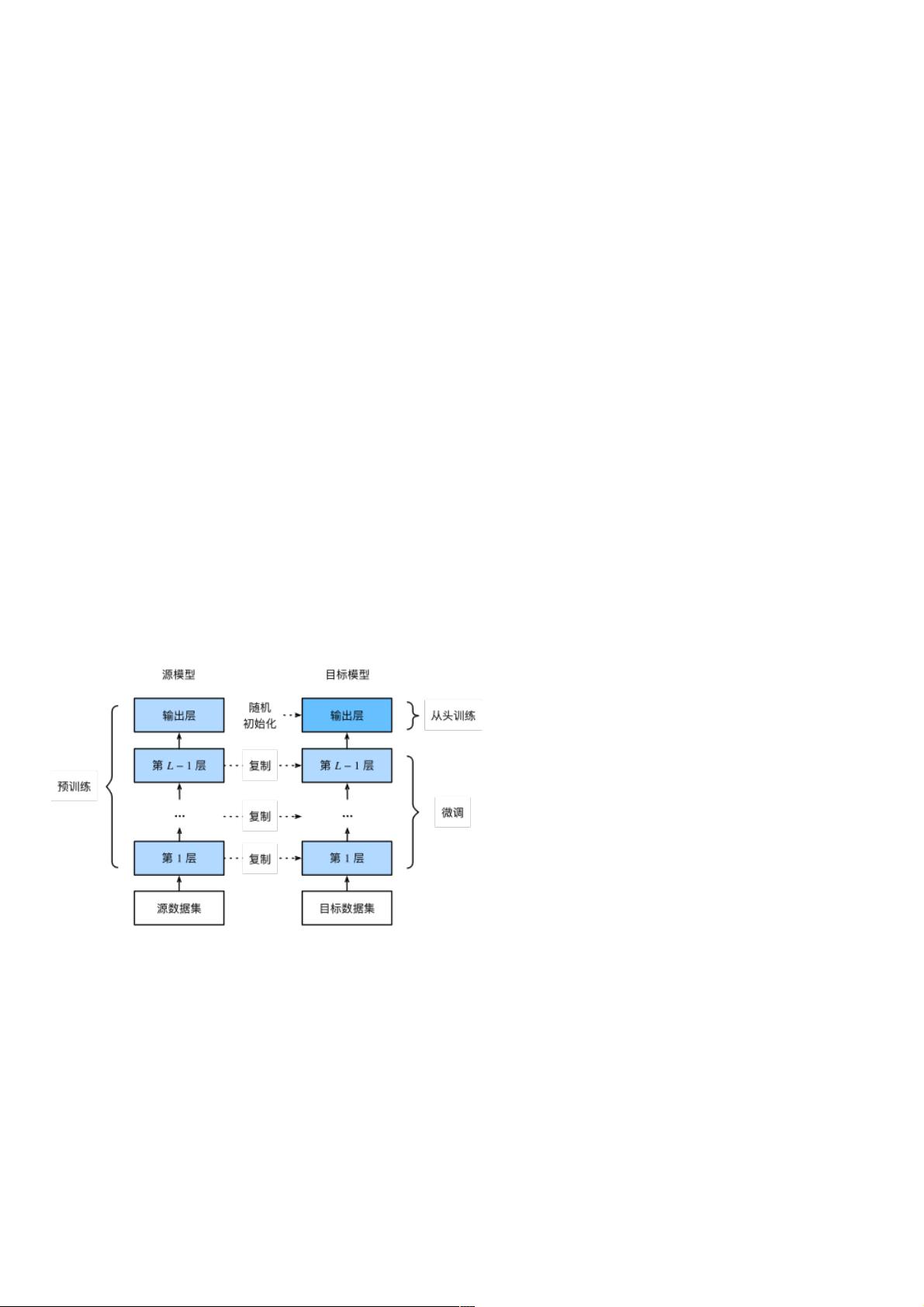

微调的基本思想是利用预训练的大型模型,如ResNet18这样的模型,该模型已经在类似ImageNet这样庞大的数据集上进行了充分的训练,学习到了丰富的视觉特征。在微调过程中,首先,我们会在源数据集(如ImageNet)上对模型进行预训练,使其掌握通用的图像表示能力。这些预训练的模型能够捕捉到图像中的边缘、纹理、形状等基本特征,这些特征对于多种任务都是通用的。

接下来,针对新的目标数据集,我们创建一个新的模型,保留预训练模型(源模型)的大部分结构和参数,但移除或替换与新任务不匹配的部分,比如最后的分类层。这是因为源模型的输出层通常是为源数据集的类别设计的,对于新的任务(如识别椅子的类别)可能并不适用。于是,我们在目标模型中添加一个新的输出层,其大小与目标数据集的类别数量相匹配,并随机初始化这个新层的参数。

在新模型构建完成后,我们使用目标数据集进行训练,只更新新增的输出层和可能需要调整的其他层(例如,有时我们会选择只微调最后几层,以防止对预训练特征的过度修改)。这种训练过程通常需要较少的迭代次数,因为模型已经从源数据集中学习到了基础的表示能力。

微调的优势在于,它能够有效利用预训练模型的知识,减少在目标数据集上训练的时间和资源。在数据量有限的情况下,微调可以帮助我们获得更好的性能,避免模型过拟合,同时提高模型泛化能力。尽管微调并非总是必要的,但对于那些数据量不足或者难以获取大量标注数据的任务,它是一种非常实用的解决方案。

2019-08-10 上传

257 浏览量

2023-06-14 上传

2021-06-18 上传

2023-04-18 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

weixin_38670531

- 粉丝: 5

- 资源: 951

最新资源

- myilportfolio

- GH1.25连接器封装PCB文件3D封装AD库

- Network-Canvas-Web:网络画布的主要网站

- 基于机器学习和LDA主题模型的缺陷报告分派方法的Python实现。原论文为:Accurate developer r.zip

- ReactBlogProject:Blog项目,测试模块,React函数和后端集成

- prefuse-caffe-layout-visualization:杂项 BVLC Caffe .prototxt 实用程序

- thresholding_operator:每个单元基于阈值的标志值

- 基于深度学习的计算机视觉(python+tensorflow))文件学习.zip

- app-sistemaweb:sistema web de citas medicasRuby在轨道上

- 记录书籍学习的笔记,顺便分享一些学习的项目笔记。包括了Python和SAS内容,也包括了Tableau、SPSS数据.zip

- bpm-validator:Bizagi BPM 验证器

- DocBook ToolKit-开源

- file_renamer:通过文本编辑器轻松重命名文件和文件夹

- log4j-to-slf4j-2.10.0-API文档-中文版.zip

- django-advanced-forms:Django高级脆皮形式用法示例

- android-sispur