深度学习基础与应用探索

需积分: 10 175 浏览量

更新于2024-07-19

收藏 6.66MB PDF 举报

"这篇文档是吴伟关于Deep Learning的简单介绍,涵盖了深度学习的基础概念、历史、无监督学习模块、构建深度网络的方法、卷积神经网络(CNN)、循环神经网络(RNN)、深度学习技巧、特征可视化、应用以及未来发展趋势。作者分享了关于自动编码器、受限玻尔兹曼机、稀疏编码、DNN、DBN、DBM、DSN、预训练技术、CNN改进策略、RNN的基本结构和BPTT算法,以及深度学习中的各种优化技巧。此外,还讨论了深度学习在声学模型、对象识别和自然语言处理等领域的应用,以及深度学习面临的挑战和未来研究方向。"

在深度学习(Deep Learning)这个领域,我们首先需要理解其定义:它是一种人工神经网络(Artificial Neural Network, ANN)的学习方法,通过多层非线性变换对复杂数据进行建模。深度学习的历史可以追溯到早期的反向传播算法(BP),并在20世纪80年代末由Geoffrey Hinton等人进一步发展。预训练和微调(pre-training and fine-tuning)是深度学习早期的重要技术,特别是在受限玻尔兹曼机(Restricted Boltzmann Machine, RBM)和自编码器(Auto-encoder)中。

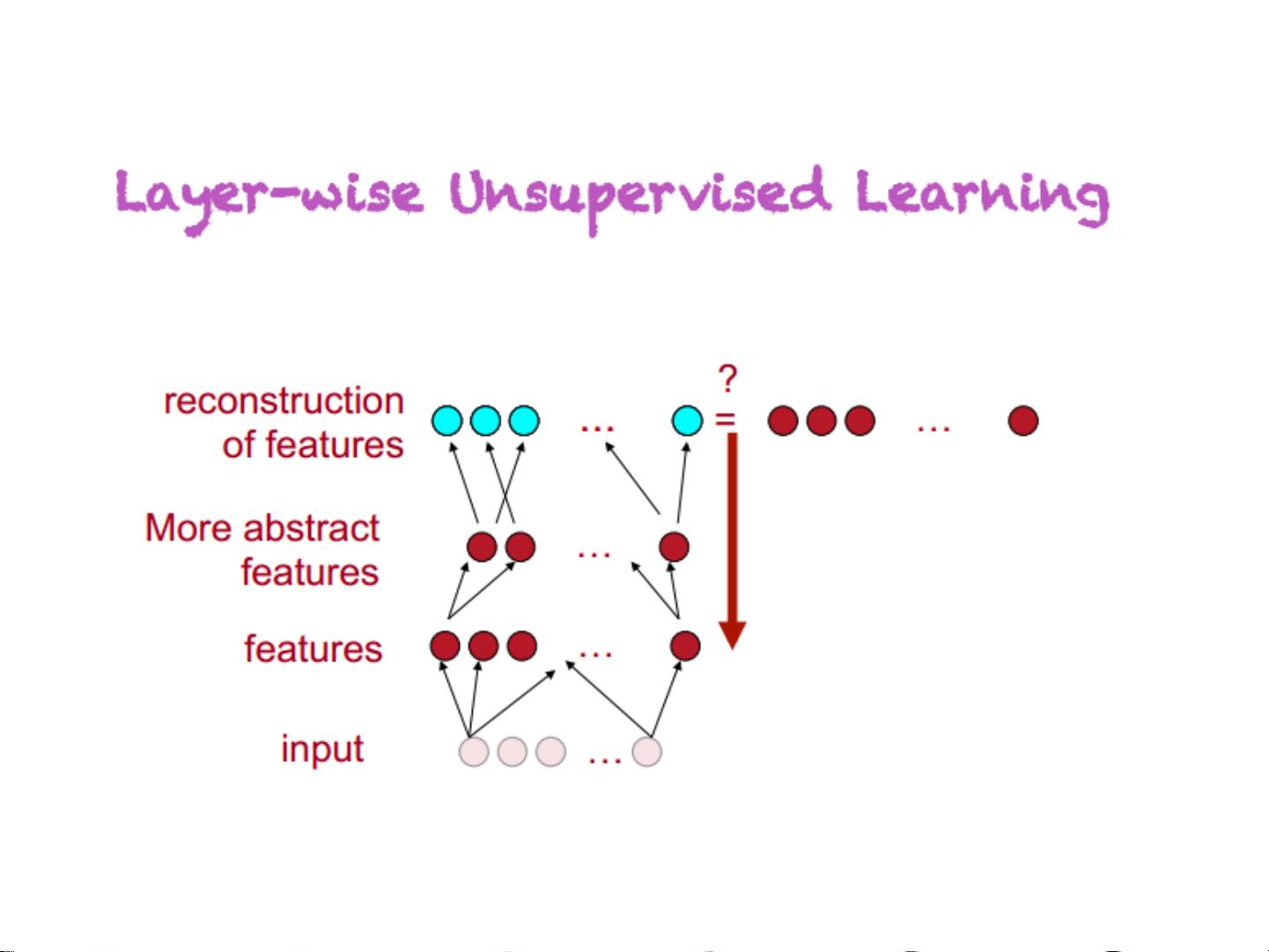

无监督学习模块主要涉及自动编码器,包括稀疏自动编码器(sparse auto-encoder)、去噪自动编码器(denoising auto-encoder)和收缩自动编码器(contractive auto-encoder)。RBM则是一种用于无监督学习的统计建模工具,常用于特征学习。此外,稀疏编码(Sparse Coding)也是一种重要的无监督学习方法。

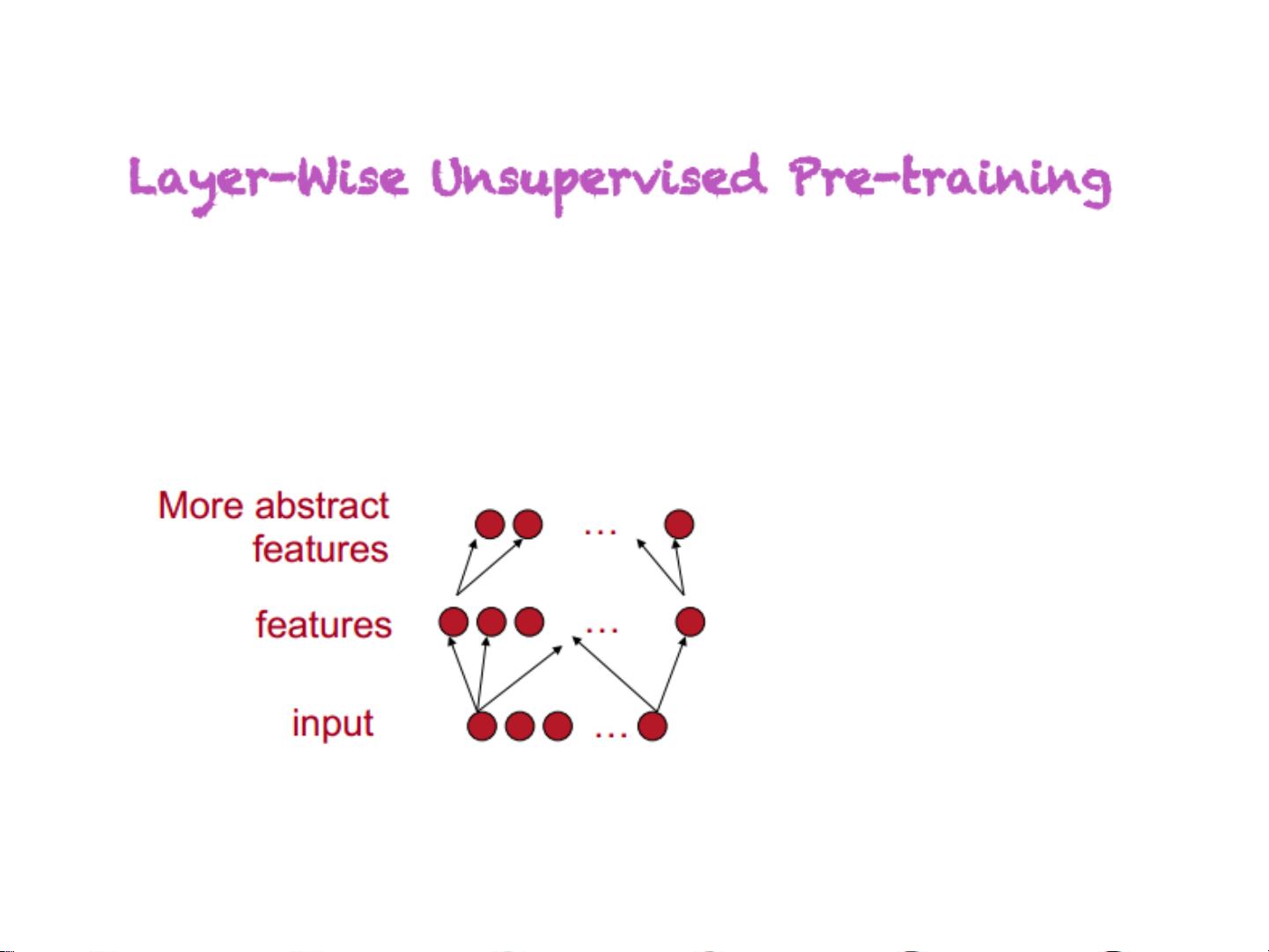

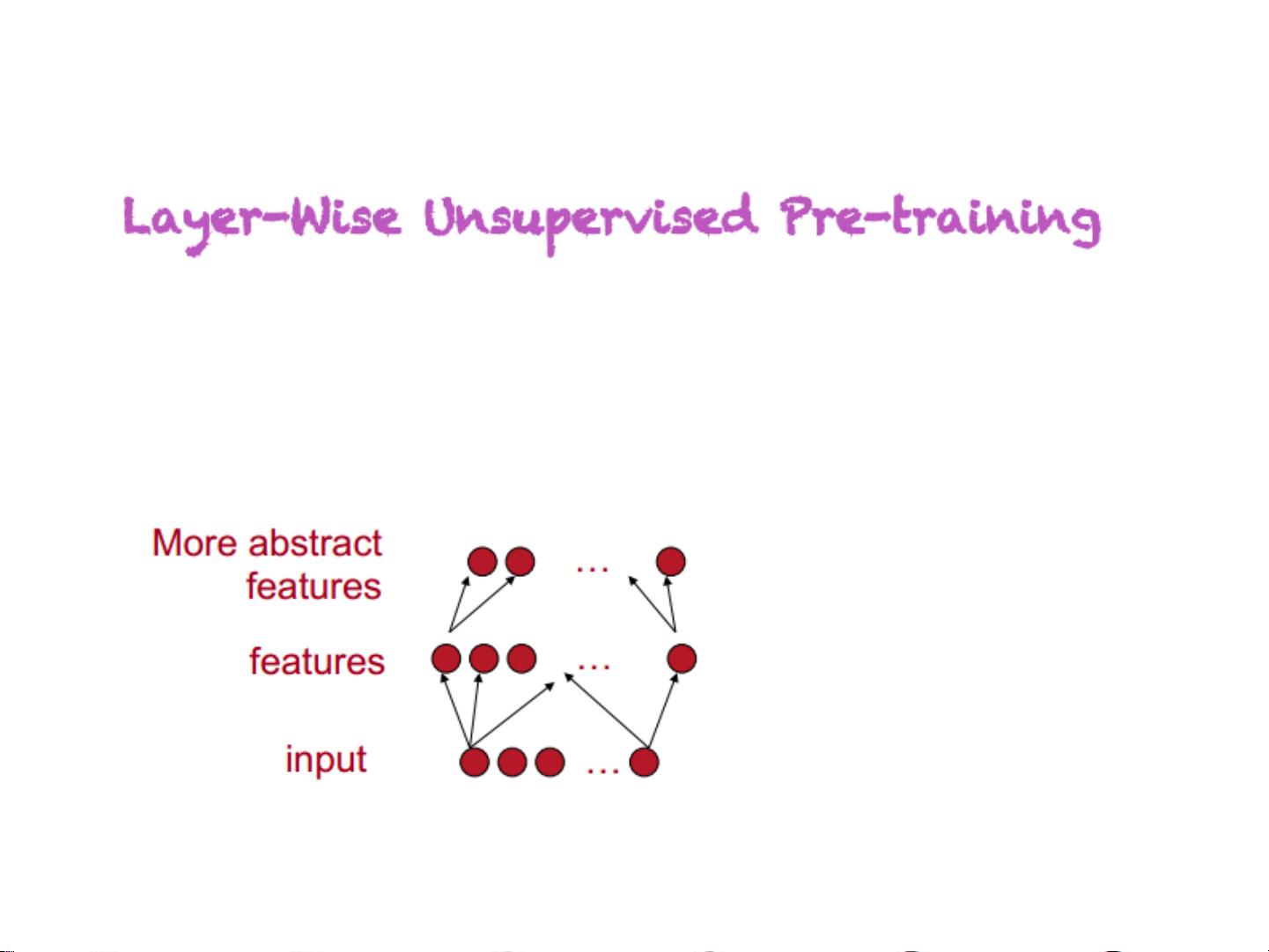

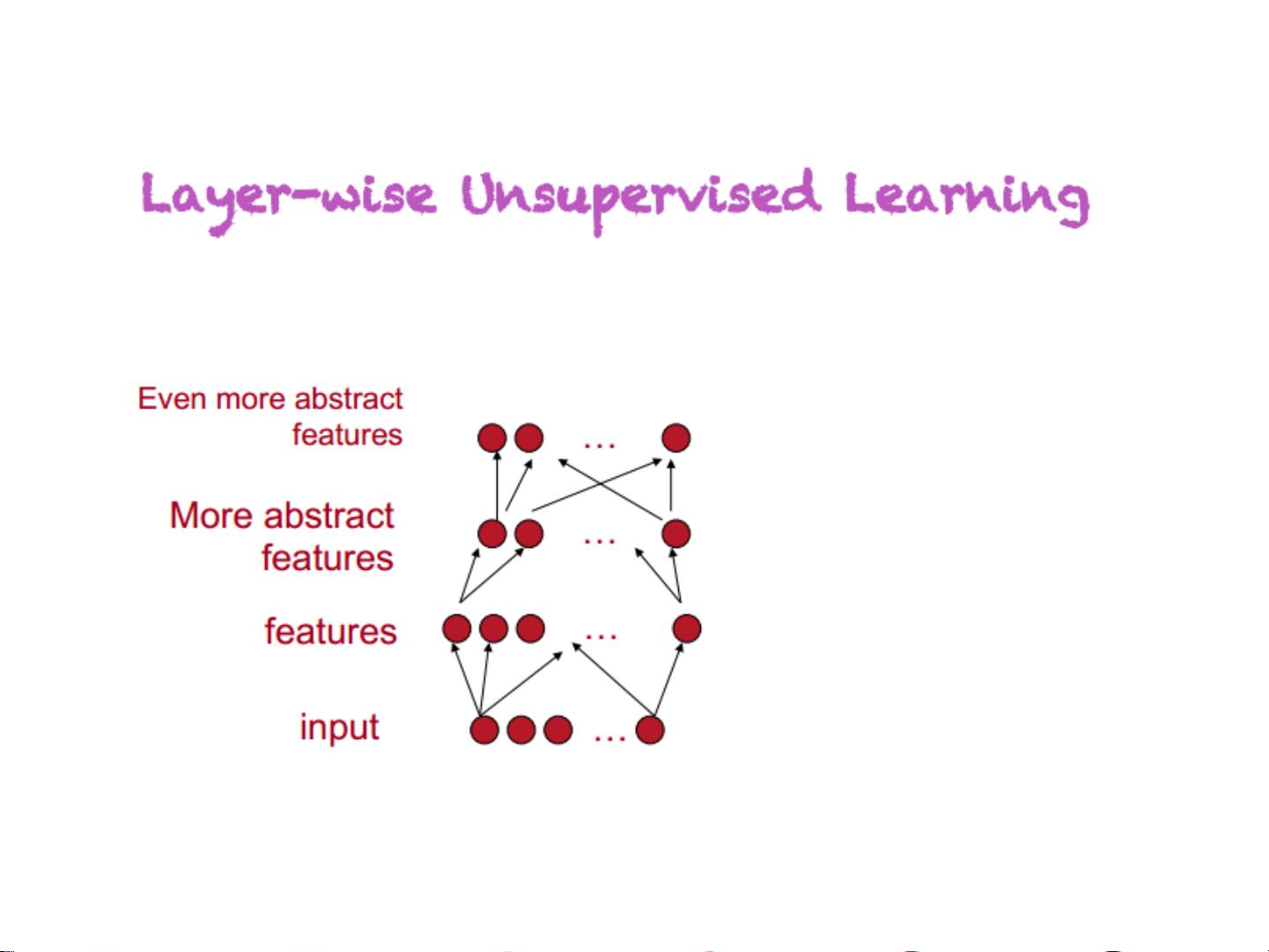

构建深度网络时,我们可以使用深度神经网络(DNN)、深度自编码器(Deep Auto-encoder)、深度信念网络(Deep Belief Network, DBN)、深度玻尔兹曼机(Deep Boltzmann Machine, DBM)和深度自相似网络(Deep Stacked Network, DSN)。这些网络结构能够捕获数据的多层次表示。

卷积神经网络(CNN)是深度学习中的关键组件,尤其在图像处理中表现出色。BP在CNN中的应用以及预训练技术如PCA-Net、卷积自编码器、卷积RBM和卷积稀疏编码(DeconvolutionNN)等,都极大地提升了模型的性能。同时,CNN的改进策略不断涌现,如maxout、dropout、dropconnect和ReLU激活函数等。

循环神经网络(RNN)则在处理序列数据时具有优势,其基本结构和反向传播通过时间(Backpropagation Through Time, BPTT)算法是理解和实现RNN的关键。

在深度学习的实践中,特征可视化是重要的步骤,包括最大化激活值法、采样法、上层权值线性组合法和Deconvolution法。这些方法有助于理解模型内部的工作机制。

深度学习的应用广泛,如在语音识别中的声学模型、图像识别(有监督和无监督)以及自然语言处理(NLP)任务中都有所体现。

对于深度学习的未来,作者提出了几个关键问题,包括为何需要深度?反向传播存在的问题是什么?理论上的挑战?深度学习需要解决哪些问题?以及下一个热门的研究方向是什么?

最后,作者提供了深度学习相关的学习资料,帮助读者深入探索这个领域。这篇文档为初学者提供了一个全面的深度学习入门指南。

2020-02-21 上传

2020-07-07 上传

2021-04-02 上传

2021-03-31 上传

2021-03-10 上传

2023-11-07 上传

2021-03-21 上传

2021-03-06 上传

menmodel

- 粉丝: 20

- 资源: 12

最新资源

- zlib-1.2.12压缩包解析与技术要点

- 微信小程序滑动选项卡源码模版发布

- Unity虚拟人物唇同步插件Oculus Lipsync介绍

- Nginx 1.18.0版本WinSW自动安装与管理指南

- Java Swing和JDBC实现的ATM系统源码解析

- 掌握Spark Streaming与Maven集成的分布式大数据处理

- 深入学习推荐系统:教程、案例与项目实践

- Web开发者必备的取色工具软件介绍

- C语言实现李春葆数据结构实验程序

- 超市管理系统开发:asp+SQL Server 2005实战

- Redis伪集群搭建教程与实践

- 掌握网络活动细节:Wireshark v3.6.3网络嗅探工具详解

- 全面掌握美赛:建模、分析与编程实现教程

- Java图书馆系统完整项目源码及SQL文件解析

- PCtoLCD2002软件:高效图片和字符取模转换

- Java开发的体育赛事在线购票系统源码分析