Go语言LocalCache解析:原理与优化

需积分: 0 44 浏览量

更新于2024-08-05

收藏 703KB PDF 举报

"这篇文档是关于LocalCache的学习笔记,主要探讨了LocalCache在解决热key问题中的作用,以及Go语言中常见的几种LocalCache实现,如bigcache、freecache和ccache。文中还提到了LocalCache如何通过分片技术减少锁的竞争和延迟,并介绍了BigCache的内部结构和存储模块的工作原理。"

LocalCache是一种本地高速缓存机制,它并不具备分布式特性,主要用于提升数据读取速度和存储重要但不需要持久化的数据。在面临Redis中的热key问题时,LocalCache能有效缓解系统压力。热key是指访问频率极高的键,过多的热key请求可能导致数据库负载过高,引入LocalCache可以将这些频繁访问的数据缓存在内存中,快速响应请求。

Go语言中有几种常见的LocalCache实现,包括bigcache、freecache和ccache。这些库通常会采用分片技术来降低并发访问时锁的争用,提高性能。分片技术通常是通过哈希算法将数据均匀分布到多个小的缓存区域,这里提到的分片x必须是2的幂次方,这样可以通过幂运算取余实现均匀分布,公式为hash & (x - 1)。

在Go的垃圾回收机制中,如果map包含大量非指针元素,会导致额外的性能开销。为了解决这个问题,Go的开发者对不包含指针的map进行了优化,使得垃圾回收器可以跳过这些对象,从而提高效率。这种优化使得LocalCache在存储大量轻量级对象时更具优势。

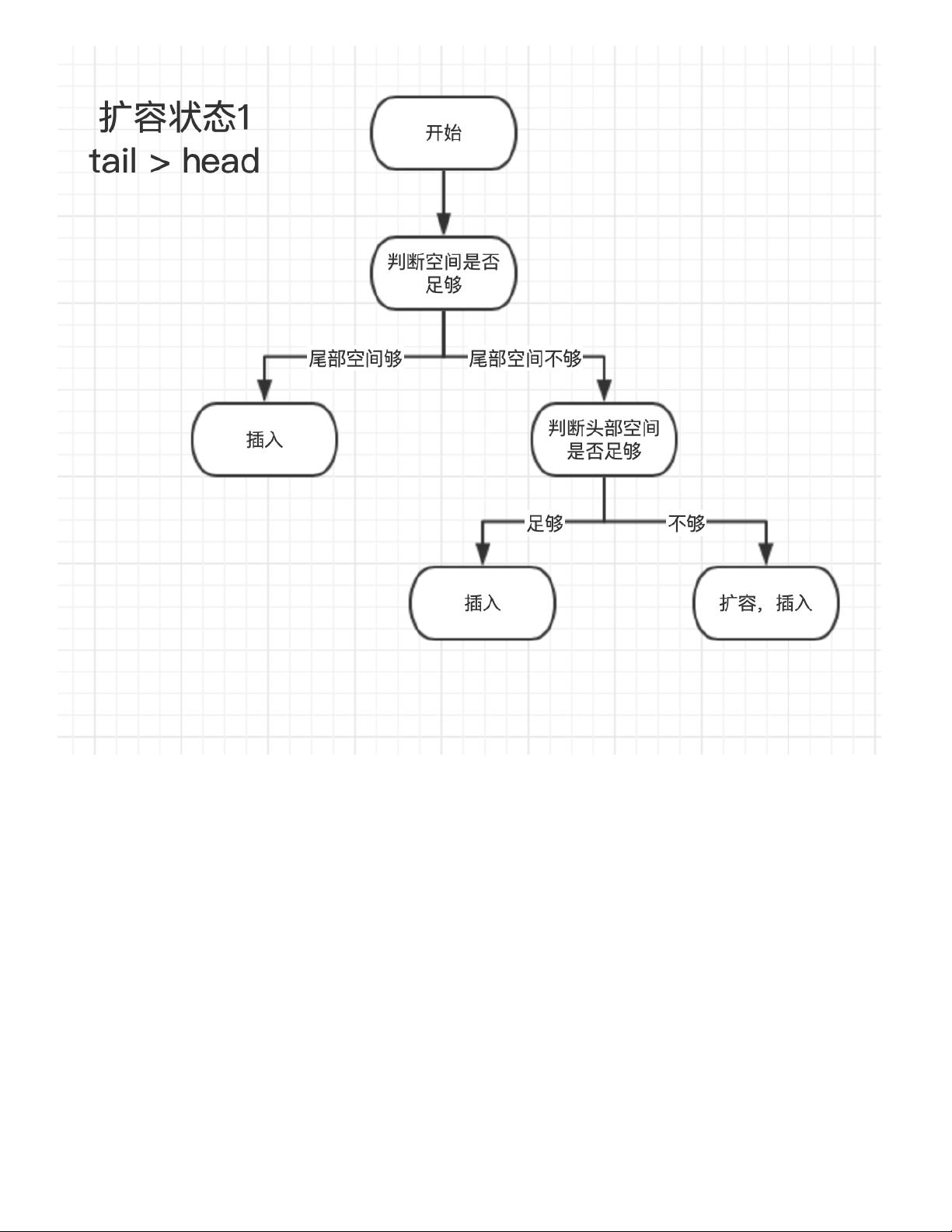

文章特别提到了BigCache,这是一个高效且快速的LocalCache实现。BigCache速度快的原因之一在于它的存储模块设计。BytesQueue是其核心结构,包含了数组、容量、最大容量、头尾索引等字段,用于管理存储空间。BytesQueue在push操作时,会检查是否有可用空间,如果没有,则进行扩容。这种设计确保了在数据写入时的高效性。

LocalCache是提升系统性能的重要工具,Go语言中的实现如bigcache等提供了优化的解决方案,特别是在处理高并发和大量数据时。通过理解其工作原理和内部结构,开发者可以更好地利用这些库来优化自己的应用程序。

1668 浏览量

340 浏览量

2023-09-07 上传

2021-04-03 上传

2021-03-23 上传

152 浏览量

2022-08-08 上传

2021-03-18 上传

2021-06-24 上传

胡说先森

- 粉丝: 711

- 资源: 280

最新资源

- cra-ts-prettier-commitlint-template:CRA模板,具有更漂亮,更沙哑,更出色的提交以及更多现成的设置

- portfolio-template:Jekyll产品组合网站模板,以使用GitHub Pages展示您的工作

- 供应链管理中的库存控制

- jsonviewerpackage.zip

- johnroids:Johnroids是在go,gopherjs和gowasm中实现的旧式小行星游戏

- localSolver:本地求解器的文件。 云托管代码不需要这些

- 供应链管理 供应链管理思想产生

- XCTAssertCrash:使用Mach异常处理程序或POSIX信号处理程序断言表达式崩溃

- kutik

- 47元手把手教你:图像识别的垃圾分类系统.rar

- gp_project:使用遗传编程找到多项式函数

- qrcode_scanner::hammer_and_wrench:Flutter QR码扫描仪插件

- 美赛各题型常见参考代码汇总.zip

- 供应链下的后勤管理

- 7Bot-Arduino-lib:这是7Bot的Arduino库

- 5.9【阿里云天池】零基础入门数据价格:二手车交易价格预测 car-price-forecast-master.zip