Hadoop源码揭秘:分布式与云计算核心技术解析

需积分: 4 66 浏览量

更新于2024-07-21

2

收藏 5.85MB DOC 举报

Hadoop源码分析深入探讨了Google早期核心云计算技术,特别是Hadoop框架如何借鉴和演化自Google的几个关键组件。这些组件包括:

1. **Google Cluster** - Google最初的集群管理技术,为Hadoop的分布式架构提供了灵感,虽然在Apache Hadoop中没有直接对应,但其分布式计算的思想对Hadoop有着深远影响。

2. **Chubby** - 这个轻量级的分布式锁服务,对应于Hadoop中的ZooKeeper,用于协调和管理分布式系统中的数据一致性。

3. **GFS (Google File System)** - 作为分布式文件系统,Hadoop的HDFS(Hadoop Distributed File System)是基于GFS的设计,它提供了高可用性和可扩展性,使得大数据存储变得高效。

4. **BigTable** - 一个分布式数据存储系统,与Hadoop中的HBase类似,都是用于处理大规模结构化数据的数据库。

5. **MapReduce** - Google的并行编程模型,Hadoop MapReduce实现了相同的概念,成为处理海量数据的核心算法,支持批量处理任务。

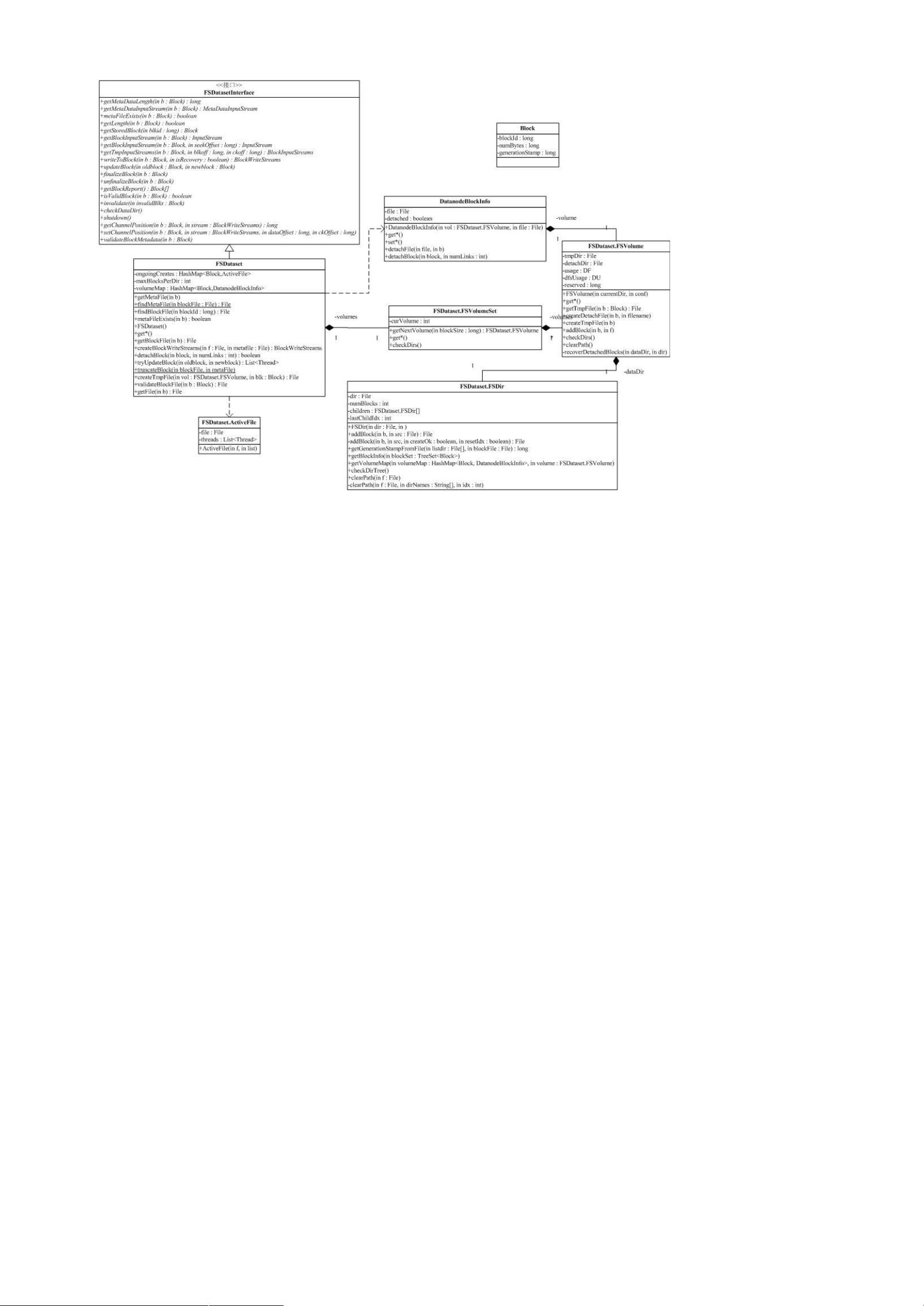

Hadoop的包结构和依赖关系复杂,这源于HDFS的灵活性,它允许用户选择不同的底层实现,如本地文件系统、分布式文件系统或云存储。这种设计导致了不同模块间的紧密耦合,如conf包依赖于fs包,因为系统配置的读取需要利用文件系统功能。Hadoop的核心部分,即图中蓝色部分,主要集中在HDFS和MapReduce上,这两个组件是理解整个框架的关键。

Hadoop的工具包也包含在分析范围内,它们提供了管理和操作Hadoop集群的实用工具。通过深入研究Hadoop源码,开发者可以掌握分布式计算的原理、文件系统设计、任务调度和数据处理的内部逻辑,这对于优化性能、解决故障以及扩展Hadoop生态系统至关重要。同时,理解Hadoop与其他开源项目的关系,如Facebook的Hive,有助于开发者在实际应用中做出更合适的选择和集成。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2011-05-21 上传

107 浏览量

2012-06-19 上传

2011-09-01 上传

2021-03-04 上传

2012-09-09 上传

HaddopRookie

- 粉丝: 2

- 资源: 1

最新资源

- CoreOS部署神器:configdrive_creator脚本详解

- 探索CCR-Studio.github.io: JavaScript的前沿实践平台

- RapidMatter:Web企业架构设计即服务应用平台

- 电影数据整合:ETL过程与数据库加载实现

- R语言文本分析工作坊资源库详细介绍

- QML小程序实现风车旋转动画教程

- Magento小部件字段验证扩展功能实现

- Flutter入门项目:my_stock应用程序开发指南

- React项目引导:快速构建、测试与部署

- 利用物联网智能技术提升设备安全

- 软件工程师校招笔试题-编程面试大学完整学习计划

- Node.js跨平台JavaScript运行时环境介绍

- 使用护照js和Google Outh的身份验证器教程

- PHP基础教程:掌握PHP编程语言

- Wheel:Vim/Neovim高效缓冲区管理与导航插件

- 在英特尔NUC5i5RYK上安装并优化Kodi运行环境