深度学习模型解析:RNN结构与应用

104 浏览量

更新于2024-08-27

收藏 2.74MB PDF 举报

"本文主要介绍了深度学习模型的基本结构,特别是循环神经网络(RNN)的原理和应用。文章深入浅出地阐述了RNN的工作机制,以及它在处理序列数据时的优势和挑战,并提到了一些实际应用案例,如简化版的语音识别任务。"

深度学习模型通常包括三个核心步骤:定义模型、定义损失函数和选择优化方法。在这些步骤中,模型的构建是基础,而RNN作为一种适合处理序列数据的模型,尤其在自然语言处理和音频处理等领域有着广泛的应用。

RNN的设计理念是通过一个函数的反复迭代来处理输入序列。相比于Feedforward Network,RNN能更好地处理较长的序列,因为它通过循环结构减少了参数数量,从而降低了过拟合的风险。然而,这也使得训练RNN相对困难,但一旦在训练数据上取得良好表现,其在测试数据上的表现往往也很稳定。

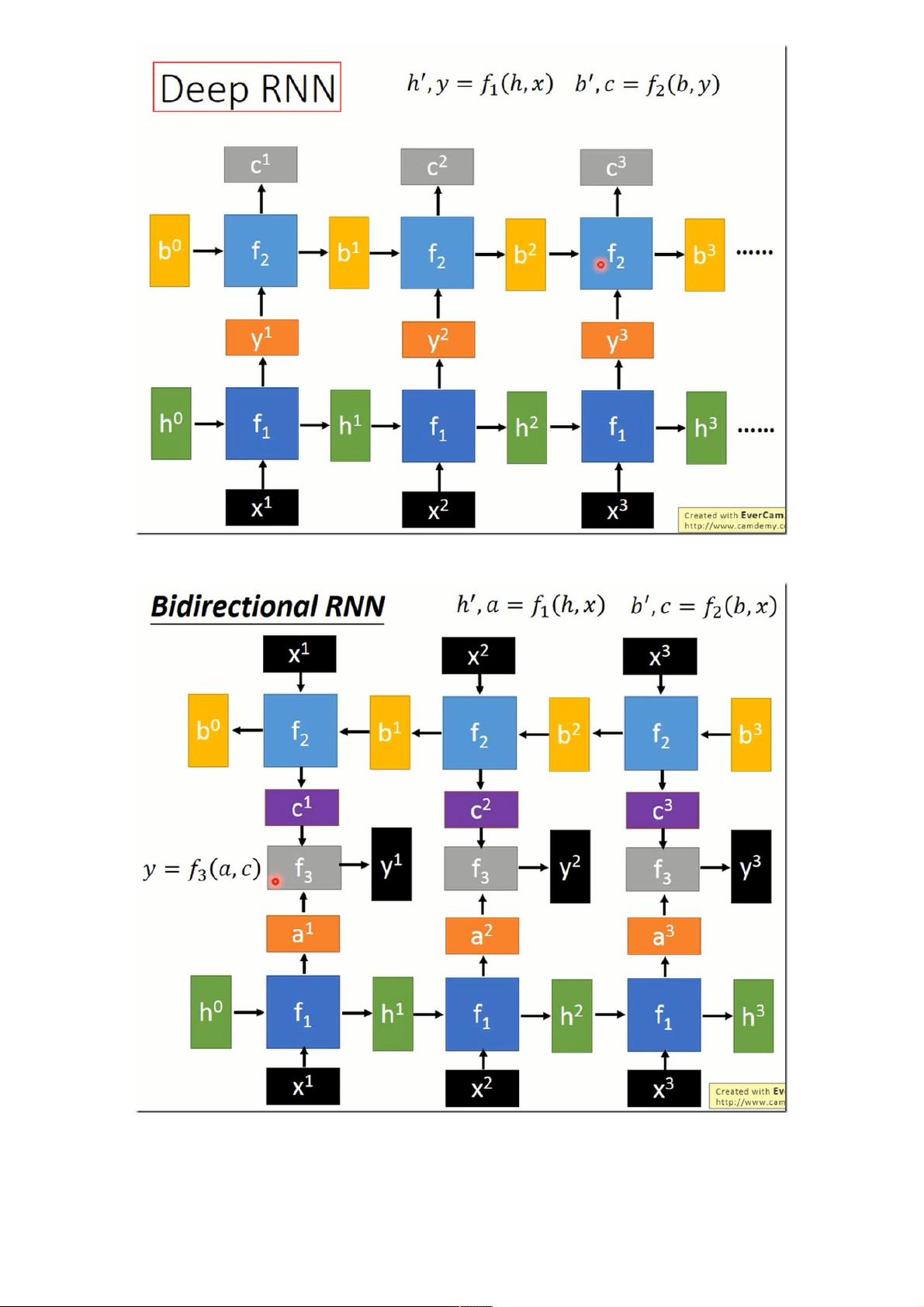

在RNN中,DeepRNN结构需要注意的是,不同层之间的输出和输入维度需保持一致,以便于信息的传递。双向RNN(Bi-RNN)通过同时考虑过去和未来的上下文信息,进一步增强了模型的表达能力。通过结合两个方向的输出,Bi-RNN可以提供更全面的序列理解。

在实际应用中,例如语音识别,RNN常常被用来将连续的音频信号转换为文本。一种常用的技术是双向RNN与多层堆叠,这可以提升模型的训练效率,尤其是在使用金字塔结构时,高层的块可以处理更短的序列,便于并行计算。此外,简化的语音识别任务中,TargetDelay技术用于改善模型的性能,通过在输入序列尾部添加零并延迟标签,帮助模型更好地捕捉时间序列的特征。

RNN的内部机制,如Long Short-Term Memory (LSTM)单元,引入了输入门、遗忘门等机制,允许模型有效地记住长期依赖性,同时控制信息的流动。这种设计解决了传统RNN中的梯度消失或爆炸问题,使得模型能够处理更复杂的序列模式。

RNN是深度学习中处理序列数据的关键模型,它通过循环结构和门控机制实现了对时间序列的建模,广泛应用于自然语言处理、音频识别和时间序列预测等多个领域。理解RNN的工作原理及其变体,对于深度学习从业者来说至关重要。

2021-05-10 上传

2021-06-06 上传

2020-12-21 上传

2021-01-20 上传

2024-09-22 上传

2018-09-23 上传

2021-08-19 上传

2024-05-13 上传

2021-01-06 上传

weixin_38622475

- 粉丝: 0

- 资源: 912

最新资源

- Java集合ArrayList实现字符串管理及效果展示

- 实现2D3D相机拾取射线的关键技术

- LiveLy-公寓管理门户:创新体验与技术实现

- 易语言打造的快捷禁止程序运行小工具

- Microgateway核心:实现配置和插件的主端口转发

- 掌握Java基本操作:增删查改入门代码详解

- Apache Tomcat 7.0.109 Windows版下载指南

- Qt实现文件系统浏览器界面设计与功能开发

- ReactJS新手实验:搭建与运行教程

- 探索生成艺术:几个月创意Processing实验

- Django框架下Cisco IOx平台实战开发案例源码解析

- 在Linux环境下配置Java版VTK开发环境

- 29街网上城市公司网站系统v1.0:企业建站全面解决方案

- WordPress CMB2插件的Suggest字段类型使用教程

- TCP协议实现的Java桌面聊天客户端应用

- ANR-WatchDog: 检测Android应用无响应并报告异常