深度学习:余弦退火与WarmRestart学习率调优详解

版权申诉

深度学习中的学习率规划是优化算法的重要组成部分,本文主要探讨了两种常用的方法——余弦退火(CosineAnnealing)和WarmRestart。这些技术在深度学习模型的训练过程中能够帮助调整学习率,以提高模型性能并防止过早收敛。

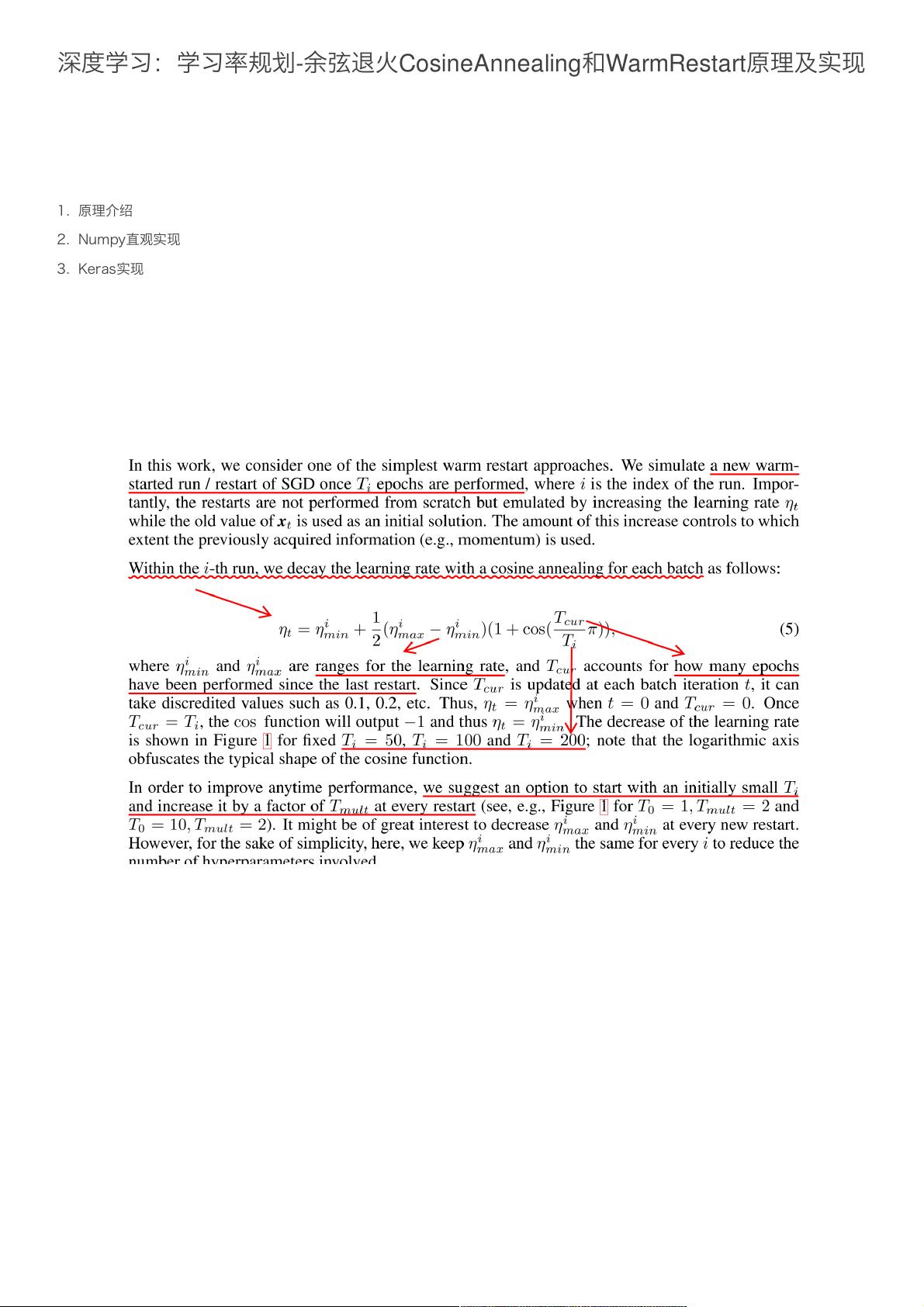

余弦退火是一种基于周期性衰减的学习率策略,其灵感来源于数学中的余弦函数。该方法将学习率在一个固定范围内(由ηmin和ηmax定义)按照余弦函数的周期性规律进行更新。公式(5)中的Tcur表示当前迭代的进度,Ti是完整周期(通常是一个完整的训练周期),η_t 是在每个周期内变化的学习率。这个过程使得学习率在训练初期快速增加,然后逐渐减小,最终再缓慢升高,形成一个类似于余弦波的轨迹。这种学习率策略有助于模型探索更多的参数空间,避免陷入局部最优。

WarmRestart则是另一种学习率调度策略,它每隔一定迭代次数(Ti)就将学习率恢复到初始范围,并重置优化器的状态。这种方法可以看作是定期重启整个学习过程,这样在不同阶段模型可以从不同的起点开始搜索,从而可能找到更好的解决方案。

在Numpy的直观实现中,作者编写了一个名为compute_eta_t的函数,根据给定的参数计算每个迭代步骤的学习率。这个函数利用了Python的math库来计算余弦值,确保了学习率按照预期的周期性衰减。通过这种方式,我们可以观察到学习率随训练过程的变化情况。

实际应用中,特别是在使用深度学习框架如Tensorflow(通过Keras)或Pytorch时,可以利用这些框架提供的内置学习率规划类,简化代码并集成到模型训练流程中。这样,开发者无需从头实现复杂的优化逻辑,可以直接利用现成的功能进行模型训练,提高开发效率。

理解和掌握余弦退火和WarmRestart的学习率规划策略对于深度学习模型的训练至关重要,它们能够提升模型性能,同时提供了一种动态调整学习率的有效手段。通过结合Numpy的可视化和深度学习框架的回调机制,可以更好地理解和运用这些策略。

2021-01-06 上传

2023-06-24 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

2023-07-25 上传

2023-05-29 上传

_webkit

- 粉丝: 30

- 资源: 1万+

最新资源

- 最优条件下三次B样条小波边缘检测算子研究

- 深入解析:wav文件格式结构

- JIRA系统配置指南:代理与SSL设置

- 入门必备:电阻电容识别全解析

- U盘制作启动盘:详细教程解决无光驱装系统难题

- Eclipse快捷键大全:提升开发效率的必备秘籍

- C++ Primer Plus中文版:深入学习C++编程必备

- Eclipse常用快捷键汇总与操作指南

- JavaScript作用域解析与面向对象基础

- 软通动力Java笔试题解析

- 自定义标签配置与使用指南

- Android Intent深度解析:组件通信与广播机制

- 增强MyEclipse代码提示功能设置教程

- x86下VMware环境中Openwrt编译与LuCI集成指南

- S3C2440A嵌入式终端电源管理系统设计探讨

- Intel DTCP-IP技术在数字家庭中的内容保护