PyTorch学习:调整学习率策略详解

28 浏览量

更新于2024-08-31

收藏 265KB PDF 举报

"PyTorch学习笔记,涵盖了调整学习率的几种常见方法,包括StepLR、MultiStepLR、ExponentialLR、ReduceLROnPlateau和LambdaLR。这些方法是PyTorch中torch.optim.lr_scheduler模块提供的,用于优化训练过程。"

在深度学习中,学习率是一个关键参数,它决定了模型在每次参数更新时步进的幅度。正确地调整学习率对于训练过程的效率和最终模型的性能至关重要。PyTorch提供了多种学习率调度策略来帮助我们动态地改变学习率。

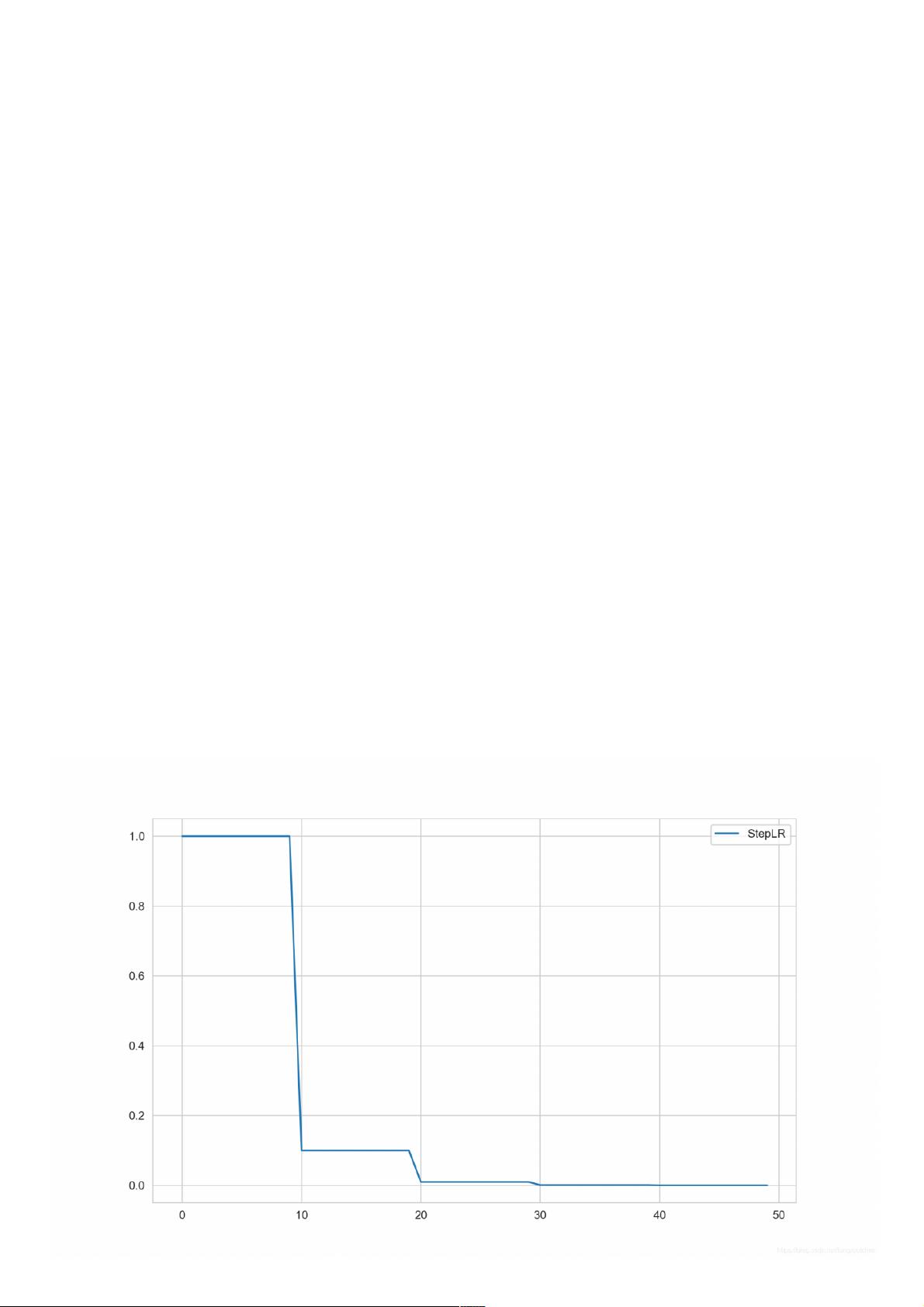

1. **StepLR**

StepLR 是一种简单但有效的学习率调整策略,它按照预设的间隔(step_size)将学习率乘以一个固定的因子(gamma)。例如,在示例中,每10个epoch后,学习率会减少到原来的10%。这种策略适用于训练早期快速收敛,后期需要逐渐减小学习率的情况。

2. **MultiStepLR**

MultiStepLR 允许你在多个特定的epoch点(milestones)上降低学习率,每个点的学习率降低同样比例(gamma)。这给了更多的灵活性,可以针对不同的阶段设置不同的学习率下降点。

3. **ExponentialLR**

ExponentialLR 按照指数方式衰减学习率。在每个epoch,学习率变为初始学习率乘以一个常数因子(gamma),这样可以实现一个更平滑的学习率下降曲线。

4. **ReduceLROnPlateau**

ReduceLROnPlateau 策略根据模型在验证集上的性能变化来调整学习率。如果模型在一定数量的epoch内性能没有提升,学习率会被降低。这个策略旨在防止过早停止训练,允许模型在达到平台期后继续探索。

5. **LambdaLR**

LambdaLR 提供了一个自定义函数,允许用户根据epoch编号直接计算新的学习率。这种方法灵活,可以根据特定问题的需求定制学习率衰减规则。

在实践中,选择哪种学习率调度策略取决于你的具体任务、数据和模型结构。通常,可以先尝试简单的策略如StepLR,然后根据需要逐步引入更复杂的策略。通过可视化学习率的变化,如使用matplotlib或seaborn库绘制学习率随epoch变化的图,可以帮助理解不同策略的效果,并做出相应的调整。记得始终关注训练损失和验证损失,以确保学习率调整有助于模型的收敛和性能优化。

2021-03-15 上传

2022-07-20 上传

2021-01-06 上传

2021-01-20 上传

2022-04-24 上传

2024-03-14 上传

点击了解资源详情

2022-07-11 上传

weixin_38526823

- 粉丝: 5

- 资源: 946

最新资源

- growth-record:学习各种语言和技术的过程记录

- Band-Playlist:一个简单的工具,可为您的果酱会议管理乐队的播放列表。 全部在Angularjs + Firebase中。 应用程序可以离线工作

- kiri-web:基里页面

- johnmansson.github.io:托管

- Druid源码(apache-druid-0.22.1-src.tar.gz)

- 基于Swing+jdbc+mysql的Java图书管理系统.zip

- 教育门户

- joshschmelzle:你好! 我是乔希

- 行业文档-设计装置-一种切葱花专用刀具.zip

- mondora-iron-router-rest-auth:IronRouter插件(可选)对服务器路由进行身份验证

- CloudComputingProject1SingleInstance

- dotandbox:点和盒游戏

- 如何使自己的程序自动更新(在线更新).zip

- airtable-lite:轻型安全的Airtable API客户端

- 广东工业大学 数据库课程设计.zip

- notocjk:适用于Android设备的NotoSansCJK和NotoSerifCJK完整补丁