Transformer模型详解:从Scaled Dot-Product Attention到Multi-Head Attenti...

需积分: 50 175 浏览量

更新于2024-08-05

3

收藏 10.48MB PPT 举报

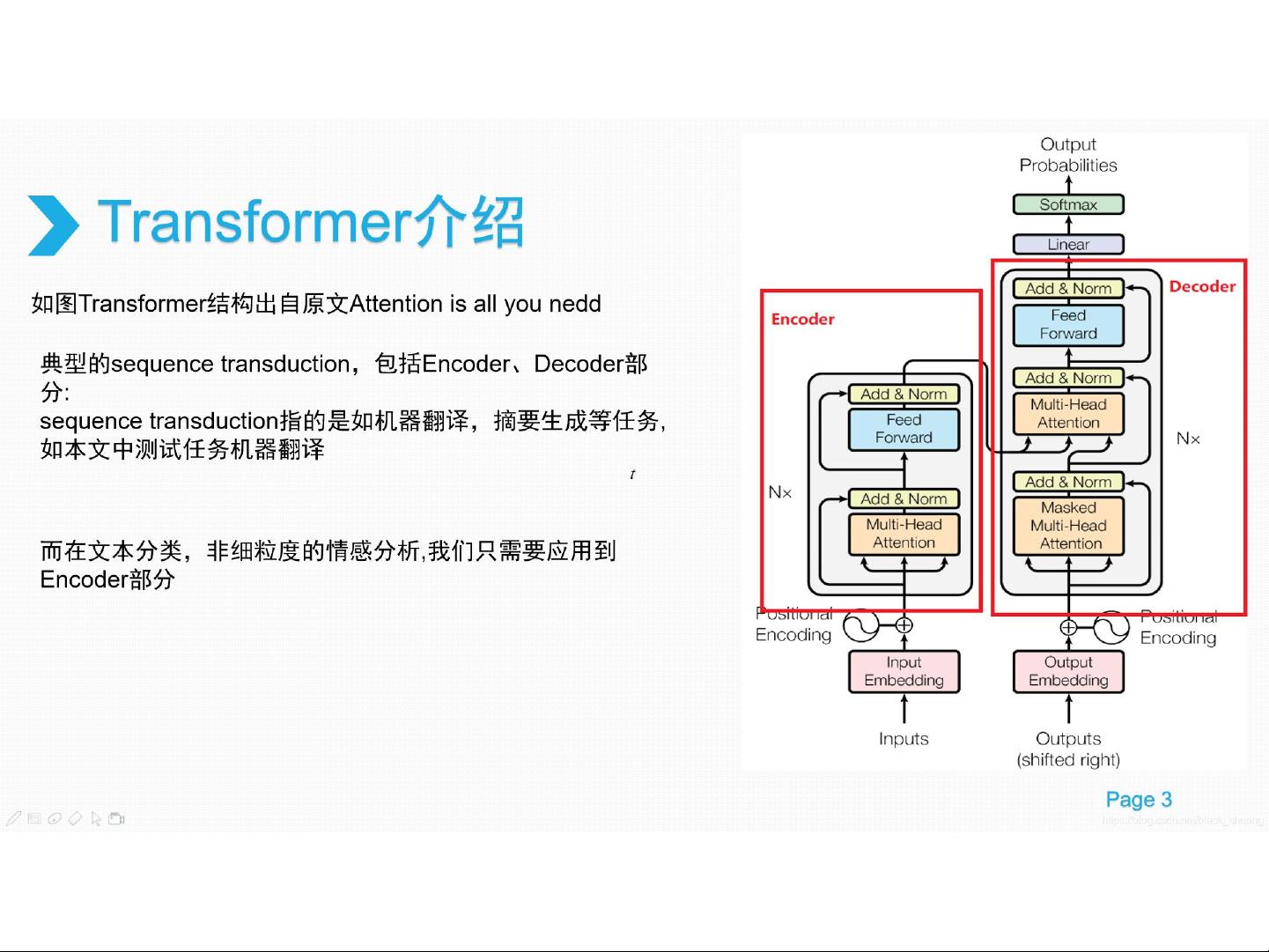

"Transformer.ppt 是一个关于Transformer模型的介绍,涵盖了其提出的背景、Encoder的结构,特别是ScaledDot-Product Attention和Multi-Head Attention的详解,以及Decoder的部分内容。讲解中以实例“华南”演示了如何通过Transformer避免使用递归模型来捕捉上下文信息,并阐述了Scaler、Mask的作用以及Multi-Head的设计原理。此外,还提到了编码和解码过程在实际应用中的示例,如中文到英文的翻译任务。"

Transformer模型是自然语言处理(NLP)领域的一个里程碑,由Google在2017年的论文《Attention is All You Need》中提出。它彻底改变了序列建模的方式,尤其是对于机器翻译和其他依赖长距离依赖的任务。

1. Transformer的提出背景:传统RNN(循环神经网络)和LSTM(长短时记忆网络)在处理长序列信息时存在效率问题,因为它们需要按顺序计算,难以并行化。Transformer通过引入自注意力机制,解决了这一问题,实现了计算的完全并行化,大大提升了训练速度。

2. Encoder的构成:Transformer的Encoder主要由多个相同的层组成,每层包含两个关键组件——Self-Attention(自注意力)和Position-wise Feed-Forward Networks(位置wise前馈网络)。其中,ScaledDot-Product Attention是Self-Attention的一种实现,用于计算不同位置的单词之间的相关性。它通过将查询(Query)、键(Key)和值(Value)进行点积,然后除以一个标度因子,以防止数值过大。

3. ScaledDot-Product Attention的运作:以“华南”为例,查询矩阵Q与所有键矩阵K(包括自身)进行矩阵乘法,得到注意力权重。通过放缩操作可以保持注意力得分在合理范围内,避免数值爆炸。Mask的使用则确保了在计算注意力权重时,当前单词无法“看到”未来单词的信息,以满足序列建模的因果关系。

4. Multi-Head Attention:Transformer利用多头注意力机制,将输入信息映射到多个不同的子空间,每个子空间对应一个头部。这允许模型从不同角度捕获信息,增加了模型的表达能力。n个头部的输出会被拼接起来,再经过线性变换,恢复到模型的原始维度。

5. Decoder部分:Decoder同样由多个层组成,包含Self-Attention层和一个额外的Encoder-Decoder Attention层,用于结合Encoder的上下文信息。在机器翻译等生成任务中,Decoder必须确保生成的序列符合语言规则,因此通常会使用Masking和Future遮挡策略,防止自注意力机制提前泄露未来信息。

6. 应用示例:“我是中国人”到英文的翻译:首先,输入的中文句子经过词嵌入和位置编码,然后通过Encoder得到关键信息。Decoder在生成英文单词时,一方面考虑Encoder的输出,另一方面通过Self-Attention机制参考已生成的英文单词,逐步构建完整的翻译结果。

Transformer的创新在于其高效并行的注意力机制,它在NLP领域的广泛应用,如BERT、GPT等预训练模型,证明了其在理解和生成自然语言方面的强大能力。Transformer不仅革新了序列模型的设计,也对计算机视觉、语音识别等多个领域产生了深远影响。

2022-12-21 上传

2023-06-15 上传

2021-04-22 上传

2009-09-23 上传

2021-05-22 上传

2023-09-19 上传

2022-06-20 上传

2024-01-22 上传

2023-12-26 上传

weixin_53420606

- 粉丝: 0

- 资源: 3

最新资源

- JavaScript实现的高效pomodoro时钟教程

- CMake 3.25.3版本发布:程序员必备构建工具

- 直流无刷电机控制技术项目源码集合

- Ak Kamal电子安全客户端加载器-CRX插件介绍

- 揭露流氓软件:月息背后的秘密

- 京东自动抢购茅台脚本指南:如何设置eid与fp参数

- 动态格式化Matlab轴刻度标签 - ticklabelformat实用教程

- DSTUHack2021后端接口与Go语言实现解析

- CMake 3.25.2版本Linux软件包发布

- Node.js网络数据抓取技术深入解析

- QRSorteios-crx扩展:优化税务文件扫描流程

- 掌握JavaScript中的算法技巧

- Rails+React打造MF员工租房解决方案

- Utsanjan:自学成才的UI/UX设计师与技术博客作者

- CMake 3.25.2版本发布,支持Windows x86_64架构

- AR_RENTAL平台:HTML技术在增强现实领域的应用