Python爬虫解析技术:HTML、JSON与二进制解析

下载需积分: 14 | PPTX格式 | 949KB |

更新于2024-07-16

| 36 浏览量 | 举报

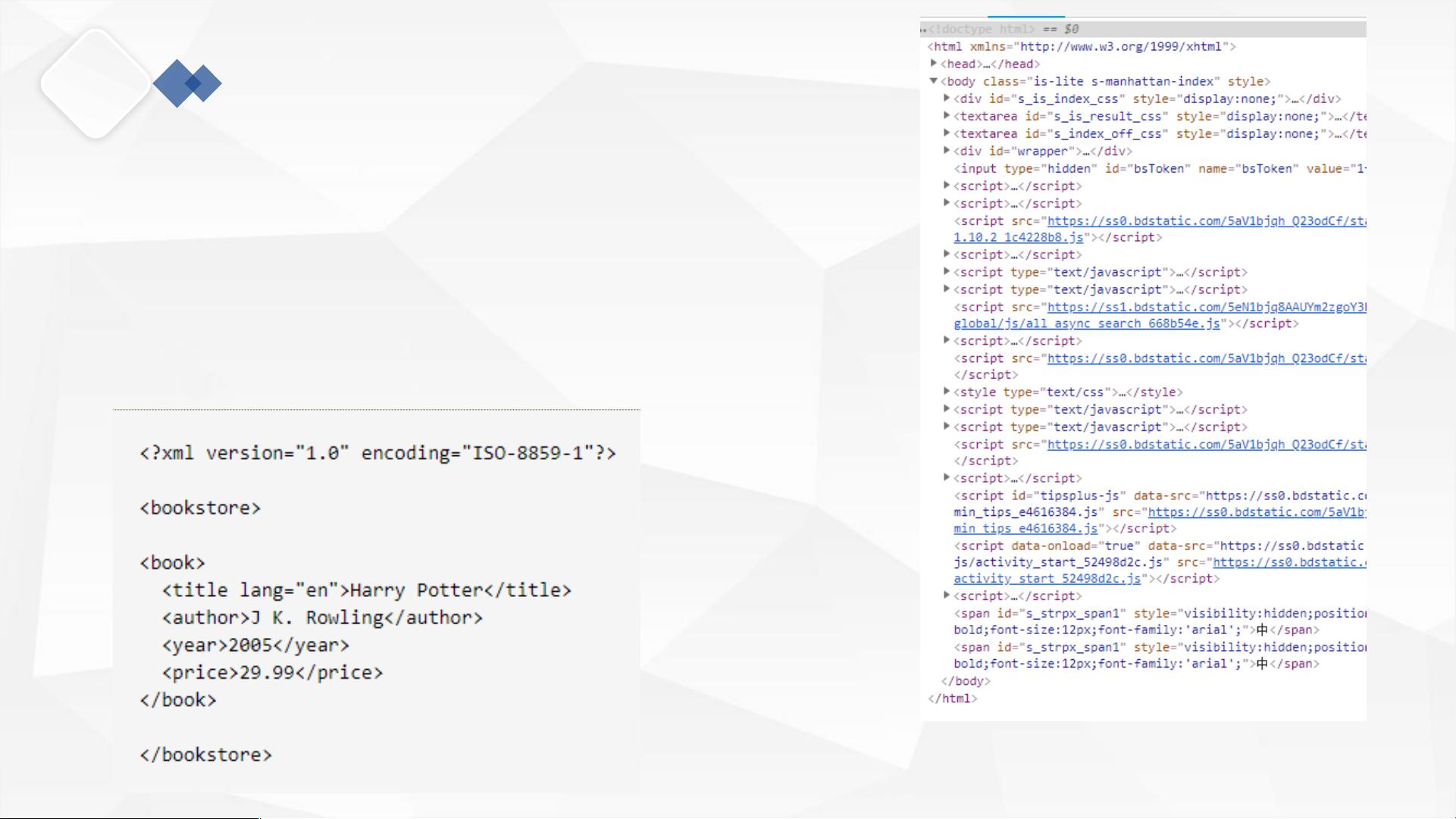

"本资源为Python爬虫实战教程的第三部分,主要讲解如何解析响应内容,包括HTML、JSON和二进制数据的处理。重点介绍了Python中常用的几个库,如urllib.request、urllib.error、urllib.parse和urllib.robotparser,以及lxml、BeautifulSoup和pyquery等用于解析HTML和XML的工具。此外,还涵盖了XPath的基本概念和使用,以及BeautifulSoup的选择器功能。"

在Python爬虫中,解析响应内容是获取网页数据的关键步骤。在本系列的第三部分中,我们关注的是如何解析和处理不同类型的响应内容。首先,介绍了Python标准库中的`urllib`模块,包括`urllib.request`用于发送HTTP请求,`urllib.error`用于处理请求过程中可能出现的异常,`urllib.parse`用于URL的拆分、解析和合并,以及`urllib.robotparser`用于解析网站的`robots.txt`文件,以遵循网站的爬虫规则。

解析HTML是爬虫工作中的常见任务,这里提到了三个强大的库:lxml、BeautifulSoup和pyquery。lxml库支持HTML和XML解析,并且提供了XPath解析方式,XPath是一种在XML文档中查找信息的语言,同样适用于HTML。它定义了七种类型的节点,如元素、属性、文本等,并描述了节点之间的关系,如父节点、子节点等。XPath提供了丰富的路径表达式,使得我们可以方便地定位到所需的数据。

BeautifulSoup则是一个非常流行的HTML和XML解析器,它能将HTML文档转换为树形结构,其中每个节点都有对应的Python对象。这个库提供了简单易用的选择器,如`find_all()`方法,可以根据标签名、属性等条件找到目标节点。它支持Python标准库的HTML解析器以及lxml这样的第三方解析器。

pyquery库则是模仿jQuery的Python实现,用于解析HTML网页,其语法与jQuery非常相似,使得对HTML文档的操作更加直观。

除了HTML,爬虫可能还会遇到JSON格式的响应内容,Python的标准库`json`提供了解析和生成JSON数据的功能。对于二进制数据,如图片或文件,我们需要根据不同的格式进行相应的处理,例如使用PIL库解析图片或使用base64编码解码二进制数据。

Python提供了丰富的库和工具,使我们能够高效地解析和处理爬取的各类数据。理解并熟练运用这些工具,对于提升爬虫项目的效率和准确性至关重要。学习并掌握这些知识点,将有助于你更好地构建和优化Python爬虫项目。

相关推荐

沐呓耳总

- 粉丝: 15

最新资源

- Oracle数据库常用函数全面汇总与解析

- STM32F系列USB虚拟串口VCP驱动在PC端的实现

- 降雨雷达时空匹配的Matlab代码实现及数据准确性验证

- 教学用渐开线画线器设计文档发布

- 前端图像压缩工具:实现无需服务器的图片优化

- Python 2.7.16 AMD64版本安装文件解析

- VC6.0平台下的高斯混合模型算法实现

- 拼音输入辅助工具suggest实现中文提示功能

- Log4jAPI应用详解与配置操作说明

- 官方下载:最新PX4飞控Pixhawk v5硬件原理图

- 楔铁装置设计文档:截断破碎钢筋砼桩、柱或地梁

- 使用PHP实现Alertmanager与SMS API集成的Webhook

- springboot最简项目搭建教程及文件结构解析

- 纯JS实现的数学表达式计算与解析源码

- C#实现二维码生成与摄像头扫描功能

- Hibernate入门实践教程