SparkSQL入门教程:核心特性和优势

需积分: 9 145 浏览量

更新于2024-07-08

收藏 663KB DOCX 举报

"SparkSQL是Spark生态中的SQL计算模块,它提供了与Spark程序集成的SQL查询功能,统一的数据访问接口,对Hive的兼容性以及标准的JDBC/ODBC连接,便于数据处理和BI工具的使用。"

SparkSQL是Apache Spark的一部分,专为处理结构化数据设计。它在SparkCore之上构建,旨在简化数据处理并提高性能。在SparkSQL出现之前,有一个名为Shark的项目,它是基于Hive的,但SparkSQL作为Shark的继任者,不再依赖Hive,而是独立发展,同时保留了Shark的一些特性,如内存中的列存储和动态字节码优化。

SparkSQL的核心特点如下:

1. **Integrated**:SparkSQL允许用户在Spark应用程序中混合使用SQL查询和Spark API,提供了一种统一的编程模型,使得开发人员能够轻松地在SQL和RDD(弹性分布式数据集)之间切换,提高了开发效率。

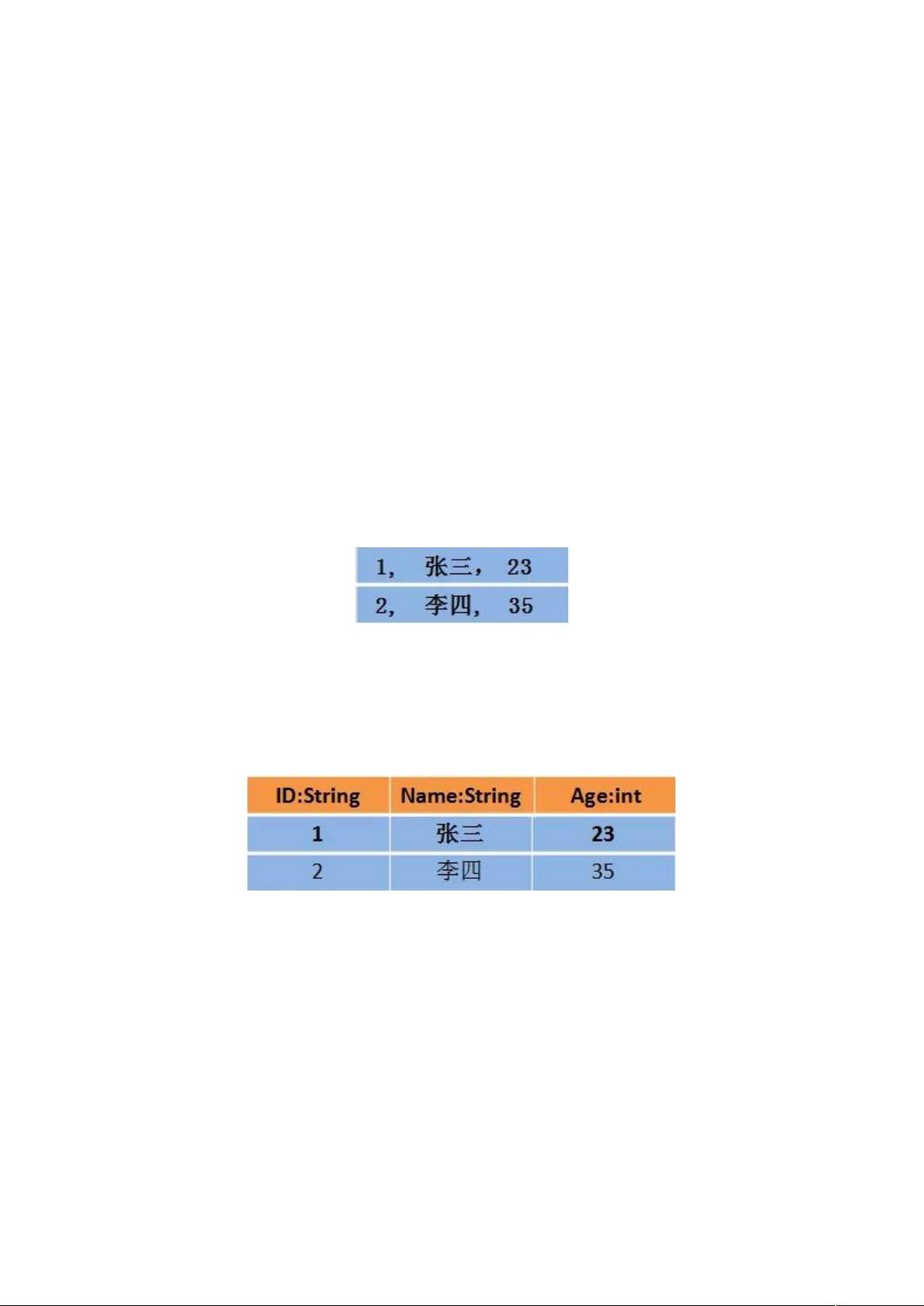

2. **Uniform Data Access**:SparkSQL通过DataFrame和Dataset API实现了统一的数据访问接口。DataFrame是SparkSQL中的主要数据抽象,它表示一个分布式的表格数据集,可以进行复杂的计算。Dataset则为DataFrame提供了类型安全和编译时检查,是DataFrame的强类型版本。

3. **Hive Integration**:SparkSQL支持读取和写入Hive metastore中的数据,这意味着用户可以直接在SparkSQL中使用Hive的表和分区,无需关心底层实现。这对于已经使用Hive的组织来说是一个巨大的优势,因为他们可以无缝地过渡到SparkSQL,利用其更高的性能和灵活性。

4. **Standard Connectivity**:SparkSQL提供JDBC和ODBC驱动,使得传统的BI工具(如Tableau或Excel)能够直接连接到Spark集群,进行数据查询和分析。这扩展了SparkSQL的应用场景,使得它不仅仅局限于编程环境,还可以成为企业数据仓库的一部分。

SparkSQL处理的是结构化数据,即具有固定模式的数据,如传统的关系型数据库中的数据。与之相对的是半结构化数据(如XML、JSON),和非结构化数据(如音频、图像和文本)。由于SparkSQL能够处理DataFrame和Dataset,因此它也能够处理一些半结构化数据,尤其是当这些数据可以转换成表格形式时。

在编程方面,SparkSQL支持Scala、Java、Python和R语言,允许开发人员使用他们熟悉的语言来编写SQL查询。此外,它还支持SQL DDL(数据定义语言)和DML(数据操纵语言),可以创建、修改和查询数据表。

总而言之,SparkSQL是Spark生态系统中的一个重要组件,它通过提供高效、灵活且易于使用的SQL接口,极大地增强了Spark处理结构化数据的能力,同时保持了与现有数据基础设施(如Hive)的良好兼容性。这使得SparkSQL成为大数据处理和分析的理想选择。

2015-12-09 上传

2022-07-02 上传

2020-06-12 上传

AYXYSYS

- 粉丝: 10

- 资源: 30

最新资源

- JavaScript实现的高效pomodoro时钟教程

- CMake 3.25.3版本发布:程序员必备构建工具

- 直流无刷电机控制技术项目源码集合

- Ak Kamal电子安全客户端加载器-CRX插件介绍

- 揭露流氓软件:月息背后的秘密

- 京东自动抢购茅台脚本指南:如何设置eid与fp参数

- 动态格式化Matlab轴刻度标签 - ticklabelformat实用教程

- DSTUHack2021后端接口与Go语言实现解析

- CMake 3.25.2版本Linux软件包发布

- Node.js网络数据抓取技术深入解析

- QRSorteios-crx扩展:优化税务文件扫描流程

- 掌握JavaScript中的算法技巧

- Rails+React打造MF员工租房解决方案

- Utsanjan:自学成才的UI/UX设计师与技术博客作者

- CMake 3.25.2版本发布,支持Windows x86_64架构

- AR_RENTAL平台:HTML技术在增强现实领域的应用