深度学习泛化理论:解析神经网络的定量与定性洞察

需积分: 12 7 浏览量

更新于2024-07-16

收藏 323KB PDF 举报

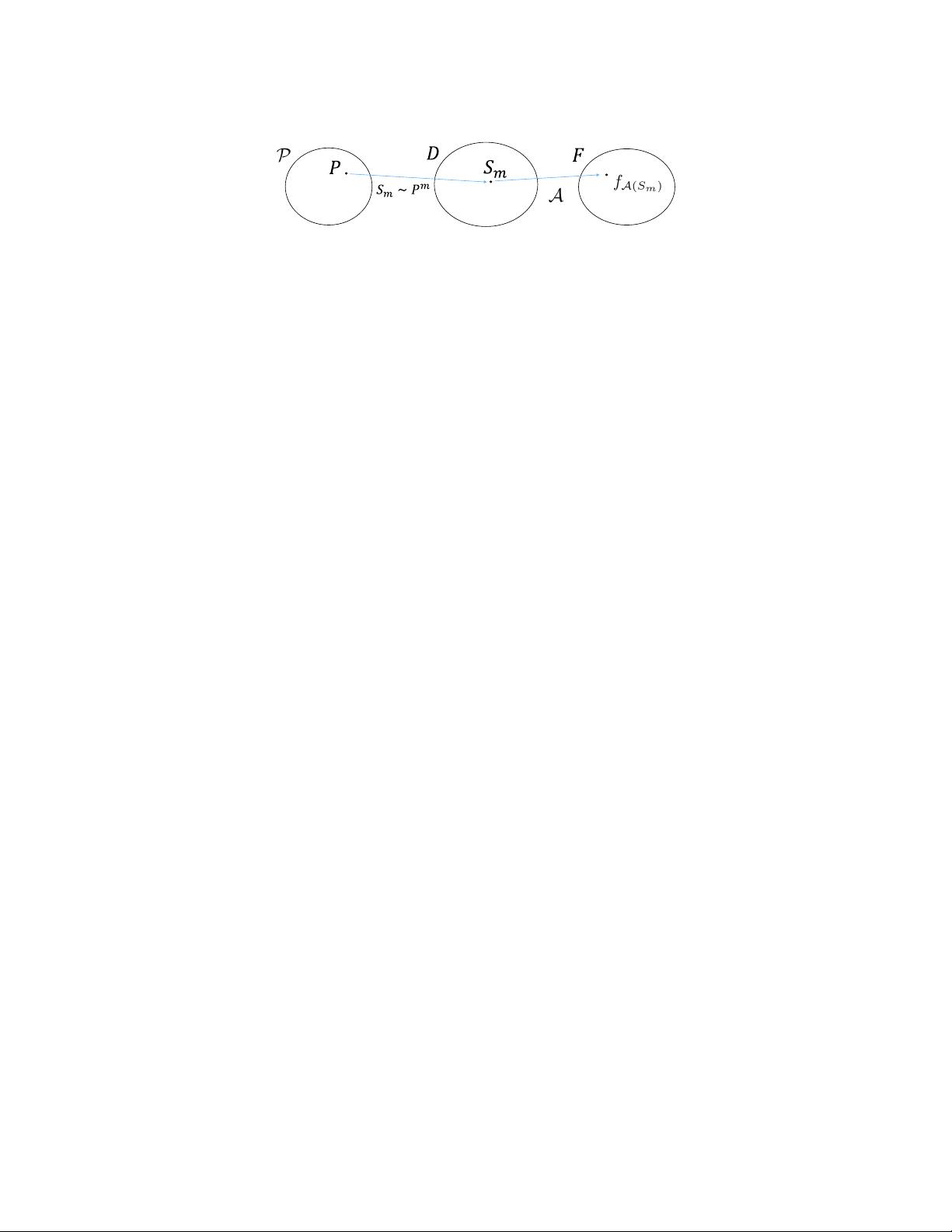

本文档《Generalization in Deep Learning》深入探讨了深度学习的泛化能力,针对深度学习中一个尚未解决的关键问题提供了数学上严谨的理论分析。与之前基于界限的理论不同,该理论对每个具体数据集的泛化性能有定量上的最优性,同时在提供定性洞见方面也具有竞争力。研究的核心成果揭示了深度学习如何在拥有巨大容量、复杂性、潜在算法不稳定性、非鲁棒性和尖锐局部极小值的情况下实现良好泛化,解答了文献中关于深度学习泛化机制的开放性问题。

论文首先回顾了深度学习在实际应用中的显著成功以及它对机器学习和人工智能基础理念的影响。接着,作者指出尽管深度学习取得了显著成就,但其背后的理论挑战依然存在,特别是关于为何和如何在复杂条件下有效泛化的问题。作者通过直接分析神经网络结构,展示了他们的理论是如何在量化上紧致化泛化误差,确保了对不同数据集的一致性和针对性。

本文的主要贡献在于提出了一种新的泛化理论框架,能够精确地量化模型在训练集之外的预测性能,从而更好地理解深度学习模型在面对复杂任务时仍能保持良好性能的原因。这种理论不仅关注模型的统计特性,还考虑了学习过程中的算法行为和优化问题,如权重分布、梯度更新策略等。

然而,文章也指出该理论的局限性,包括可能存在的假设条件、对某些特殊结构或训练方法的适用性以及对于过度拟合和噪声数据的处理。此外,作者并未止步于现有的工作,而是提出了进一步的研究方向,鼓励探索更深层次的泛化机制,比如对抗性样本的鲁棒性、训练数据的质量与数量对泛化的影响等开放性问题。

《Generalization in Deep Learning》这篇论文为深度学习的理论研究做出了重要贡献,它不仅填补了现有泛化理论的一个空白,而且为未来的研究者提供了深入理解和改进深度学习泛化性能的新视角。对于任何致力于深入理解深度学习内在机制的学者或工程师来说,这篇文章都是不可或缺的重要参考资料。

2020-03-29 上传

2020-03-29 上传

2020-11-09 上传

2021-08-17 上传

2023-01-21 上传

2019-09-18 上传

2021-09-26 上传

2021-09-25 上传

2021-09-27 上传

hywcxq

- 粉丝: 0

- 资源: 33

最新资源

- P2PAssess2:Acme 公司类框架

- ASP上传Excel文件并将数据导入到Access数据库

- finalizers:愚蠢的终结者

- calculation_tool_C51_english,c语言华容道源码,c语言项目

- [整站程序]F60在线整站程序_f60.rar

- numeral-systems:Node.js模块,用于通过数字系统类型转换数字

- rebib:从DBLP检索信息并自动更新BibTex文件

- rpi-pico:RPI Pico的MicroPython代码示例

- 负载均衡器

- Gobland 2D-crx插件

- IMAQPLOT - 使用回调预览视频数据:使用处理图形和回调预览图像采集工具箱视频的演示。-matlab开发

- VB光盘管理系统设计(源代码+系统).rar

- road,c语言链队列源码,c语言项目

- TIL:今天我学到了

- 影视金融理财系统_电影投资分红项目_众筹票房分红源码_短信修复+免签支付+搭建教程

- App4UITestToolint-tests-Empty-TC-Add-Tools-2021-04-06T17-25-04.298Z:为工具链创建