深度学习面试攻略:Transformer计算复杂度优化

需积分: 0 81 浏览量

更新于2024-06-15

收藏 1.32MB DOCX 举报

深度学习面试资料旨在帮助候选人全面准备深度学习相关的面试,涵盖了从基础理论到实践技能的多个层面。面试者需要深入理解神经网络的原理,包括但不限于卷积神经网络(CNN)、循环神经网络(RNN)和长短时记忆网络(LSTM),以及它们在图像识别、自然语言处理等领域的应用。此外,Transformer模型作为近年来的重要创新,其计算复杂度的降低方法也是面试中可能涉及的话题。

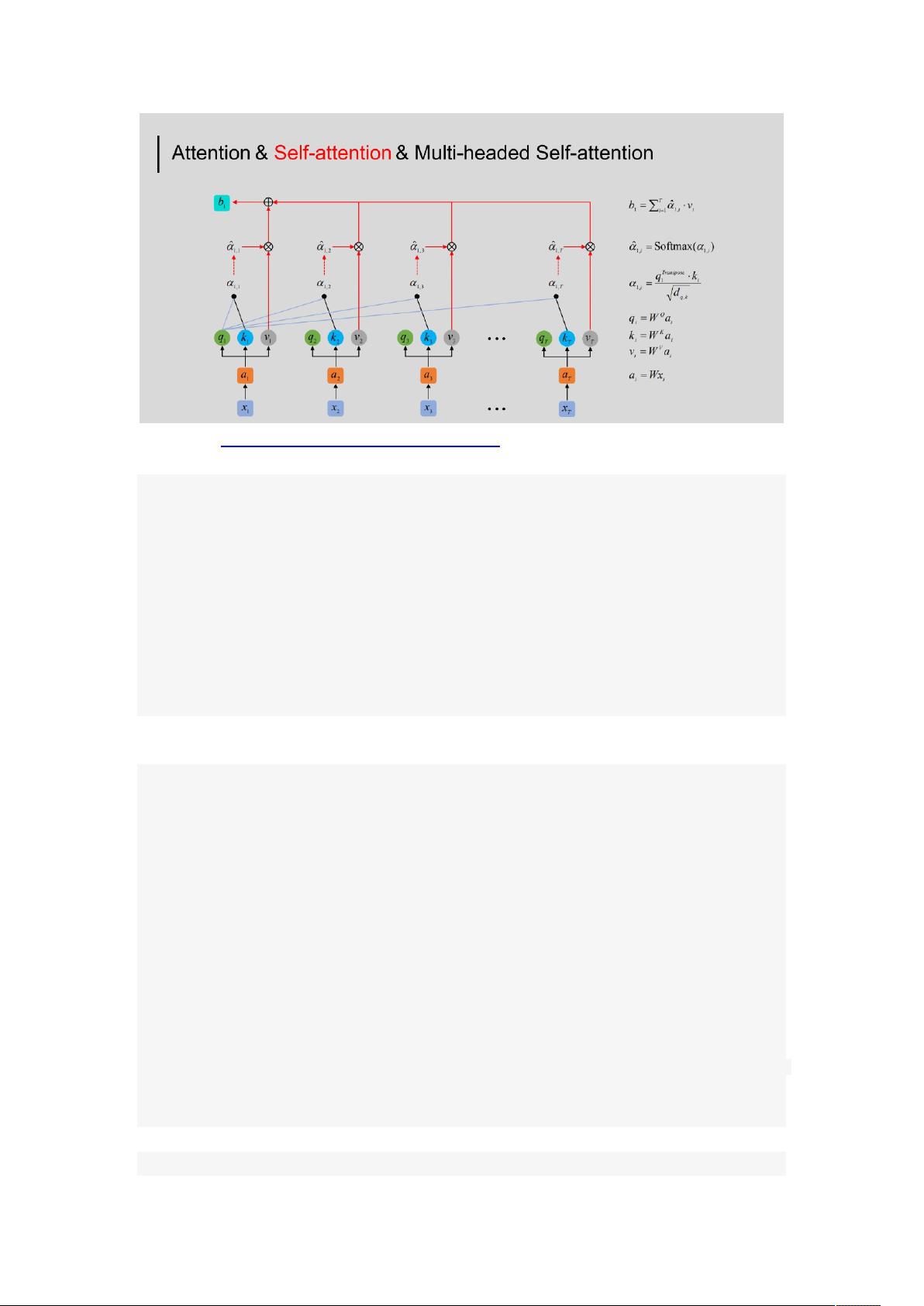

Transformer模型的计算复杂度主要集中在自注意力机制和前馈神经网络上。自注意力机制的计算复杂度为O(n^2d),可以通过下采样、使用稀疏注意力、近似方法(如低秩近似或采样)以及并行计算来降低。而前馈神经网络的计算复杂度为O(nd^2),可以通过降低模型维度、应用压缩技术以及优化矩阵乘法来减少计算需求。

面试中还可能涉及到模型训练和优化的相关问题,例如如何处理过拟合,这可能需要讨论正则化技术(如L1、L2正则化)、dropout策略,以及早停法等。优化器的选择也是重要的一环,常见的有SGD、Adam和RMSprop等,面试者需要理解它们的工作原理和适用场景。另外,损失函数的选择(如交叉熵损失、均方误差损失)和激活函数(如ReLU、Leaky ReLU、sigmoid、tanh)的影响也是面试中常问的问题。

除了理论知识,面试者还需要展示实际操作能力,比如对TensorFlow、PyTorch等深度学习框架的熟悉程度,以及解决实际问题的能力。这可能包括如何构建神经网络模型、如何调试代码、如何利用GPU进行分布式训练等。项目经验的分享也是展示实力的重要方式,能够体现候选人在深度学习项目中的实践经验。

最后,面试者需要对深度学习的最新发展保持关注,能够讨论近期的研究成果,如BERT、GPT系列、Yolo等预训练模型在各个领域的应用,以及在模型压缩、量化、知识蒸馏等方面的新技术。

深度学习面试不仅测试候选人的理论知识,还考察其实践技能、问题解决能力和对最新研究动态的敏感度。全面准备这些方面,才能在竞争激烈的深度学习工程师职位面试中脱颖而出。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2024-03-26 上传

219 浏览量

2021-03-05 上传

2021-09-06 上传

2024-03-27 上传

2022-12-29 上传

fighting的码农(zg)-GPT

- 粉丝: 774

- 资源: 34

最新资源

- 正整数数组验证库:确保值符合正整数规则

- 系统移植工具集:镜像、工具链及其他必备软件包

- 掌握JavaScript加密技术:客户端加密核心要点

- AWS环境下Java应用的构建与优化指南

- Grav插件动态调整上传图像大小提高性能

- InversifyJS示例应用:演示OOP与依赖注入

- Laravel与Workerman构建PHP WebSocket即时通讯解决方案

- 前端开发利器:SPRjs快速粘合JavaScript文件脚本

- Windows平台RNNoise演示及编译方法说明

- GitHub Action实现站点自动化部署到网格环境

- Delphi实现磁盘容量检测与柱状图展示

- 亲测可用的简易微信抽奖小程序源码分享

- 如何利用JD抢单助手提升秒杀成功率

- 快速部署WordPress:使用Docker和generator-docker-wordpress

- 探索多功能计算器:日志记录与数据转换能力

- WearableSensing: 使用Java连接Zephyr Bioharness数据到服务器

已收录资源合集

已收录资源合集