数据回归详解:线性回归与k-NN法

下载需积分: 10 | PDF格式 | 1.7MB |

更新于2024-09-05

| 20 浏览量 | 举报

本资源文档主要探讨了数据回归方法在机器学习中的应用,特别是线性回归和k-近邻回归(k-NN Regression)。标题"Regression.pdf"聚焦于实值输出预测,即如何通过这些技术来逼近给定数据集中的函数关系,并处理异常值以提高模型的鲁棒性。

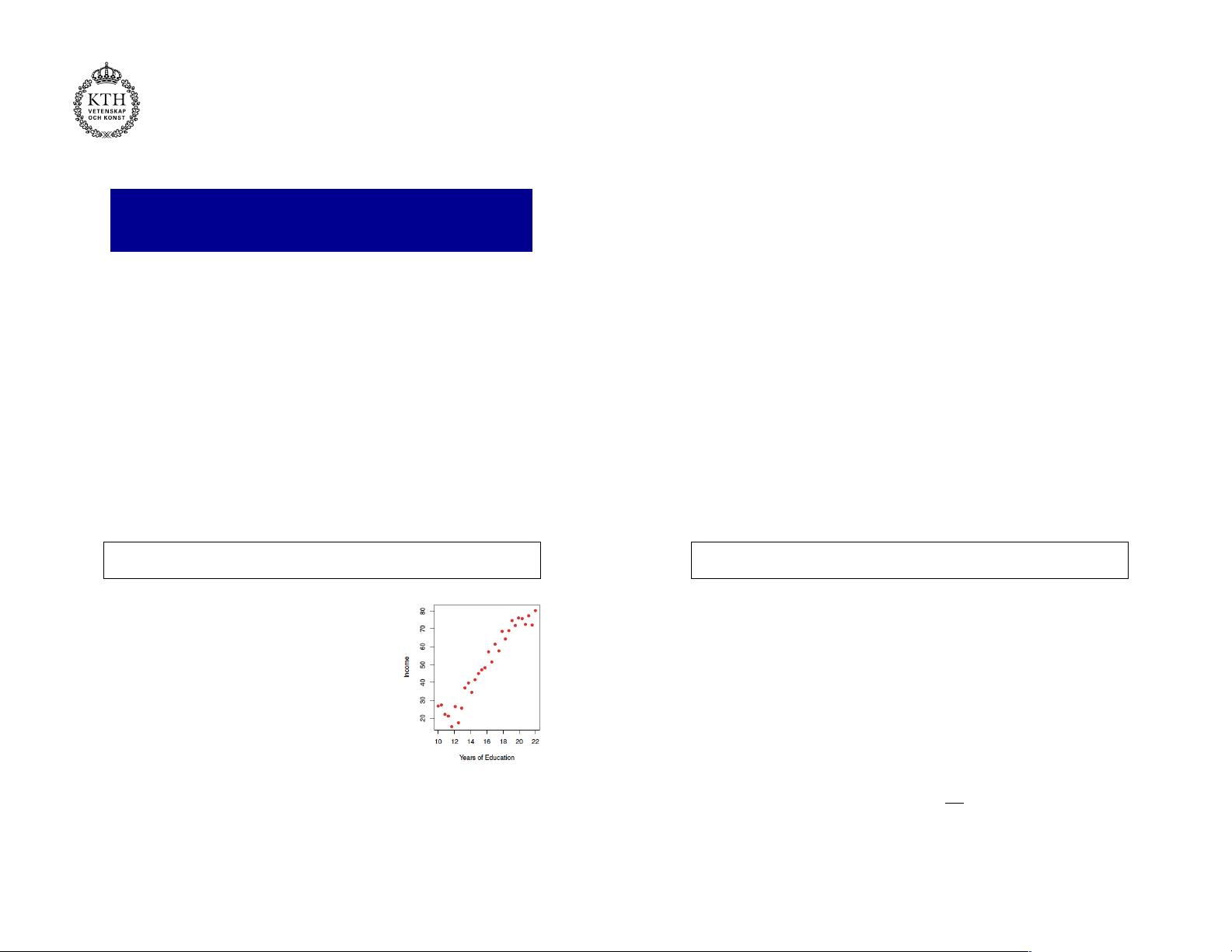

首先,部分介绍了函数逼近的概念,强调回归任务的核心目标是根据输入特征向量(多维度的x)预测对应的输出值。以单个输入特征为例,数据集D由N对输入输出对组成,每个样本(x_i, y_i)都代表实验测量结果。回归的目标是为新的任意输入找到最合适的预测值。

线性回归作为参数化的回归方法,其基本思想是寻找一个最佳拟合直线或超平面,使得所有样本点到该直线的垂直距离平方和最小。这可以通过最小化均方误差(Mean Square Error, MSE)来实现,MSE是预测值与实际值之间差异的平方和除以样本数量的平均值。具体计算公式中,参数w表示拟合线的权重向量,X和Y分别是输入特征矩阵和目标变量向量。

为了确保模型的稳健性,文档提到了一种叫做RANSAC(RANdom SAmple Consensus)的鲁棒回归方法,它能有效地处理数据集中存在的异常值,通过随机抽样和模型拟合来排除异常点的影响,从而得到更稳定的结果。

另一方面,k-NN Regression是一种非参数回归方法,它并不假设数据遵循特定的数学模型,而是依赖于训练集中的邻居点来估计新点的输出。k-NN方法简单直观,但计算成本较高,因为它需要在预测时考虑所有邻近样本的影响。

总结来说,"Regression.pdf"文档涵盖了回归问题的核心概念、线性回归的参数优化以及两种常见回归方法的优缺点。对于博客作者来说,这将提供一个实用的框架,帮助他们解释和应用这些回归技术在实际数据分析和建模场景中。

相关推荐

173 浏览量

42 浏览量

白水煮蝎子

- 粉丝: 78

最新资源

- Subclipse 1.8.2版:Eclipse IDE的Subversion插件下载

- Spring框架整合SpringMVC与Hibernate源码分享

- 掌握Excel编程与数据库连接的高级技巧

- Ubuntu实用脚本合集:提升系统管理效率

- RxJava封装OkHttp网络请求库的Android开发实践

- 《C语言精彩编程百例》:学习C语言必备的PDF书籍与源代码

- ASP MVC 3 实例:打造留言簿教程

- ENC28J60网络模块的spi接口编程及代码实现

- PHP实现搜索引擎技术详解

- 快速香草包装技术:速度更快的新突破

- Apk2Java V1.1: 全自动Android反编译及格式化工具

- Three.js基础与3D场景交互优化教程

- Windows7.0.29免安装Tomcat服务器快速部署指南

- NYPL表情符号机器人:基于Twitter的图像互动工具

- VB自动出题题库系统源码及多技术项目资源

- AndroidHttp网络开发工具包的使用与优势