深度学习超参数调优指南

版权申诉

64 浏览量

更新于2024-06-21

收藏 1.27MB PDF 举报

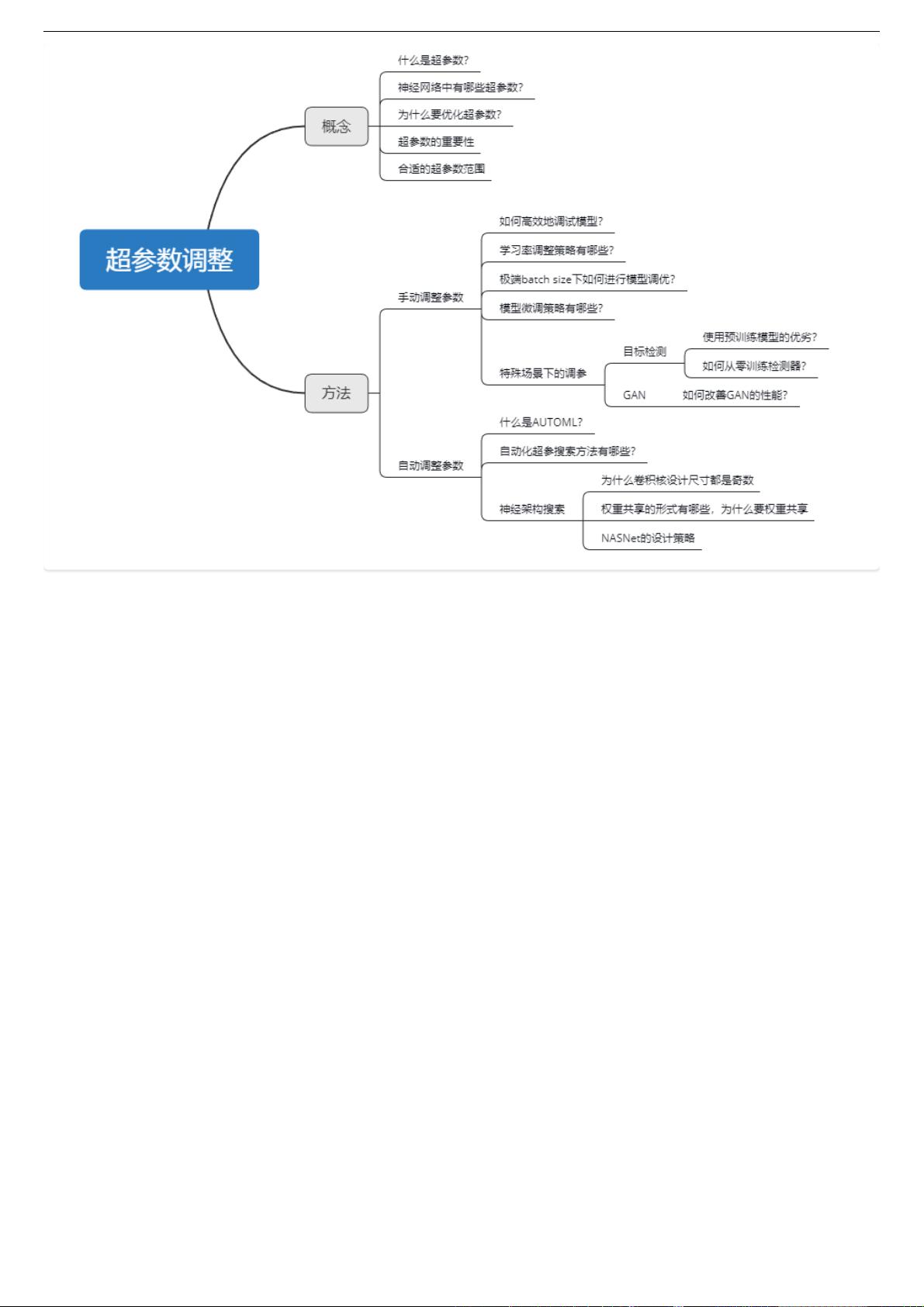

"该资源是一份深度学习教程的第十四章,主要讲解超参数调整的技巧和策略。内容包括超参数的概念、网络训练中的超参数调整策略、预训练网络的合理利用以及如何改善生成对抗网络(GAN)的性能,并简要介绍了自动机器学习(AutoML)和神经网络架构搜索(NAS)的相关内容。"

深度学习是现代人工智能领域的一个关键组成部分,尤其在图像识别、自然语言处理和推荐系统等领域有着广泛的应用。超参数调整是优化模型性能的关键步骤,它直接影响到模型的准确性和泛化能力。

14.2 超参数概念

超参数是在训练模型之前设置的值,它们决定了模型的学习过程和结构。与模型参数(由训练数据学习得到的)不同,超参数不是通过学习过程更新的。常见的超参数包括学习率、批次大小、网络层数、节点数、正则化强度等。

14.2.5 部分超参数如何影响模型性能

- 学习率:控制了模型参数更新的速度,过高可能导致模型震荡不收敛,过低则可能导致训练速度慢且可能陷入局部最优。

- 批次大小:影响模型的训练速度和稳定性,小批次可能导致更高的训练误差波动,大批次则可能错过最优解。

- 正则化强度:用于防止过拟合,过强的正则化可能导致欠拟合,过弱则可能导致过拟合。

14.3 网络训练中的超参调整策略

- 调试模型:通过观察损失函数和验证集上的性能来评估模型状态,可能需要调整超参数以达到更好的平衡。

- 学习率调整:初始学习率的选择很重要,常见的策略有动态调整(如余弦退火)、学习率衰减等。

- 极端批样本数量下训练:小批量可能导致计算效率低下,大批次可能对内存要求高,需要根据实际硬件条件选择。

14.4 合理使用预训练网络

- 微调:利用预训练模型在大规模数据集上学习到的特征,针对新任务进行微调,可以加速学习并提高性能。

- 微调策略:可以全部或部分地微调网络,通常先冻结底层,训练顶层,因为底层特征更通用,顶层更相关于特定任务。

14.5 改善GAN性能

GANs是生成对抗网络的缩写,其训练过程涉及两个神经网络的博弈。优化GAN的策略包括调整生成器和判别器的学习率、使用不同的损失函数或训练算法等。

14.6 AutoML和神经网络架构搜索

- AutoML:自动化机器学习,旨在自动完成模型选择、参数调优等任务,提高效率。

- NAS:神经网络架构搜索,通过自动化方法寻找最优网络结构,如NASNet利用了细胞结构和权重共享来高效搜索。

14.6.6 权重共享和卷积核设计

- 权重共享:在某些网络结构中,如卷积层,同一滤波器的所有权重是共享的,减少了模型复杂性,同时允许学习通用的特征。

- 卷积核尺寸:奇数尺寸的卷积核可以确保中心像素的影响,避免因边界效应导致的不对称问题。

本章内容深入探讨了深度学习中超参数调整的重要性及其实践策略,强调了预训练模型的利用以及如何通过自动化方法提升模型构建的效率。理解并熟练应用这些知识能帮助开发者更好地优化模型,实现更高效的学习和更优的性能。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2023-08-23 上传

2023-08-23 上传

2023-08-23 上传

2023-08-23 上传

2023-08-23 上传

2023-08-23 上传

安全方案

- 粉丝: 2529

- 资源: 3960

最新资源

- typora-themes:我的Typora主题资料库

- 摇滚音乐娱乐网站模板是一款大气单页HTML5网站模板下载。.zip

- 1ere-evaluation-php-sql-site-annonces-immobilieres

- 演示

- Particulate matter Korea-crx插件

- Presenca:用于对Uberhub CodeClub项目进行学术控制的网站。 用Flask制作-Python的微框架-这对组织很有帮助,它经常被成百上千的学生使用

- 清新的韩国风格自然风景下载PPT模板

- Titanic_ML_Competitons:使用Titanic Dataset的ML项目,这是Kaggle的入门比赛(描述为土耳其语,因为该比赛有很多英语来源)

- 工业建筑施工方案模板--余杭区临平塘栖供水二期某水厂工程施工组织设计

- car-rental-php:PHP中的汽车租赁项目

- cppcoffee.github.io:我的github页面

- 红色艺术花纹背景下载PPT模板

- historias_medicas

- block-similarity:通过相似性尝试搜索块

- 简历-求职简历-word-文件-简历模版免费分享-应届生-高颜值简历模版-个人简历模版-简约大气-大学生在校生-求职-实习

- 数据库-应用程序:.BinarySearchTREE-数据库-应用程序