Spark RDD 算子详解:实现原理与执行流程分析

下载需积分: 49 | DOC格式 | 4.64MB |

更新于2024-07-20

| 118 浏览量 | 举报

Spark 1.4.1 RDD 算子详解

Spark RDD(Resilient Distributed Datasets)是 Apache Spark 中的一个基本数据结构,提供了一种基于内存的数据处理方式。RDD 算子是 Spark 中的一种基本操作单元,用于处理和转换 RDD 数据。下面是 Spark 1.4.1 中一些常用的 RDD 算子和它们的实现原理。

1. take(num: Int):take 算子用于从 RDD 中取出指定数量的元素。其实现原理是,Spark 会将 RDD 划分为多个分区,然后从每个分区中取出指定数量的元素,最后将这些元素聚合起来返回给用户。

2. first():first 算子用于从 RDD 中取出第一个元素。其实现原理是,Spark 会将 RDD 划分为多个分区,然后从每个分区中取出第一个元素,最后将这些元素聚合起来返回给用户。

3. sortByKey(ascending: Boolean = true, numPartitions: Int = self.partitions.length):sortByKey 算子用于对 RDD 中的元素进行排序。其实现原理是,Spark 会将 RDD 划分为多个分区,然后对每个分区中的元素进行排序,最后将这些分区聚合起来返回给用户。

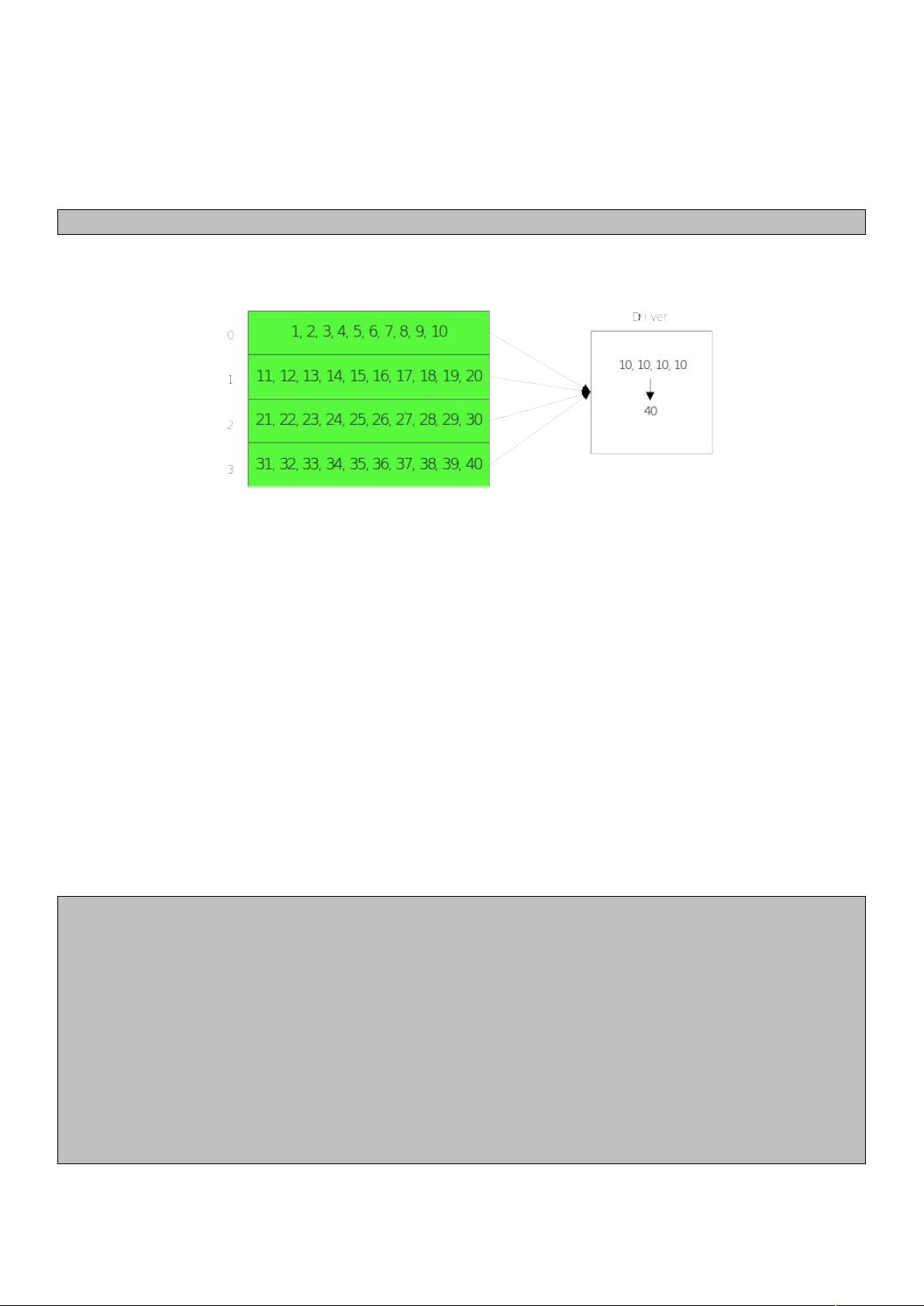

4. count():count 算子用于统计 RDD 中的元素数量。其实现原理是,Spark 会将 RDD 划分为多个分区,然后对每个分区中的元素进行统计,最后将这些统计结果聚合起来返回给用户。

5. countApprox(timeout: Long, confidence: Double = 0.95):countApprox 算子用于近似统计 RDD 中的元素数量。其实现原理是,Spark 会将 RDD 划分为多个分区,然后对每个分区中的元素进行近似统计,最后将这些统计结果聚合起来返回给用户。

6. countApproxDistinct(relativeSD: Double = 0.05):countApproxDistinct 算子用于近似统计 RDD 中的distinct元素数量。其实现原理是,Spark 会将 RDD 划分为多个分区,然后对每个分区中的元素进行近似统计,最后将这些统计结果聚合起来返回给用户。

7. collect():collect 算子用于将 RDD 中的所有元素收集起来返回给用户。其实现原理是,Spark 会将 RDD 划分为多个分区,然后从每个分区中收集元素,最后将这些元素聚合起来返回给用户。

8. toLocalIterator():toLocalIterator 算子用于将 RDD 转换为一个本地迭代器。其实现原理是,Spark 会将 RDD 划分为多个分区,然后对每个分区中的元素进行迭代,最后将这些迭代器聚合起来返回给用户。

9. takeOrdered(num: Int):takeOrdered 算子用于从 RDD 中取出指定数量的有序元素。其实现原理是,Spark 会将 RDD 划分为多个分区,然后从每个分区中取出指定数量的有序元素,最后将这些元素聚合起来返回给用户。

10. max():max 算子用于从 RDD 中取出最大元素。其实现原理是,Spark 会将 RDD 划分为多个分区,然后从每个分区中取出最大元素,最后将这些元素聚合起来返回给用户。

11. min():min 算子用于从 RDD 中取出最小元素。其实现原理是,Spark 会将 RDD 划分为多个分区,然后从每个分区中取出最小元素,最后将这些元素聚合起来返回给用户。

12. aggregate[U: ClassTag](zeroValue: U)(seqOp: (U, T) => U, combOp: (U, U) => U):aggregate 算子用于对 RDD 中的元素进行聚合操作。其实现原理是,Spark 会将 RDD 划分为多个分区,然后对每个分区中的元素进行聚合,最后将这些聚合结果聚合起来返回给用户。

13. fold(zeroValue: T):fold 算子用于对 RDD 中的元素进行折叠操作。其实现原理是,Spark 会将 RDD 划分为多个分区,然后对每个分区中的元素进行折叠,最后将这些折叠结果聚合起来返回给用户。

14. treeAggregate():treeAggregate 算子用于对 RDD 中的元素进行树形聚合操作。其实现原理是,Spark 会将 RDD 划分为多个分区,然后对每个分区中的元素进行树形聚合,最后将这些聚合结果聚合起来返回给用户。

15. reduce(f: (T, T) => T):reduce 算子用于对 RDD 中的元素进行 reduce 操作。其实现原理是,Spark 会将 RDD 划分为多个分区,然后对每个分区中的元素进行 reduce,最后将这些 reduce 结果聚合起来返回给用户。

16. treeReduce(f: (T, T) => T):treeReduce 算子用于对 RDD 中的元素进行树形 reduce 操作。其实现原理是,Spark 会将 RDD 划分为多个分区,然后对每个分区中的元素进行树形 reduce,最后将这些 reduce 结果聚合起来返回给用户。

17. map[U: ClassTag](f: T => U):map 算子用于对 RDD 中的元素进行映射操作。其实现原理是,Spark 会将 RDD 划分为多个分区,然后对每个分区中的元素进行映射,最后将这些映射结果聚合起来返回给用户。

18. mapPartitions[U: ClassTag](f: Iterator[T] => Iterator[U], preservesPartitioning: Boolean = false):mapPartitions 算子用于对 RDD 中的分区进行映射操作。其实现原理是,Spark 会将 RDD 划分为多个分区,然后对每个分区中的元素进行映射,最后将这些映射结果聚合起来返回给用户。

19. mapPartitionsWithIndex[U: ClassTag](f: (Int, Iterator[T]) => Iterator[U], preservesPartitioning: Boolean = false):mapPartitionsWithIndex 算子用于对 RDD 中的分区进行带索引的映射操作。其实现原理是,Spark 会将 RDD 划分为多个分区,然后对每个分区中的元素进行带索引的映射,最后将这些映射结果聚合起来返回给用户。

20. flatMap[U: ClassTag](f: T => TraversableOnce[U]):flatMap 算子用于对 RDD 中的元素进行扁平映射操作。其实现原理是,Spark 会将 RDD 划分为多个分区,然后对每个分区中的元素进行扁平映射,最后将这些映射结果聚合起来返回给用户。

21. filter(f: T => Boolean):filter 算子用于对 RDD 中的元素进行过滤操作。其实现原理是,Spark 会将 RDD 划分为多个分区,然后对每个分区中的元素进行过滤,最后将这些过滤结果聚合起来返回给用户。

22. combineByKey[C](createCombiner: V => C, mergeValue: (C, V) => C, mergeCombiners: (C, C) => C, partitioner: Partitioner, mapSideCombine: Boolean = true, serializer: Serializer = null):combineByKey 算子用于对 RDD 中的元素进行 combine 操作。其实现原理是,Spark 会将 RDD 划分为多个分区,然后对每个分区中的元素进行 combine,最后将这些 combine 结果聚合起来返回给用户。

23. distinct():distinct 算子用于对 RDD 中的元素进行去重操作。其实现原理是,Spark 会将 RDD 划分为多个分区,然后对每个分区中的元素进行去重,最后将这些去重结果聚合起来返回给用户。

在 Spark 中,RDD 算子是非常重要的概念,它提供了一种灵活的方式来处理和转换大规模数据集。通过对 RDD 算子的理解和应用,我们可以更好地处理大规模数据,并提高数据处理的效率和性能。

相关推荐

亮亮-AC米兰

- 粉丝: 233

最新资源

- 安装Oracle必备:unixODBC-2.2.11-7.1.x86_64.rpm

- Spring Boot与Camel XML聚合快速入门教程

- React开发新工具:可拖动、可调整大小的窗口组件

- vlfeat-0.9.14 图像处理库深度解析

- Selenium自动化测试工具深度解析

- ASP.NET房产中介系统:房源信息发布与查询平台

- SuperScan4.1扫描工具深度解析

- 深入解析dede 3.5 Delphi反编译技术

- 深入理解ARM体系结构及编程技巧

- TcpEngine_0_8_0:网络协议模拟与单元测试工具

- Java EE实践项目:在线商城系统演示

- 打造苹果风格的Android ListView实现与下拉刷新

- 黑色质感个人徒步旅行HTML5项目源代码包

- Nuxt.js集成Vuetify模块教程

- ASP.NET+SQL多媒体教室管理系统设计实现

- 西北工业大学嵌入式系统课程PPT汇总