"PySpark_Day04:Mastering RDD Operations"

需积分: 0 153 浏览量

更新于2023-12-28

收藏 4.42MB PDF 举报

PySpark是一个基于Python的大数据处理框架,它提供了丰富的工具和函数来处理大规模的数据集。在PySpark中,RDD(Resilient Distributed Dataset)是最基本的数据结构之一,它是一个不可变的、可并行操作的数据集合,可以被分布式存储在集群中的各个节点上。在PySpark中,我们可以对RDD进行各种操作,包括转换操作和动作操作。

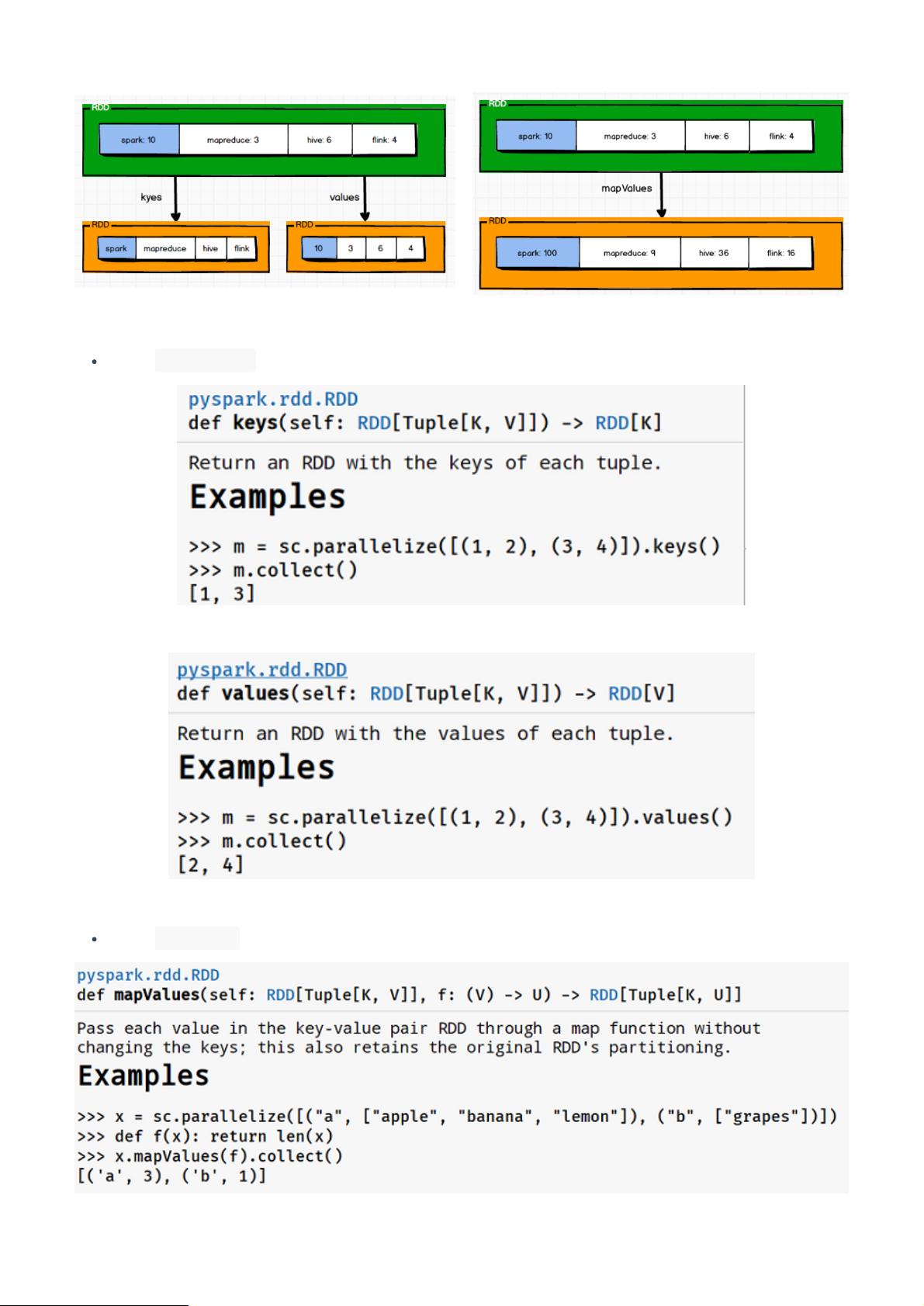

在PySpark中,RDD的转换操作是指对现有的RDD进行一些转换,生成一个新的RDD。这些转换操作是惰性的,即当我们对RDD应用转换操作时,并不会立即执行,而是会生成一个转换操作的执行计划,当我们对生成的新RDD应用动作操作时,才会真正地执行转换操作,并生成结果。在PySpark中,常见的RDD转换操作包括map、filter、flatMap、groupByKey、reduceByKey等。这些转换操作能够帮助我们对大规模的数据集进行高效的处理和分析。

除了转换操作,PySpark中还有动作操作,它们用来触发实际的计算并生成结果。常见的RDD动作操作包括collect、count、reduce、take、saveAsTextFile等。这些动作操作会触发Spark作业的执行,并生成最终的结果。

在本节课中,我们将学习如何使用PySpark进行RDD操作,包括转换操作和动作操作。我们将学习如何使用map和filter对RDD进行转换,如何使用reduce和count对RDD进行动作操作。我们还将深入了解groupByKey和reduceByKey等转换操作的使用场景,并学习如何使用saveAsTextFile将RDD保存到文件中。通过学习本节课的内容,我们将能更加熟练地使用PySpark进行大数据处理和分析。

首先,我们将学习如何使用map和filter对RDD进行转换操作。map操作是一种常见的转换操作,它用于对RDD中的每个元素应用一个函数,将其映射为另一个元素。例如,我们可以使用map操作将RDD中的每个元素都乘以2,从而得到一个新的RDD。filter操作则用于筛选出符合特定条件的元素,生成一个新的RDD。例如,我们可以使用filter操作将RDD中大于10的元素筛选出来。这些转换操作能够帮助我们对大规模的数据集进行高效的处理和转换。

接下来,我们将学习如何使用reduce和count等动作操作对RDD进行操作。reduce操作是一种常见的动作操作,它用于对RDD中的元素进行聚合操作,生成一个最终的结果。例如,我们可以使用reduce操作对RDD中的元素进行累加操作,得到一个最终的累加结果。count操作则用于统计RDD中的元素个数,生成一个最终的计数结果。这些动作操作能够帮助我们对大规模的数据集进行统计和汇总分析。

在本节课的最后,我们还将学习如何使用groupByKey和reduceByKey等转换操作对RDD进行操作。groupByKey操作将RDD中具有相同键的元素进行分组操作,生成一个包含键和对应值列表的新RDD。reduceByKey操作则对具有相同键的元素进行聚合操作,生成一个包含键和聚合结果的新RDD。这些转换操作常用于对包含键值对的RDD进行分组和聚合操作,能够帮助我们进行更加复杂的数据处理和分析。

通过学习本节课的内容,我们将能够更加熟练地运用PySpark进行RDD操作,包括转换操作和动作操作。我们将能够更加高效地对大规模的数据集进行处理和分析,从而能够更好地应对大数据处理和分析的挑战。希望本节课的内容能够帮助大家更好地掌握PySpark的RDD操作,从而能够更加熟练地进行大数据处理和分析工作。

2020-12-20 上传

2023-03-24 上传

2023-03-24 上传

2023-03-24 上传

2023-03-24 上传

2023-03-24 上传

2023-03-24 上传

2021-03-26 上传