循环神经网络详解:裁剪梯度与困惑度

32 浏览量

更新于2024-08-28

收藏 94KB PDF 举报

"循环神经网络基础,包括裁剪梯度和困惑度的概念,以及使用PyTorch实现循环神经网络语言模型的代码示例"

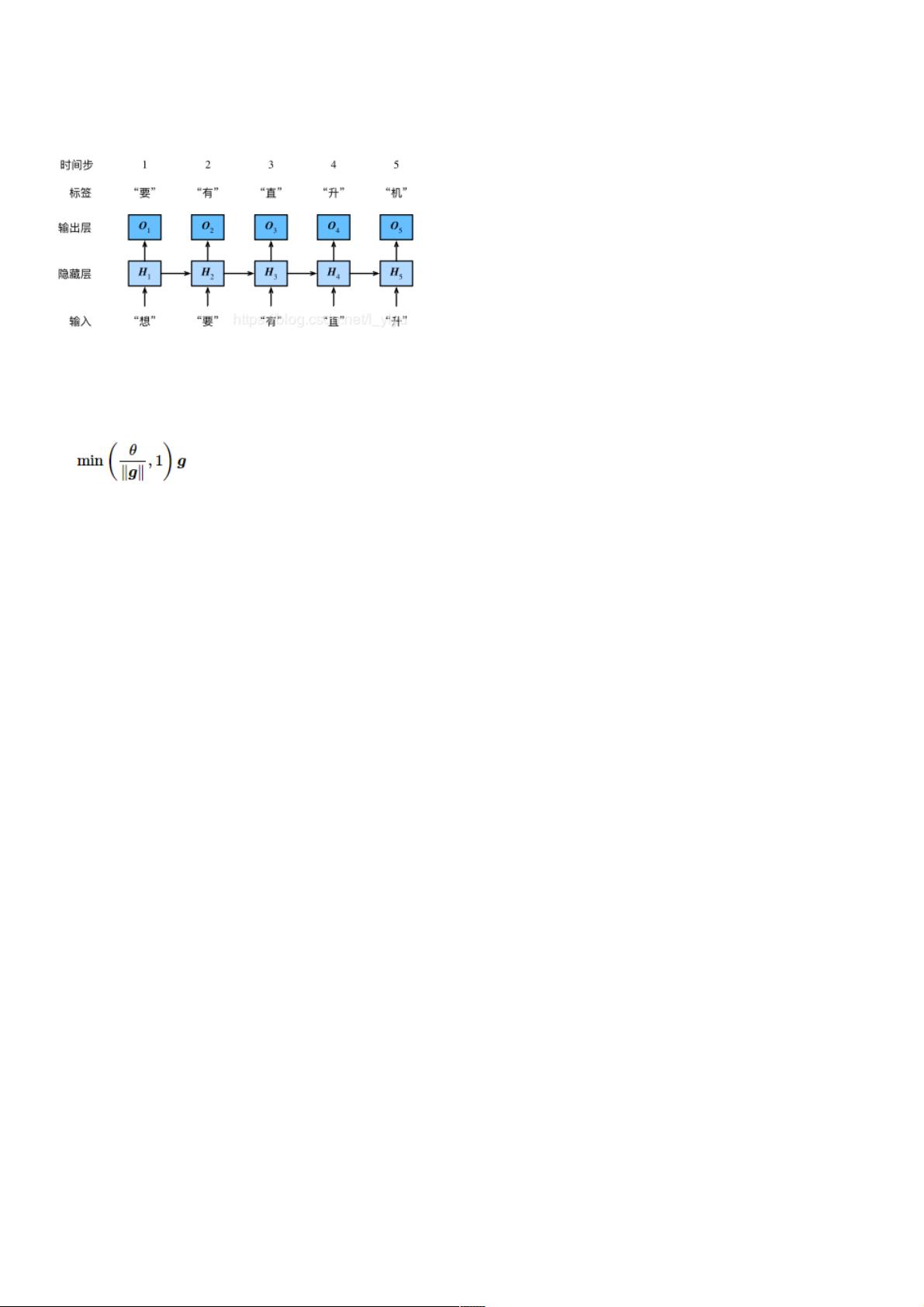

在深度学习领域,循环神经网络(Recurrent Neural Network, RNN)是一种能处理序列数据的强大模型,尤其适用于自然语言处理任务,如语言模型的构建。语言模型的目标是预测给定上下文序列中下一个可能出现的单词。在RNN中,每个时间步的信息通过隐藏状态进行传递,使得模型能够捕获序列中的长期依赖关系。

然而,RNN在训练过程中常常遇到梯度消失和梯度爆炸的问题。梯度消失是指随着序列长度增加,前向传播的梯度逐渐减小,导致网络无法更新远端的权重;梯度爆炸则相反,梯度的值可能变得非常大,使网络不稳定。为了解决这个问题,可以采用裁剪梯度(clip gradient)策略。这种方法限制了所有模型参数梯度向量的L2范数,确保其不超过预设阈值θ。这样可以避免梯度值过大导致的网络震荡,同时也能在一定程度上缓解梯度消失。

评估语言模型性能的一个重要指标是困惑度(perplexity)。困惑度是对交叉熵损失函数指数化的结果,可以看作是模型预测概率分布的平均码字长度。一个理想的模型应该对每个样本的预测都非常确定,即总是正确预测出下一个单词,此时困惑度为1。相反,如果模型的预测总是错误,困惑度将趋向于无穷大。当模型预测所有类别的概率相等时,困惑度等于类别的数量,即词典大小。在实际应用中,一个好的语言模型应有较低的困惑度,表示它对序列的预测能力较强。

在PyTorch中实现循环神经网络语言模型,可以定义一个名为`RNNModel`的类,该类继承自`nn.Module`。在构造函数中,实例化RNN层,并根据是否启用双向RNN计算隐藏层的大小。此外,还需要设置词汇表大小,以便生成合适的输出。以下是一个简化的示例代码:

```python

import torch

from torch import nn, optim

import torch.nn.functional as F

class RNNModel(nn.Module):

def __init__(self, rnn_layer, vocab_size):

super(RNNModel, self).__init__()

self.rnn = rnn_layer

self.hidden_size = rnn_layer.hidden_size * (2 if rnn_layer.bidirectional else 1)

self.vocab_size = vocab_size

# 其他方法,如前向传播、初始化隐藏状态等

```

在实际应用中,还需要定义前向传播函数,处理输入数据,计算损失,并更新模型参数。`d2lzh_pytorch`库提供的`load_data_jay_lyrics`函数用于加载歌词数据集,包括词汇索引和词汇表大小等信息。模型的训练过程通常涉及多个迭代周期,每个周期内处理一个批次的数据,更新模型参数以逐步优化模型性能。

循环神经网络在处理序列数据时展现出强大的潜力,但需要考虑梯度问题的解决方法,以及使用适当的评估指标来衡量模型的性能。通过理解和实践这些概念,我们可以更好地设计和优化RNN模型,以适应各种自然语言处理任务。

167 浏览量

293 浏览量

314 浏览量

2021-09-25 上传

140 浏览量

122 浏览量

131 浏览量

142 浏览量

131 浏览量

weixin_38676851

- 粉丝: 8

最新资源

- 隐私数据清洗工具Java代码实践教程

- UML与.NET设计模式详细教程

- 多技术领域综合企业官网开发源代码包及使用指南

- C++实现简易HTTP服务端及文件处理

- 深入解析iOS TextKit图文混排技术

- Android设备间Wifi文件传输功能的实现

- ExcellenceSoft热键工具:自定义Windows快捷操作

- Ubuntu上通过脚本安装Deezer Desktop非官方指南

- CAD2007安装教程与工具包下载指南

- 如何利用Box平台和API实现代码段示例

- 揭秘SSH项目源码:实用性强,助力开发高效

- ECSHOP仿68ecshop模板开发中心:适用于2.7.3版本

- VS2012自定义图标教程与技巧

- Android新库Quiet:利用扬声器实现数据传递

- Delphi实现HTTP断点续传下载技术源码解析

- 实时情绪分析助力品牌提升与趋势追踪:交互式Web应用程序