Scrapy爬虫框架入门教程

需积分: 3 28 浏览量

更新于2024-08-05

收藏 1.51MB DOCX 举报

"Scrapy爬虫框架笔记"

Scrapy是一个强大的、开源的Python爬虫框架,专为数据抓取和处理而设计。它支持全站爬取,特别适合抓取和处理网页上的大量数据。Scrapy的核心特性在于其异步抓取机制,这使得它在处理多个请求时能高效地并发工作,极大地提高了爬虫的性能。

1.1 Scrapy运行流程

Scrapy的运行流程主要包括以下几个步骤:

1. 发起请求(Request):Scrapy会发送HTTP请求到目标网站。

2. 获取响应(Response):服务器返回的HTML或其他格式的数据会被Scrapy解析。

3. 解析数据:Scrapy使用XPath或CSS选择器等工具从响应中提取所需信息。

4. 存储数据:提取的数据可以被保存到文件、数据库或其他存储介质。

5. 处理链接:Scrapy会检查页面中的链接,决定是否需要对这些链接发起新的请求,以实现深度爬取。

1.2 安装Scrapy

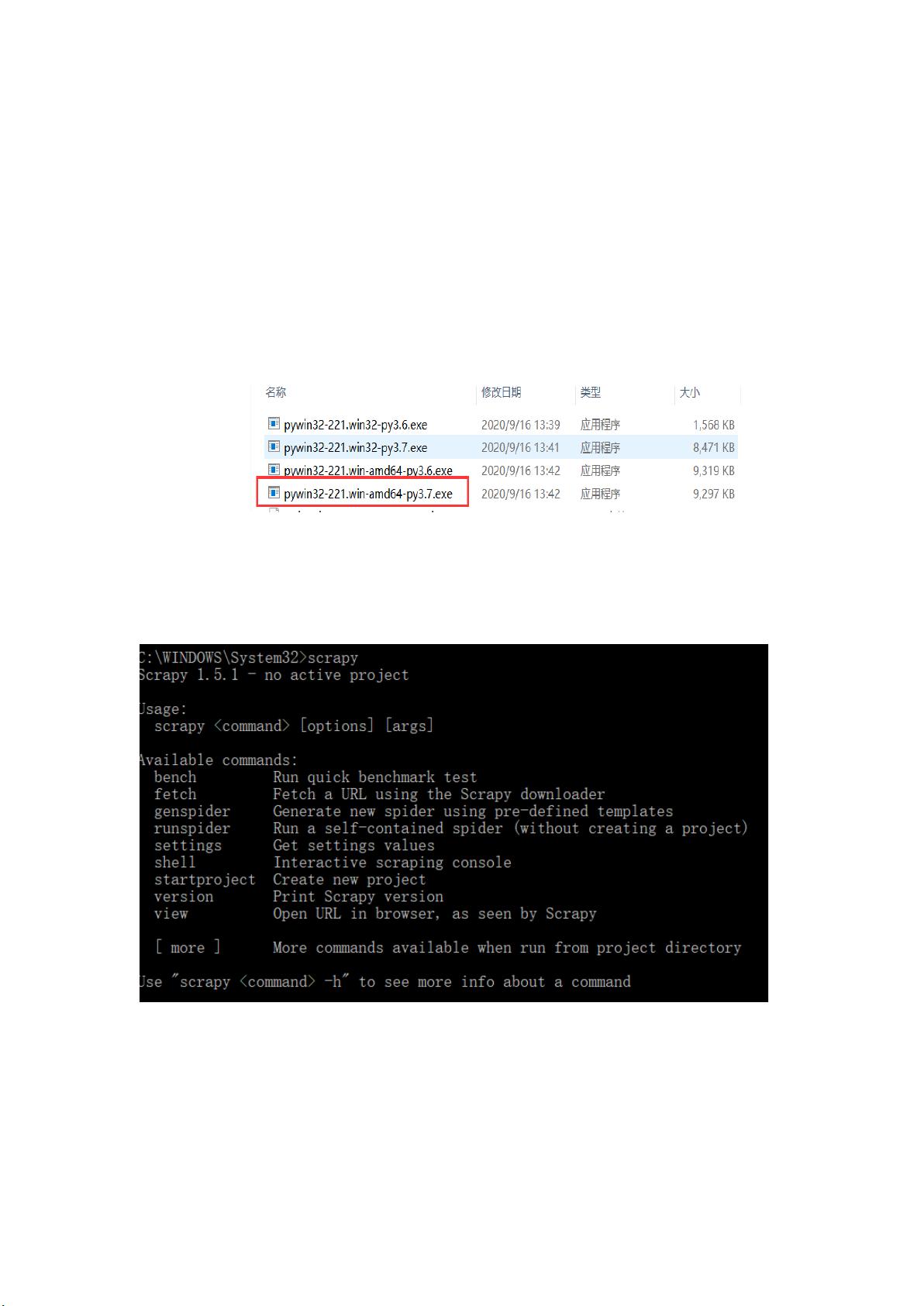

首先,需要确保Python和pip已安装。接着,由于Scrapy依赖于Twisted异步网络通信框架,所以需要从特定的网址下载对应Python版本的Twisted离线安装包,并使用pip进行安装。安装Scrapy时,它会自动处理其他依赖。如果遇到错误,如`SyntaxError: invalid syntax`,可能是因为旧版本的Twisted不兼容Python3的async关键字,此时需要将文件`manhole.py`中的`async`替换为`async1`。若提示缺少`win32api`模块,需安装对应的库。

1.3 Scrapy基本命令

- `scrapy bench`:运行基准测试,检查Scrapy环境是否正常。

- `scrapy fetch`:下载指定URL的网页内容。

- `scrapygenspider`:基于预定义模板创建一个新的爬虫,需要在Scrapy项目内使用。

- `scrapystartproject`:创建一个新的Scrapy项目。

- `scrapy runspider`:运行一个独立的爬虫,不局限于Scrapy项目内的爬虫。

- `scrapy settings`:查看或修改Scrapy项目的配置。

- `scrapy shell`:启动Scrapy的交互式命令行,可用于测试和调试。

- `scrapy view`:在浏览器中打开指定的URL。

1.4 创建Scrapy项目和爬虫

1. 在指定的本地目录下创建一个新的文件夹,例如`D:\zyy`,作为Scrapy项目存放的位置。

2. 使用命令行切换到该目录。

3. 运行`scrapystartproject <project_name>`创建Scrapy项目,其中`<project_name>`是项目名。

4. 生成的项目结构包括`scrapy.cfg`配置文件和其他子目录,如`spiders`、`items`、`pipelines`等。

5. 在`spiders`目录下,使用`scrapygenspider <spider_name> <domain>`创建新的爬虫,`<spider_name>`是爬虫名,`<domain>`是爬取的目标域名。

6. 编写爬虫代码,包括定义爬虫类、设置初始URL、解析方法以及数据处理逻辑。

Scrapy提供了一整套完善的架构,包括中间件、管道、物品(Item)、爬虫(Spider)等组件,便于开发者灵活定制和扩展。通过Scrapy,你可以轻松地构建高效、可维护的爬虫系统,用于抓取互联网上的各种数据。不过,需要注意遵守网站的robots.txt规则和合理使用爬虫,避免对目标网站造成过大负担。

1116 浏览量

570 浏览量

193 浏览量

2023-02-06 上传

130 浏览量

163 浏览量

186 浏览量

277 浏览量

2025-01-09 上传

腾梦

- 粉丝: 7

最新资源

- Premiere Pro CS6视频编辑项目教程微课版教案

- SSM+Lucene+Redis搜索引擎缓存实例解析

- 全栈打字稿应用:演示项目实践与探索

- 仿Windows风格的AJAX无限级树形菜单实现教程

- 乐华2025L驱动板通用升级解决方案

- Java通过jcraft实现SFTP文件上传下载教程

- TTT素材-制造1资源包介绍与记录

- 深入C语言编程技巧与实践指南

- Oracle数据自动导出并转换为Excel工具使用教程

- Ubuntu下Deepin-Wine容器的使用与管理

- C语言网络聊天室功能详解:禁言、踢人与群聊

- AndriodSituationClick事件:详解按钮点击响应机制

- 探索Android-NetworkCue库:高效的网络监听解决方案

- 电子通信毕业设计:简易电感线圈制作方法

- 兼容性数据库Compat DB 4.2.52-5.1版本发布

- Android平台部署GNU Linux的新方案:dogeland体验