图机器学习的公平性和解释性探究

版权申诉

93 浏览量

更新于2024-07-02

收藏 5.78MB PDF 举报

"该文件是图机器学习峰会的讲义,主要探讨了图神经网络(GNN)中的公平性和可解释性问题。"

在图机器学习领域,公平性和可解释性是两个至关重要的主题,特别是在涉及到敏感信息和决策影响的社会应用中。文件首先介绍了公平性的背景,指出机器学习模型,特别是图神经网络,可能存在歧视和偏见问题。以人脸识别为例,研究表明这些技术在处理某些特定群体(如深肤色女性)时表现不佳。

01公平性部分详细讨论了以下几个方面:

- **背景**:强调了由于图数据中节点间的关联性,可能导致具有相同敏感属性(如性别、种族等)的人群被错误地聚类或预测,从而产生不公平的结果。

- **定义**:公平性在机器学习中的不同定义,如统计公平性和个体公平性,这些定义旨在确保模型对所有群体的预测结果是平等的。

- **对抗性去偏**:一种通过引入对抗性训练来减少模型偏见的方法,目的是使模型在处理敏感属性时变得更加公正。

- **公平性约束**:在模型训练过程中添加公平性约束,以限制预测与敏感属性之间的关联性,从而达到更公平的预测。

02可解释性部分探讨了两种方法:

- **后验解释**:如GNNExplainer,这类工具用于解释图神经网络的预测结果,揭示哪些节点和边对最终决策产生了影响。

- **自解释性GNN**:如SE-GNN,这类模型试图在设计阶段就实现内在的可解释性,让模型的决策过程更加透明。

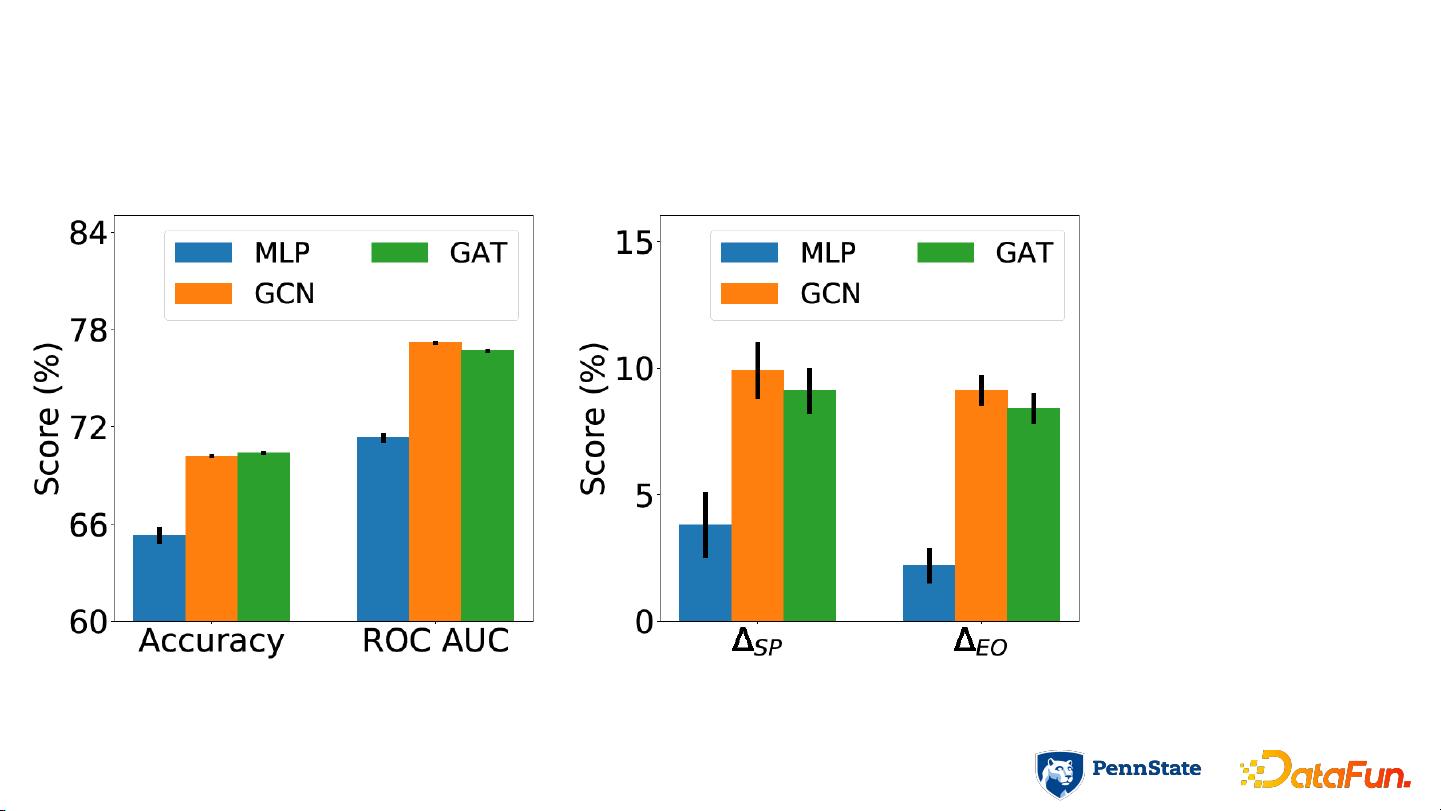

文件通过实验分析展示了图神经网络在Pokec-z数据集上可能存在显著的预测偏差,大Δ表示模型的不公平性。作者提出了一种名为“Say no to the discrimination”的方法,旨在学习公平的图神经网络模型,以降低这种不公平风险。

文件集中讨论了图神经网络如何处理公平性问题以及提供可解释性的策略,这对于开发更加公正且透明的图机器学习模型具有重要意义。在实际应用中,理解和解决这些问题有助于提高模型的可信度和社会接受度。

2022-07-05 上传

2021-04-10 上传

2022-09-23 上传

2021-03-12 上传

2021-02-18 上传

2022-01-05 上传

2021-05-26 上传

2022-07-14 上传

2021-05-06 上传

普通网友

- 粉丝: 13w+

- 资源: 9195

最新资源

- Angular程序高效加载与展示海量Excel数据技巧

- Argos客户端开发流程及Vue配置指南

- 基于源码的PHP Webshell审查工具介绍

- Mina任务部署Rpush教程与实践指南

- 密歇根大学主题新标签页壁纸与多功能扩展

- Golang编程入门:基础代码学习教程

- Aplysia吸引子分析MATLAB代码套件解读

- 程序性竞争问题解决实践指南

- lyra: Rust语言实现的特征提取POC功能

- Chrome扩展:NBA全明星新标签壁纸

- 探索通用Lisp用户空间文件系统clufs_0.7

- dheap: Haxe实现的高效D-ary堆算法

- 利用BladeRF实现简易VNA频率响应分析工具

- 深度解析Amazon SQS在C#中的应用实践

- 正义联盟计划管理系统:udemy-heroes-demo-09

- JavaScript语法jsonpointer替代实现介绍