集成学习与随机森林详解:实例演示与应用

14 浏览量

更新于2024-08-30

收藏 780KB PDF 举报

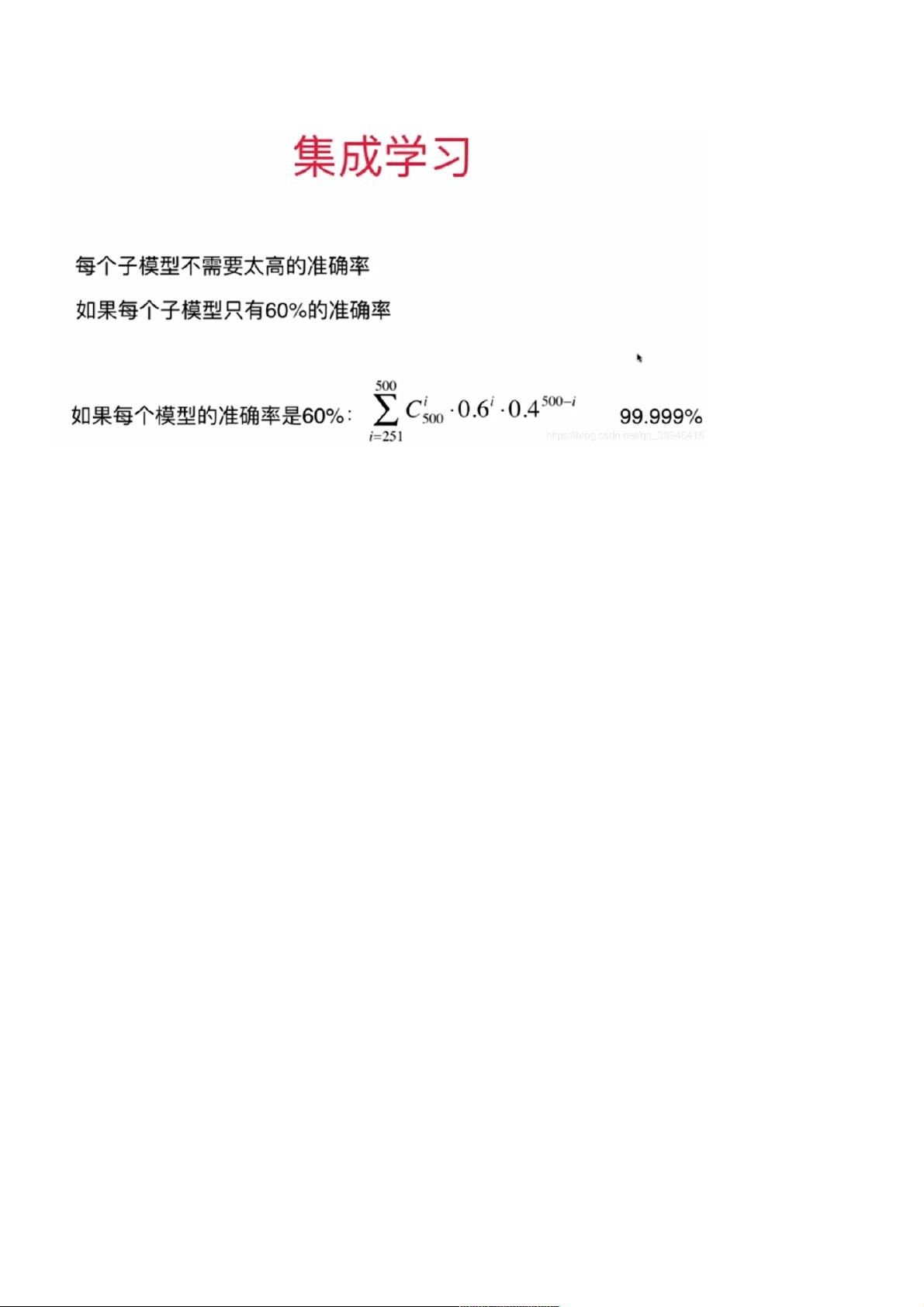

本文主要探讨了机器学习中的一个重要分支——集成学习,以及其中的随机森林算法。集成学习是一种通过组合多个弱学习器(如逻辑回归、支持向量机和决策树)来创建一个强大的强学习器的方法。其核心思想在于,通过提高模型的稳定性和泛化能力,减少单个模型的过拟合风险,从而提升整体预测性能。

首先,我们从基本概念入手。集成学习通常包含以下步骤:

1. **个体学习器生成**:生成一组独立的学习器,每个学习器可能使用不同的算法或参数设置,以便在数据上产生多样性。

2. **结合策略**:有几种常见的结合策略,包括:

- 平均法:对于分类问题,可以取所有学习器预测结果的平均作为最终预测;对于回归问题,取平均值作为输出。

- 投票法:基于多数表决原则,选择预测结果最频繁的类别。

- 学习法:如bagging(自助采样法)或boosting(逐步加强法),前者通过多次重新采样训练集,后者则调整样本权重,逐步强化弱学习器。

接着,文章展示了如何使用Python和scikit-learn库来模拟集成学习的过程。作者从经典的莫尔斯数据集开始,生成了两个类别的样本,并分别绘制出来。然后,使用逻辑回归、支持向量机和决策树三种不同的分类器对数据进行训练和测试:

- **逻辑回归**(Logistic Regression):这是一个线性模型,用于解决二分类问题。

- **支持向量机**(SVM):通过找到最优超平面来最大化分类间隔,适用于多种类型的数据。

- **决策树**(Decision Tree):通过一系列规则或条件判断进行分类,易于理解和解释。

最后,作者将这三个模型的预测结果整合到一起,通过简单的加权平均或投票方式得到集成预测。这种方式虽然简单,但已经在一定程度上体现了集成学习的优势,即通过多个模型的协作,提高整体预测的准确性和稳定性。

总结来说,本文介绍了集成学习的基本原理,重点突出了随机森林作为集成学习的一个实例,以及如何通过Python实践集成学习方法。通过实际操作,读者可以理解集成学习如何通过结合多个模型来提升预测性能,尤其是在面对复杂或噪声数据时。

2024-09-23 上传

2024-05-18 上传

2021-01-27 上传

2024-05-18 上传

2022-10-22 上传

点击了解资源详情

weixin_38671628

- 粉丝: 9

- 资源: 942

最新资源

- SSM动力电池数据管理系统源码及数据库详解

- R语言桑基图绘制与SCI图输入文件代码分析

- Linux下Sakagari Hurricane翻译工作:cpktools的使用教程

- prettybench: 让 Go 基准测试结果更易读

- Python官方文档查询库,提升开发效率与时间节约

- 基于Django的Python就业系统毕设源码

- 高并发下的SpringBoot与Nginx+Redis会话共享解决方案

- 构建问答游戏:Node.js与Express.js实战教程

- MATLAB在旅行商问题中的应用与优化方法研究

- OMAPL138 DSP平台UPP接口编程实践

- 杰克逊维尔非营利地基工程的VMS项目介绍

- 宠物猫企业网站模板PHP源码下载

- 52简易计算器源码解析与下载指南

- 探索Node.js v6.2.1 - 事件驱动的高性能Web服务器环境

- 找回WinSCP密码的神器:winscppasswd工具介绍

- xctools:解析Xcode命令行工具输出的Ruby库